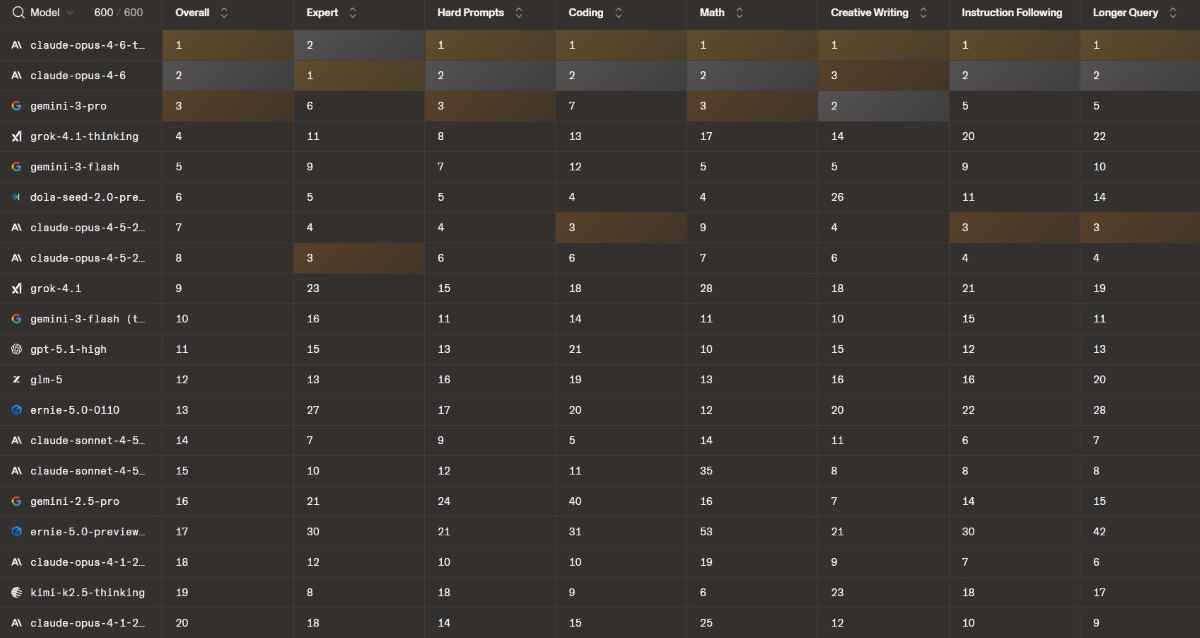

Top 20 des modèles d’IA les plus performants en février 2026 : le classement complet

Google, qui dominait le classement depuis plusieurs mois, perd sa couronne en février au profit de Claude. On fait le point !

Le mois dernier, nous constations un net recul de ChatGPT dans les classements de la LMArena, qui évalue les modèles de langage, tout au long de l’année 2025. Leaders incontestés jusqu’en novembre 2024, les modèles d’OpenAI ont peu à peu perdu du terrain, jusqu’à carrément plonger dans les profondeurs des classements à partir de juillet 2025. Jusqu’ici, c’est Google qui semblait bénéficier de ce coup de mou. Mais en février, la firme se retrouve distancée par un outsider : Anthropic.

Les 10 modèles d’IA les plus performants en janvier 2026

Si les modèles de Gemini se démarquent par leur constance, ceux d’Anthropic se sont révélés plus instables. Mais depuis juin, et le changement de format de la LMArena, l’éditeur de Claude n’a cessé de grimper dans le leaderboard. En février 2026, les modèles Opus 4.6 (et sa version Thinking), dévoilés en début de mois, subtilisent la première place à Gemini 3 Pro. Ils se démarquent dans presque tous les domaines dits « généralistes », comme la réponse aux longues requêtes et aux prompts complexes, l’écriture créative ou encore le suivi d’instruction. Dans le reste du top 10, on retrouve Gemini, solide 3e, mais également Grok et Dola.

Les modèles d’OpenAI sont donc, pour le 2e mois consécutif, exclus du top 10. Ce dernier voit également disparaître le chinois Ernie, développé par Baidu, confirmant l’hégémonie totale des sociétés étasuniennes sur le secteur.

Voici les dix modèles les plus performants du marché, toutes tâches confondues, en février 2026 :

- Claude Opus 4.6 « thinking »

- Claude Opus 4.6

- Gemini 3 Pro

- Grok 4.1 « thinking »

- Gemini 3 Flash

- Dola Seed 2.0 Pro

- Claude Opus 4.5 « thinking »

- Claude Opus 4.5

- Grok 4.1

- Gemini 3 Flash « thinking »

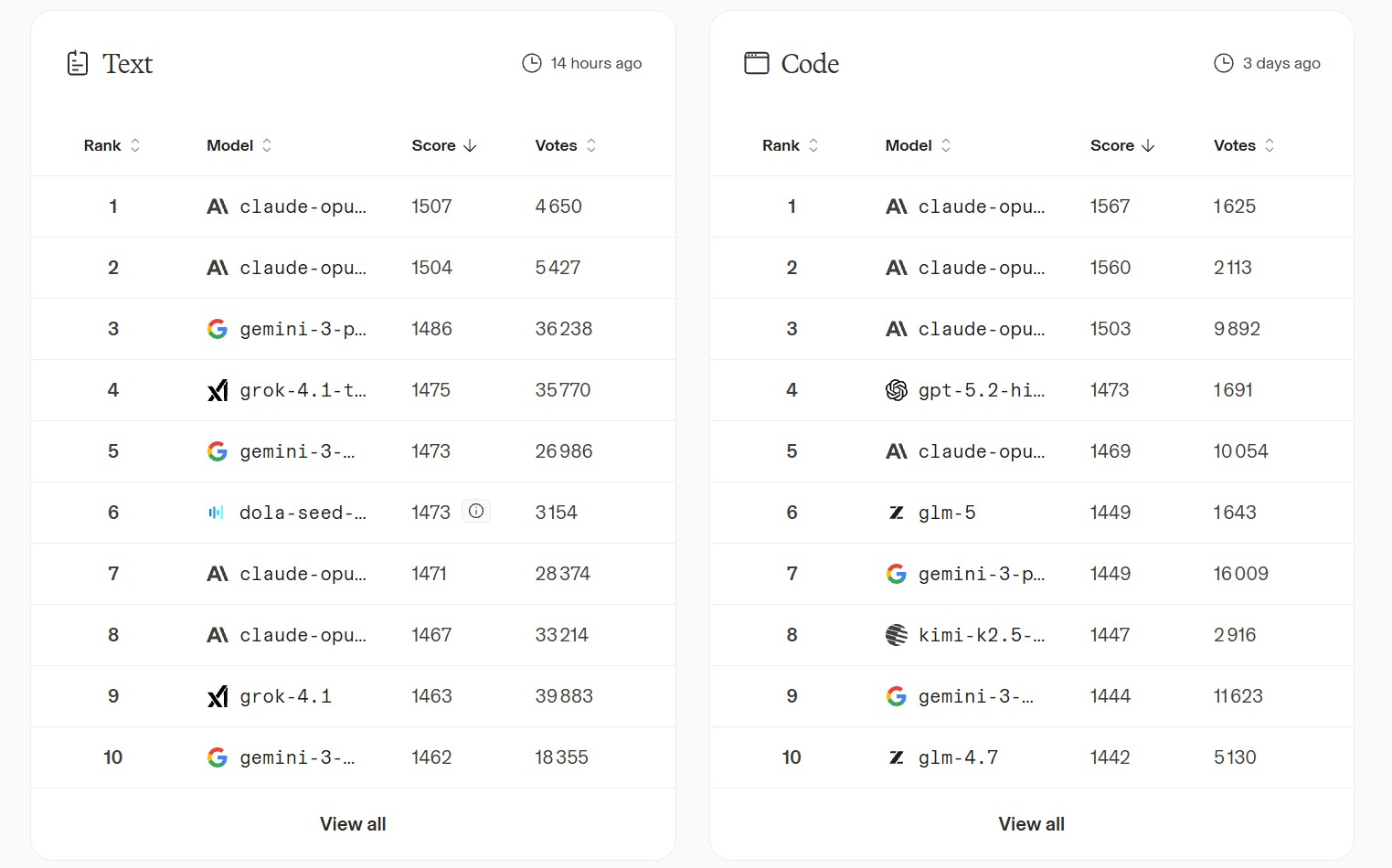

Les modèles d’IA les plus performants par catégorie

Au-delà du classement général, la LMArena propose des leaderboards thématiques qui permettent d’identifier plus finement les points forts de chaque modèle selon les usages. Voici les tendances observées sur les derniers tableaux publiés :

- Génération de texte : Claude Opus 4.6 domine nettement la catégorie, avec ses deux versions (« thinking » et standard) aux deux premières places. Gemini 3 Pro conserve une position solide sur le podium, tandis que Grok 4.1 « thinking » et Gemini 3 Flash restent au contact.

- Développement web : Claude confirme son leadership sur le code. Les deux versions d’Opus 4.6 occupent également les premières places dans ce domaine, suivies par Opus 4.5. OpenAI parvient à se hisser au quatrième rang avec GPT-5.2 « high ».

- Vision : Google prend l’avantage sur l’analyse d’image avec Gemini 3 (Pro et Flash). Dola Seed 2.0, société californienne, s’intercale à la troisième place. OpenAI, longtemps précurseur dans ce domaine, se contente de la 5e place.

- Génération d’images : maigre consolation pour OpenAI qui garde la tête des classements de génération et de retouche d’image. Mais Gemini reste en embuscade, devant Grok.

- Recherche web : Google occupe les deux premières places avec Gemini 3 Flash Grounding et Gemini 3 Pro Grounding. OpenAI suit de près avec GPT-5.2 Search et GPT-5.1 Search. De leur côté, Grok et Claude apparaissent plus bas dans le classement.

Comment les modèles d’IA sont-ils classés par LMArena ?

Pour offrir un panorama aussi impartial que possible du secteur, la LMArena mise sur l’évaluation collective. La plateforme organise des face-à-face anonymes entre modèles, tous soumis au même prompt, afin que les utilisateurs puissent comparer directement les réponses et choisir celle qu’ils jugent la plus aboutie. À l’issue de chaque duel, un score Elo est ajusté pour chaque participant. Ce mécanisme valorise les victoires contre des modèles mieux classés et sanctionne plus fortement les revers face à des concurrents moins bien positionnés, ce qui permet d’affiner progressivement la hiérarchie.