Top 10 des modèles d’IA les plus performants en juillet 2025 : le classement complet

Gemini, avec son modèle 2.5-Pro, ne décroche plus de la première place. Il se montre dominant dans tous les domaines analysés par la LMArena.

Alors que la mode est aux agents IA, les entreprises de la tech continuent d’innover pour proposer des modèles encore plus poussés. La LMArena ambitionne de suivre cette course effrénée en proposant des classements dynamiques des modèles les plus performants. Voici les grandes tendances en juillet 2025.

Les meilleurs modèles d’IA en juillet 2025

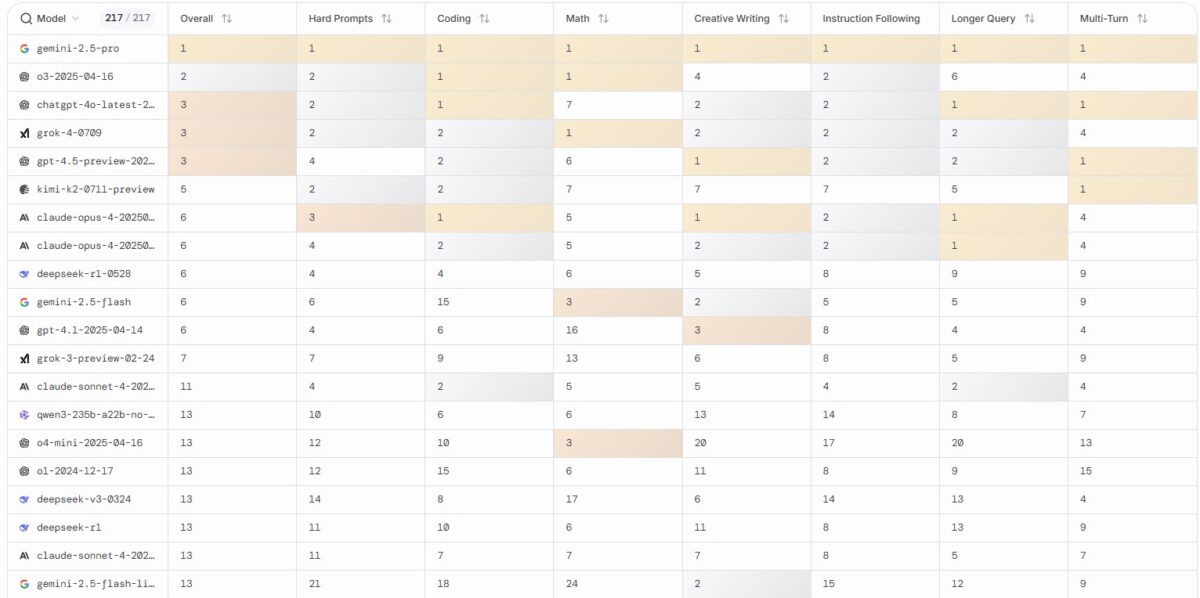

Gemini s’est-il installé pour de bon en tête de la LMArena ? En juillet 2025, le modèle Gemini-2.5-Pro n’a jamais été aussi dominant au classement général (voir image de une). Dans chaque catégorie observée, il se positionne comme leader. Le podium est complété par deux modèles d’OpenAI : o3 et ChatGPT-4o, qui semblent toutefois assez largement distancés par Gemini-2.5-Pro.

Dans le reste du classement, on note une belle performance de Grok (4e), qui ne semble pas pâtir de ses récentes sorties de route, et de Kimi (6e), le modèle créé par la startup chinoise Moonshot AI. Enfin, Claude, qui semblait être sorti des radars depuis plusieurs mois, continue de profiter du nouveau système de classement proposé par la LMArena. En juillet 2025, l’IA d’Anthropic parvient à placer deux de ses modèles dans le top 10.

Voici les 10 modèles d’IA les plus performants en juillet 2025, selon la LMArena :

- Gemini-2.5 Pro

- OpenAI o3

- ChatGPT 4o

- Grok-4

- GPT-4.5

- Kimi-k2

- Claude Opus 4 (version « thinking »)

- Claude Opus 4 (version standard)

- DeepSeek R1

- Gemini-2.5 Flash

LMArena : le classement par catégorie

Depuis juin dernier, la LMArena propose plusieurs classements détaillés en fonction des différents domaines. Voici les tendances qui se dégagent en juillet 2025 :

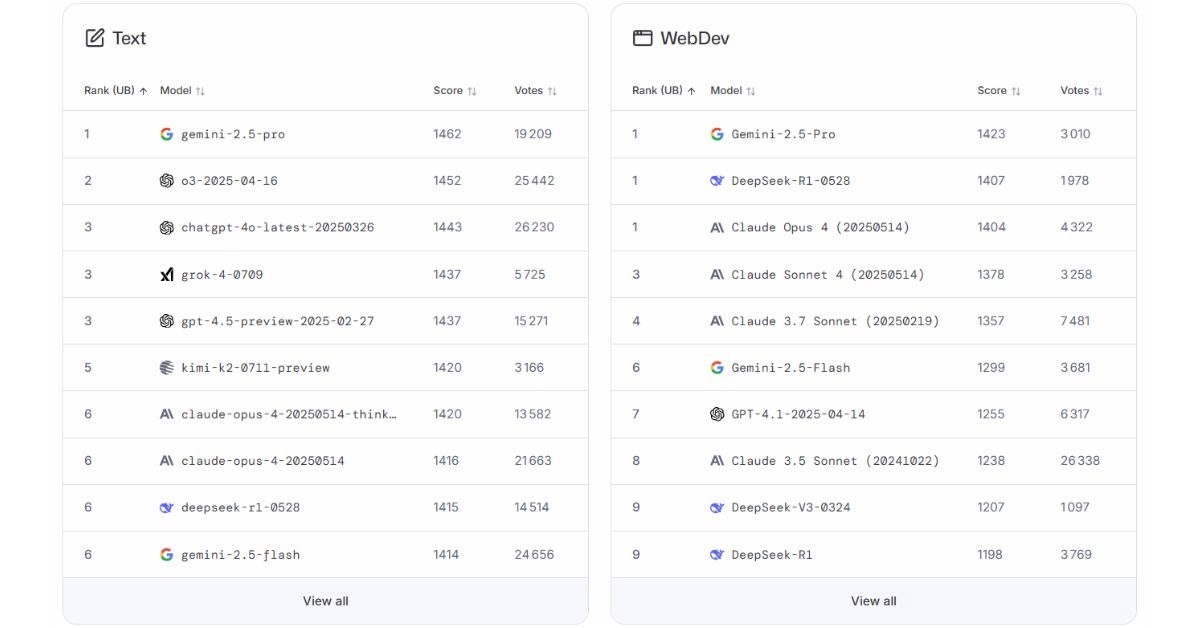

- Texte : en tête, Gemini-2.5-Pro conserve une courte avance, talonné de près par OpenAI. Les positions restent serrées, mais la densité du podium témoigne d’un équilibre toujours plus affiné entre les rivaux.

- Développement web : Gemini, DeepSeek et Claude, dans plusieurs variantes, forment le trio de tête. OpenAI n’accède qu’à une 7e place dans ce classement.

- Analyse d’images : Gemini confirme son avance, mais les écarts se réduisent. Il est suivi de très près par les modèles d’OpenAI.

- Recherche en ligne : le haut du classement se partage entre Gemini et les modèles Sonar de Perplexity, très présents dans cette catégorie. OpenAI reste discret, relégué à l’arrière-plan avec ses variantes API.

- Assistants de code : DeepSeek s’installe tout en haut, mais Claude reste à l’affût avec ses modèles 3.5 Sonnet. Mistral parvient pour la première fois à se hisser dans les hauteurs du classement.

- Génération d’images : GPT-Image-1 garde la tête, malgré une forte concurrence menée par Flux. Les outsiders s’organisent derrière, mais restent encore loin du score atteint par le leader d’OpenAI.

Quels sont les critères de classement de la LMArena ?

Développée par la Large Model Systems Organization (LMSYS), la LMArena repose sur un système de duels anonymes pour évaluer les performances des modèles d’intelligence artificielle. À chaque prompt, deux modèles sont comparés à l’aveugle, et les utilisateurs désignent celui qui a fourni la meilleure réponse. Chaque résultat influe sur un score Elo, inspiré du système de classement des échecs : battre un modèle mieux classé fait progresser le score, tandis qu’une défaite contre un modèle moins bien noté le fait baisser.

Ce mécanisme permet de générer plusieurs classements distincts en fonction des tâches ou des domaines évalués. À partir de ces classements spécifiques, la plateforme établit un leaderboard général, qui synthétise les performances globales de tous les modèles en lice.