Shadow IA & cybersécurité : « il faut pouvoir encadrer les usages de l’IA, sans freiner l’innovation »

L’usage informel de l’IA en entreprise progresse. S’il permet des gains de productivité, il entraîne avec lui son lot de risques pour la sécurité informatique.

L’adoption des IA génératives en entreprise a connu une croissance spectaculaire en l’espace de 3 ans. Mais celle-ci n’a pas toujours fait l’objet d’une coordination au sein des entreprises. L’usage d’outils comme ChatGPT ou Claude s’est souvent effectué à l’initiative des employés eux-mêmes, avec la tolérance implicite des directions, satisfaites des gains de productivité observés.

BlackFog, entreprise de cybersécurité, s’est penchée sur ce phénomène dans une étude publiée ce 27 janvier 2026. Celle-ci se base sur un sondage mené auprès de 2 000 personnes. Ci-dessous, découvrez les chiffres clés à retenir.

Shadow IA en 2026 : 5 chiffres à connaître

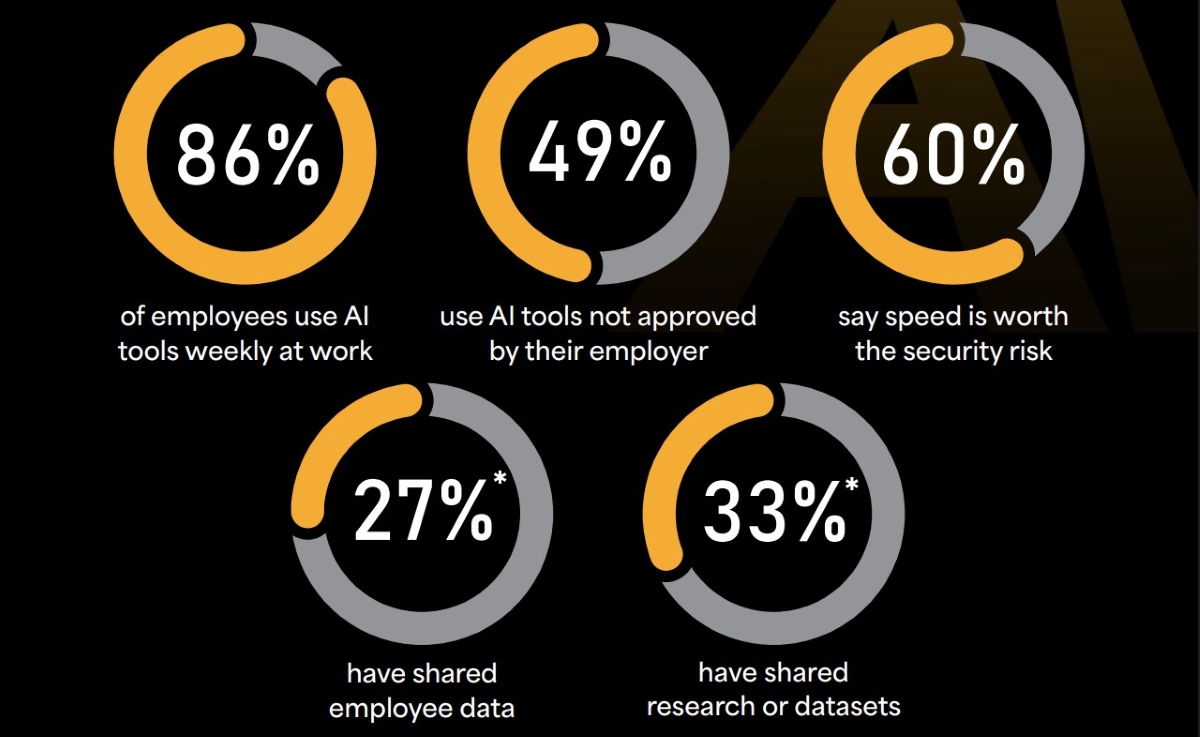

Selon le Dr Darren Williams, PDG et fondateur de BlackFog, l’étude « révèle de façon alarmante non seulement l’utilisation généralisée d’outils d’IA non approuvés, mais aussi le niveau de tolérance au risque des employés et des dirigeants ». Le dirigeant estime que celle-ci devrait « alerter les équipes de sécurité et souligner la nécessité d’une surveillance et d’une visibilité accrues sur ces failles de sécurité ». Alors que 86 % des employés interrogés indiquent utiliser des outils d’IA chaque semaine au travail, leurs usages semblent, selon l’enquête, révéler de nombreux angles morts.

Voici 5 données clés qui ressortent de cette enquête :

- Près de la moitié des répondants utilisent des outils d’IA qui n’ont pas été approuvés par leur employeur.

- 60 % du panel juge que « le gain de rapidité justifie le risque de sécurité ». Même son de cloche côté direction : 69 % des dirigeants privilégient la rapidité au détriment de la sécurité.

- 27 % déclarent avoir partagé des données de collaborateurs, tandis que 33 % indiquent avoir partagé des données de recherche ou des datasets.

- 58 % des professionnels s’appuient sur des outils d’IA gratuits dépourvus de protections de niveau entreprise.

- 51 % des répondants ont intégré des outils d’IA à d’autres systèmes sans validation de la DSI.

Deux risques majeurs : la fuite de données et la compromission du système d’information

Pour aborder ce phénomène, BDM a interrogé Alexandre Lohisse, coordinateur SSI pour le groupe Hellowork (auquel appartient BDM). Selon l’expert, le recours informel aux outils IA par les employés peut poser de sérieux problèmes de sécurité. « Un salarié utilisant des systèmes IA qui n’ont pas été encadrés fait courir un risque pour son entreprise », rappelle-t-il. Pour le spécialiste, la fuite de données est le principal risque auquel s’exposent les entreprises.

Ces données peuvent être réutilisées par l’IA pour nourrir le modèle. Elles pourraient ensuite être réexploitées par des acteurs malveillants (état étranger, entreprises…) pour de l’espionnage, de l’avantage concurrentiel ou pour de la revente d’information. […] Leur divulgation pourrait avoir des impacts forts aussi bien de façon juridique (RGPD) qu’économique, ou bien encore sur son image.

Autre risque à prendre en compte : « la compromission de tout ou partie du système d’information de l’entreprise » par le biais de modèles d’IA gratuits, qui peuvent être « pollués par du data poisoning, altérés, ou bien encore malveillants », rappelle Alexandre Lohisse. Le système d’information peut alors se retrouver confronté à l’injection de code source malveillant, à l’utilisation de scripts générés par un modèle malveillant, ou encore à des automatisations de tâches non contrôlées.

Comment assurer un usage sécurisé des IA ?

Face à la montée du shadow IA, Alexandre Lohisse insiste sur la nécessité d’inscrire les usages dans un cadre formalisé visant à organiser les usages de l’IA, sans freiner l’innovation. « Le cadre de gouvernance cybersécurité d’une entreprise se doit d’intégrer les bons usages quant à l’utilisation de l’intelligence artificielle », rappelle-t-il, « le shadow IA, c’est passer outre ce cadre de gouvernance ».

Les entreprises disposent pour cela de plusieurs leviers. Sur le plan technique, certaines peuvent faire le choix de restreindre ou de canaliser les usages, afin de limiter les risques liés à l’exposition des données et à l’utilisation d’outils non maîtrisés. Une approche efficace en matière de sécurité, mais qui suppose des arbitrages.

La bonne méthode pour faire face à tout ça ? Cela dépend d’où on place le curseur entre sécurité et souplesse opérationnelle. Une mesure technique serait par exemple de n’autoriser que les flux d’informations provenant d’IA approuvées par l’entreprise, avec un risque de friction pour les métiers.

Les leviers organisationnels peuvent également être mobilisés : encadrer les usages via des chartes et des politiques cybersécurité, fournir aux salariés des outils autorisés et adaptés, et surtout les sensibiliser. Pour l’expert, cet accompagnement est essentiel face à des technologies encore récentes et amenées à évoluer rapidement.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis