Panorama des modèles d’IA utilisés pour le cinéma et le jeu vidéo

Le cinéma, le jeu vidéo et d’autres secteurs créatifs ont vu les IA génératives s’imposer et ouvrir de nouvelles voies… parfois inquiétantes !

Dans le cadre du Big Data & AI Paris, Nicolas Gaudemet, Chief AI Officer chez Onepoint, cabinet de conseil en technologie, a présenté divers modèles d’IA génératives. Il s’est principalement concentré sur la génération d’images, de vidéos et de contenus 3D. Il a détaillé comment ces intelligences artificielles s’appliquent aux médias créatifs, en particulier dans les domaines du cinéma et des jeux vidéo. On fait le point !

Des modèles d’IA pour l’image

GAN (generative adversarial network)

Les GAN existent depuis 2014. Ils se composent d’un générateur et d’un discriminateur. Ces deux éléments s’entraînent simultanément pour distinguer les images réelles des images générées, dans le but de créer de nouvelles images toujours plus réalistes et à résolution croissante. « Une fois que le générateur est entraîné, on peut lui apprendre à trouver un vecteur de départ correspondant à une image spécifique, afin de pouvoir ensuite modifier ses caractéristiques en modifiant le vecteur », explique Nicolas Gaudemet. En d’autres termes, ils permettent de générer des images avec un fort degré de réalisme.

FRAN (face re-aging network)

Le modèle FRAN a été conçu par Disney. Il permet de modifier l’âge de n’importe quel visage en haute définition. Son avantage est qu’il conserve les dimensions d’une image. Pour se former, la technologie est entraînée sur 400 000 paires de visage-âge générées par un GAN. On utilise FRAN en post production, par exemple dans le dernier film Indiana Jones, pour obtenir le visage d’un Harrison Ford jeune, alors que l’acteur américain est aujourd’hui octogénaire (processus de « de-aging », que vous pouvez retrouver en image de une).

Les modèles de diffusion

Ils sont devenus « le standard de la génération d’images ». On les connaît au travers d’outils comme DALL-E ou Midjourney. Ce sont des modèles dits « débruiteurs », entraînés en ajoutant du bruit à des images et en apprenant à les reconstituer. « En itérant sur un bruit aléatoire, un modèle de diffusion est capable de générer de nouvelles images ». Le diffusion « peut-être guidée par une image ou par un texte grâce à un encodeur texte-image appelé CLIP (contrastive langage image pretraining) ou par un contour ou une pause humaine grâce à ControlNet », comme pour Stable Diffusion.

Les IA génératives pour la vidéo

ADFA (audio driven facial animation)

Ce modèle est « très utilisé dans les industries créatives ». Datant de 2017, il a appris à associer des phonèmes et des visèmes, c’est-à-dire des sons et des expressions faciales. Il permet de « modifier les expressions d’un audio et d’un texte de style ». Il est notamment utilisé dans le cadre du « vubbing », qui modifie les mouvements de la bouche d’un acteur pour qu’il soit adapté aux mots qu’il prononce. On en a notamment entendu parler récemment avec les sociétés HeyGen ou Flawless, qui en a donné un exemple impressionnant dans la vidéo ci-dessous.

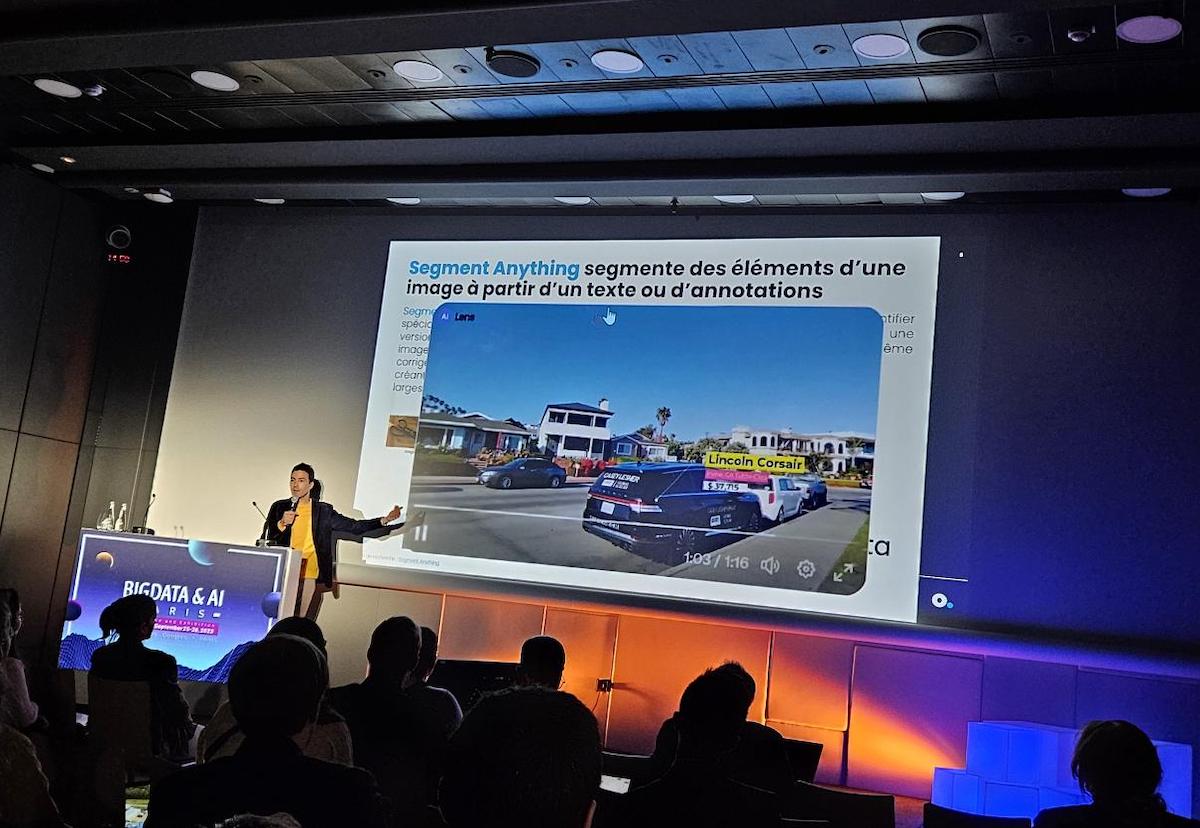

Segment Anything

Créé par Meta en 2023, Segment Anything est spécialisé dans la génération de masques. Il peut aider à identifier des objets dans une image ou une vidéo afin de les modifier. Ce modèle est entraîné sur un « jeu image-masque », puis des annotateurs humains corrigent ces masques, « créant des jeux d’entraînement plus larges pour des versions améliorées ».

Make-A-Video

Cet outil permet de générer une vidéo à partir d’un texte et est notamment connu grâce à Runway. Il s’agit en quelque sorte d’animer une image statique générée par un modèle de diffusion. Bien qu’imparfait, ce type de modèle « pourrait être utilisé pour générer des bandes-annonces, des courts métrages, des publicités ». Un excellent exemple est la séquence The great cat spy, créée avec Gen-2 de Runway et ChatGPT, que vous pouvez voir ci-dessous.

Les IA génératives appliquées au secteur du jeu vidéo

NeRF (neuronal radiance field)

Ce modèle est entraîné « à partir d’images 2D d’une même scène sous différents angles ». Il apprend pour chaque point et chaque angle de vue « à prédire sa radiance (couleur et luminosité) et sa densité (capacité à réfléchir ou absorber la lumière) ». Les NeRF sont notamment utilisés dans le secteur vidéoludique pour modéliser des bâtiments en 3D. C’est ce modèle qui a permis à Blender de modéliser en 3D le Sacré-Cœur ci-dessous.

Entraîné par un modèle de diffusion, un NeRF peut générer une scène en 3D à partir d’un texte. « Ce type de modèle peut être utilisé pour générer des objets dans les jeux vidéo », explique Nicolas Gaudemet.

Make-A-Video3D

Outil créé également par Meta, Make-A-Video3D permet de générer une vidéo 3D à partir d’un texte. C’est en réalité un NeRF 4D, qui est guidé par un modèle de génération vidéo, à l’instar de Make-A-Video. Le NeRF 4D modélise la radiance et la densité, comme un NeRF classique, mais également « la dynamique temporelle de chaque point dans l’espace ». Là encore, il s’agit d’animer une image statique.

D’autres modèles existent, mais voici un panorama des principaux outils utilisés à l’heure actuelle dans les médias créatifs. Quant à l’avenir, il reste « fascinant et effrayant », juge Nicolas Gaudemet, citant notamment l’acteur Tom Hanks, qui estimait récemment que l’IA pourrait lui faire continuer sa carrière d’acteur, même après sa mort !

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis