OpenAI dévoile o3 et o4-mini, deux nouveaux modèles capables de raisonnement visuel

ChatGPT accueille o3 et o4-mini qui allient puissance pour l’un, et légèreté pour l’autre, avec des capacités améliorées de raisonnement avancé, notamment dans l’analyse d’images.

Le 16 avril 2025, OpenAI a présenté deux nouveaux modèles d’intelligence artificielle : o3 et o4-mini. Ces évolutions marquent un tournant discret mais important dans la conception des modèles de langage : meilleure performance, plus grande autonomie dans l’usage des outils et, surtout, intégration directe de la vision dans le raisonnement. Ces modèles sont d’ores et déjà disponibles pour les abonnés ChatGPT Plus, Pro et Team.

o3, une nouvelle référence en matière de performance

Positionné comme le modèle le plus avancé proposé par OpenAI à ce jour, o3 s’illustre, selon ses créateurs, par ses résultats sur des tâches complexes relevant des mathématiques, du codage ou encore des sciences expérimentales. Il dépasse largement ses prédécesseurs sur des benchmarks de référence comme Codeforces ou SWE-bench, mais surtout sur des cas d’usage concrets. Selon les tests internes, il réduit de 20 % les erreurs majeures par rapport au modèle o1.

o3 est notre modèle de raisonnement le plus performant, repoussant les limites dans des domaines tels que le codage, les mathématiques, les sciences, la perception visuelle, et bien d’autres.

Ces performances s’expliquent aussi par une meilleure autonomie : o3 mobilise mieux, par lui-même, les outils mis à sa disposition dans ChatGPT (navigation web, exécution de code, génération d’images, lecture de fichiers) sans forcément attendre une instruction explicite. Il adapte ainsi ses actions à la nature de la question, ce qui est censé renforcer sa pertinence dans les échanges longs et les requêtes complexes. En outre, il dévoile, durant le processus, ses différentes étapes de réflexion avant la production d’une réponse.

o4-mini, un compromis entre puissance et efficacité

En parallèle, OpenAI introduit o4-mini, une version plus légère et moins coûteuse que son grand frère, qui n’en reste pas moins performante. Elle surpasserait o3-mini sur de nombreuses épreuves et s’inscrit dans une logique d’accessibilité, avec des limites d’usage plus élevées, idéales pour les utilisatrices et utilisateurs intensifs.

o4-mini est un modèle plus compact, optimisé pour un raisonnement rapide et économique. Il offre des performances remarquables au regard de sa taille et de son coût, notamment en mathématiques, en codage et dans les tâches visuelles.

Comme o3, o4-mini bénéficie de l’intégration complète aux outils ChatGPT et dispose des mêmes capacités de raisonnement multimodal. Malgré sa légèreté , il doit être capable de traiter des documents complexes, de résoudre des problèmes mathématiques et d’extraire des données d’images, le tout avec une bonne rapidité d’exécution.

Le raisonnement visuel, nouveau terrain de jeu de ChatGPT ?

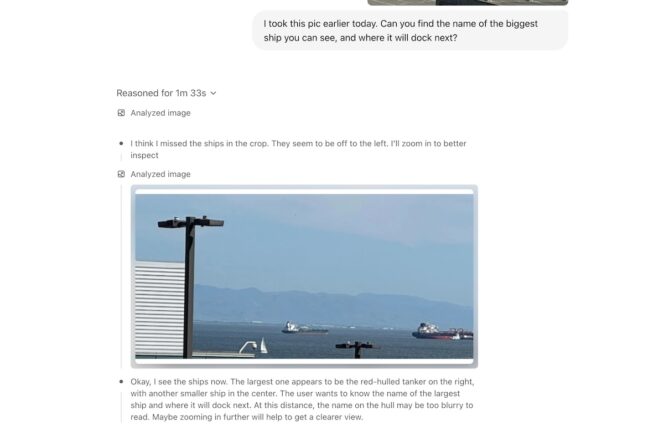

La nouveauté la plus importante de ces nouveaux modèles réside dans leur capacité à « penser avec des images ». Contrairement aux générations précédentes, o3 et o4-mini peuvent inclure des documents visuels dans leur raisonnement, en les modifiant eux-mêmes si besoin (zoom, rotation, recadrage) pour en extraire des éléments utiles. Cette fonction est native aux modèles, et non déléguée à un outil externe.

Il est ainsi possible, toujours selon OpenAI, de traiter des images imparfaites ou incomplètes, comme une feuille manuscrite mal cadrée ou une photo de tableau prise de travers. Les modèles peuvent analyser un document scientifique, lire un graphique, répondre à une question basée sur une carte ou un panneau de signalisation, le tout sans assistance humaine préalable. OpenAI évoque un changement de paradigme, où l’image devient une source d’information à part entière dans le processus de réflexion.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis