OpenAI dévoile GPT-5.1-Codex-Max, un « nouveau modèle de codage agentique de pointe »

Avec ce nouveau modèle, l’agent IA d’OpenAI gagne en efficacité, mais surtout en endurance. Il peut désormais plancher sur une tâche de développement pendant 24 heures.

Quelques jours après le déploiement de GPT-5.1 sur ChatGPT, Codex profite à son tour d’un nouveau modèle. Dans un blog post publié ce mercredi 19 novembre 2025, OpenAI a officiellement dévoilé GPT-5.1-Codex-Max, un « nouveau modèle de codage agentique de pointe » conçu pour les tâches de longue durée. Il est disponible dès aujourd’hui dans les environnements Codex pour les abonnés à ChatGPT Plus, Pro, Business, Edu et Enterprise et sera prochainement déployé dans l’API.

Avec ce nouveau modèle, Codex renforce sa capacité d’attention

Entraîné sur des tâches agentiques « couvrant le génie logiciel, les mathématiques ou la recherche », précise le communiqué, GPT-5.1-Codex-Max se distingue par sa capacité à « fonctionner à travers plusieurs fenêtres de contexte » grâce à un procédé baptisé compaction. Mais de quoi s’agit-il, au juste ?

Déjà exploité par Claude Code, rappelle ZDNet, ce mécanisme permet à l’agent IA de compresser certains éléments fournis par l’utilisateur, jugés non essentiels, lorsque sa mémoire arrive à saturation. Dit plus simplement, le modèle améliore sa capacité d’attention et décroche moins facilement lorsque l’utilisateur lui fournit, d’un seul coup, de très grandes quantités de données. « Dans les applications Codex, GPT-5.1-Codex-Max compacte automatiquement sa session lorsqu’il approche de la limite de sa fenêtre de contexte, lui offrant une nouvelle fenêtre. Il répète ce processus jusqu’à terminer la tâche », détaille OpenAI.

GPT-5.1-Codex-Max, un modèle plus rapide et endurant

En pratique, cette avancée permet à Codex de travailler en autonomie pendant plusieurs heures et de mener à bien des tâches volumineuses qui échouaient jusqu’ici, comme « des refactorisations complexes ou des boucles agentiques longues », indique OpenAI. Depuis sa mise à jour de septembre, l’agent IA pouvait déjà rester concentré sur un projet pendant sept heures. Lors d’évaluations menées en interne, OpenAI affirme l’avoir « observé travailler plus de 24 heures d’affilée ». « Il itère sans relâche sur son implémentation, corrige les échecs de test et finit par livrer un résultat réussi », vante la firme californienne.

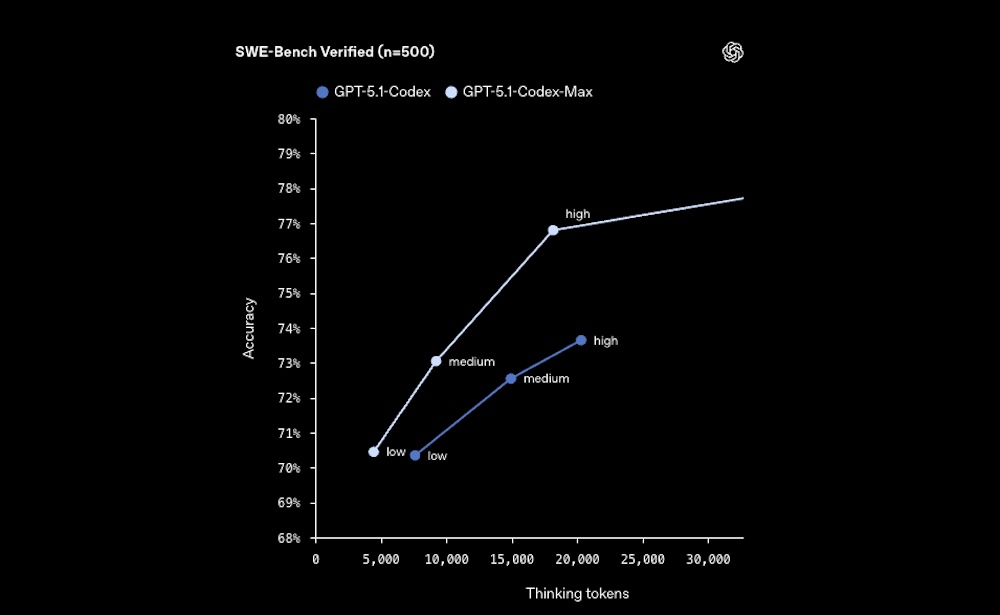

En outre, le modèle surpasserait ses prédécesseurs sur de « nombreuses évaluations de codage avancé », précise le communiqué, tout en étant plus efficace et moins coûteux. Sur le benchmark SWE-bench Verified, qui évalue les grands modèles de langage sur des problèmes logiciels réels provenant de GitHub, il « obtient de meilleures performances que GPT-5.1-Codex avec un niveau de raisonnement « medium », tout en utilisant 30 % de tokens en moins ».

Par exemple, GPT-5.1-Codex-Max est capable de produire des designs front-end de haute qualité avec une fonctionnalité et une esthétique similaires, mais à un coût bien inférieur à GPT-5.1-Codex, illustre OpenAI.