Modération des contenus illicites : « La priorité est de mettre en place un système de signalement efficace »

Point de Contact joue un rôle clé dans la lutte contre les contenus illicites en ligne. Anne Souvira, la présidente de l’association, détaille pour BDM les technologies utilisées et les défis posés par l’IA générative.

Combien de signalements traitez-vous chaque année et quels sont vos délais moyens pour qu’un contenu soit définitivement retiré d’une plateforme ?

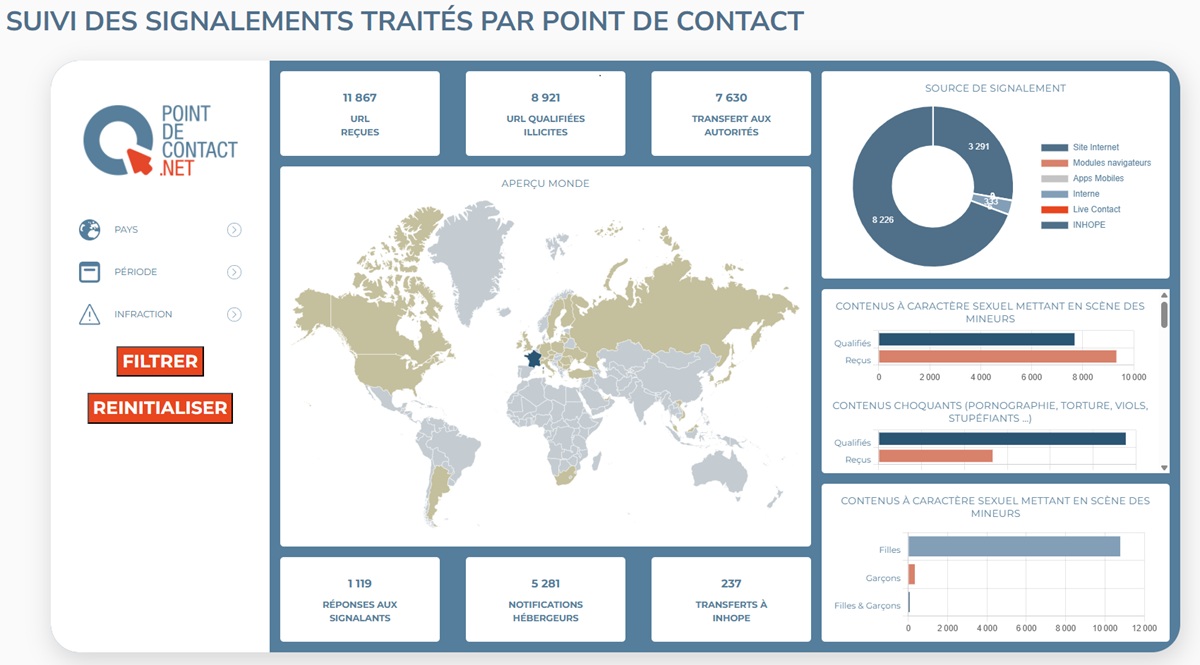

Le rapport de transparence contenant ces statistiques sortira début mars. Mais certains chiffres sont déjà disponibles sur le site de Point de contact : nous avons traité 42 000 signalements en 2024, et plus de 120 000 en 2025.

Nous transmettons les signalements qualifiés juridiquement comme illicites à la plateforme PHAROS, qui se charge du retrait. Les délais varient en fonction de chaque situation.

Pouvez-vous nous expliquer les technologies que votre association utilise pour identifier les contenus illicites ? Comment permettent-elles de détecter automatiquement un contenu signalé qui circulerait sur plusieurs plateformes ?

Il faut préciser que l’association Point de contact ne traite que les signalements qu’elle reçoit et ne recherche pas elle-même les contenus sur l’Internet.

Pour lutter contre certaines infractions précises (l’exploitation sexuelle de mineurs et la diffusion non consensuelle de contenus intimes), nous employons la technologie du condensat, aussi appelée signature numérique, ou « hash » en anglais.

Cette technologie permet d’analyser une image ou une vidéo, et de transformer le fichier en ligne de code qui permettra l’identification du même fichier (ou d’une version légèrement modifiée du fichier), si cette image est publiée sur un service utilisant également cette technologie des condensats.

Nous mettons nos signatures numériques à disposition de certains de nos partenaires, afin qu’ils puissent détecter et supprimer de manière proactive des contenus illicites sur leurs services.

Utilisez-vous l’intelligence artificielle pour préanalyser les signalements avant l’intervention humaine ? Si oui, quels sont les résultats et les limites de cette automatisation ?

Nous n’utilisons pas à ce jour de technologie basée sur l’intelligence artificielle. Nous disposons cependant aujourd’hui d’un algorithme, la Content Safety API de Google, qui analyse les images et les vidéos qui apparaissent sur les pages signalées par les utilisateurs afin de leur donner une notation.

Cette notation correspond à la probabilité que les contenus présentent des atteintes sexuelles sur des mineurs, et permet à notre équipe d’analystes de prioriser les signalements que nous recevons.

Notre but est de nous assurer de traiter en priorité les contenus les plus graves impliquant des mineurs.

Avec l’explosion des contenus générés par IA (deepfakes, images synthétiques…), comment adaptez-vous vos technologies de détection ?

Nous avons effectivement observé une forte augmentation du nombre de contenus générés par IA qui nous sont signalés. Pour y faire face, nous privilégions aujourd’hui l’agrandissement de notre équipe et l’élargissement de sa formation.

Il n’existe pas, à notre connaissance, aujourd’hui de technologie de détection fiable, qui nous permettrait de filtrer les contenus générés par IA qui nous sont signalés.

De plus, une évaluation humaine étant requise au sein de notre structure pour chaque contenu qui nous serait soumis, nous ne pourrions pas nous reposer uniquement sur ce type de technologie de détection.

Meta, TikTok, Snapchat sont membres de votre association. Concrètement, cela vous fait-il bénéficier d’accès privilégiés ou de canaux de communication dédiés par rapport aux signalements des utilisateurs ? Comment parvenez-vous à communiquer avec ces plateformes ?

En raison de notre statut de signaleur de confiance, les plateformes en ligne sont tenues de traiter nos signalements en priorité. Toutes n’ont pas ouvert un canal de signalement dédié pour autant. Certaines se contentent d’identifier nos signalements à l’aide de l’adresse email que nous leur fournissons.

Nous avons en parallèle effectué des réunions opérationnelles avec certaines de ces plateformes, et nous leur faisons des retours concernant les procédures de signalements qu’ils mettent en place, ou les trends que nous observons sur leurs plateformes.

Quelles sont les plateformes les plus réactives ? Et inversement, lesquelles sont plus difficiles à mobiliser ?

En 2025, nous avons reçu plus de 120 000 signalements de la part du public et de nos partenaires. Concernant les délais de retrait, ils varient selon les plateformes. Certaines nous répondent en moins de 24 heures, d’autres seulement après plus d’une semaine.

Nos notifications ne sont pas toujours suivies d’une action. En effet, le droit américain se différencie du droit français sur la liberté d’expression : celle-ci est absolue aux États-Unis (1er amendement), alors que le droit français réprime l’abus de la liberté d’expression et érige certaines expressions comme infractions de droit commun, notamment la discrimination et la haine en ligne.

Cela entraîne parfois des divergences d’interprétation et des discussions que le juge judiciaire finira par trancher. Cela est précisé dans les ressources de l’Arcom.

Quelle est l’erreur la plus fréquente que vous observez chez les plateformes dans la gestion des signalements et comment l’éviter, selon vous ?

Plusieurs plateformes ne permettent pas de notifier tous les types de contenus et comportements illégaux via les outils réservés aux signaleurs de confiance. Sur certaines, il n’est pas encore possible de signaler un compte entier ou des commentaires sous des contenus précis via le formulaire prévu dans le cadre du DSA (Digital Services Act, ndlr).

Pour éviter ces problèmes, il apparaît nécessaire d’uniformiser les procédures de signalements mises à disposition des signaleurs de confiance par les plateformes, ainsi que de définir plus clairement les types de contenus qui sont concernés par les obligations du DSA.

Un autre problème que nous avons constaté : beaucoup de réponses des plateformes se basent encore sur leurs conditions d’utilisation (CGU), soit le droit civil des contrats, sans mentionner la législation européenne et nationale concernée par le DSA.

Nous regrettons que le fait de citer ces CGU plutôt que leurs obligations légales laisse penser qu’elles privilégient leurs règles communautaires, ce qui pourrait pourtant être résolu assez facilement en adaptant leurs modèles de réponse et leurs notifications de modération.

Quels outils ou technologies recommanderiez-vous d’utiliser pour un professionnel du digital qui souhaiterait lancer sa plateforme de contenus UGC, afin de mettre en place une modération efficace dès le départ ?

Si les plateformes ne sont pas tenues à une détection générale et indifférenciée des contenus postés, mais seulement à une obligation de coopération sur certaines infractions, il n’en reste pas moins qu’elles ont le droit de vérifier en amont les contenus à poster. En effet, tout système de communication ou d’hébergement mis en ligne sur Internet doit faire face à un risque d’abus.

La priorité pour toute plateforme de ce type est donc de mettre en place un système de signalement et de modération efficace pour identifier le mieux possible ces risques.

Pour venir assister ces méthodes de modération, nous recommanderions à ces professionnels d’utiliser des technologies de détection, telle que le condensat (« hash »), qui permettent de créer des signatures numériques des contenus téléchargés sur le site ou le service en question. Puis, en les comparant à ceux stockés dans certaines bases de données, comme celle de Point de Contact ou de NCMEC aux États-Unis, identifier si des contenus illégaux sont publiés sur leur plateforme.

Cette méthode permet de réduire fortement le risque de prolifération de contenus déjà confirmés comme étant illégaux, ainsi que de prévenir de la revictimisation des victimes.

Anne Souvira, Présidente

Commissaire divisionnaire honoraire, Anne Souvira a consacré 40 ans au service de l’État à la préfecture de Police de Paris (PP). Spécialiste de la cybercriminalité, elle a notamment dirigé la Brigade d’enquête sur les fraudes aux technologies de l’information et la Mission cyber de la PP. Présidente de Point de Contact depuis juin 2023, elle intervient également dans le monde académique pour sensibiliser à la cybersécurité. Elle est chevalier de l’ordre de la Légion d’honneur et de l’ordre national du Mérite.