« C’est tout le challenge de l’UX » : intégrer de l’IA à son produit, une équation pas si simple

Claire Lebarz, CTO de Malt, a piloté le lancement d’AI Search, une fonctionnalité d’IA déployée en 2024. Pour BDM, elle décrypte les coulisses d’un projet délicat, entre exigences techniques, enjeux d’UX et impératif de transparence.

Ces questionnements risquent de torturer l’esprit des product managers et product owners, à l’ère de ChatGPT, Gemini et plus largement des interfaces conversationnelles. Comment intégrer une fonctionnalité d’IA à son produit sans désorienter l’utilisateur ? Quelles stratégies faut-il adopter pour encourager le feedback et améliorer progressivement sa technologie ? Et, surtout, quelles tactiques d’UX faut-il privilégier pour rendre la fonctionnalité aussi claire qu’accessible ?

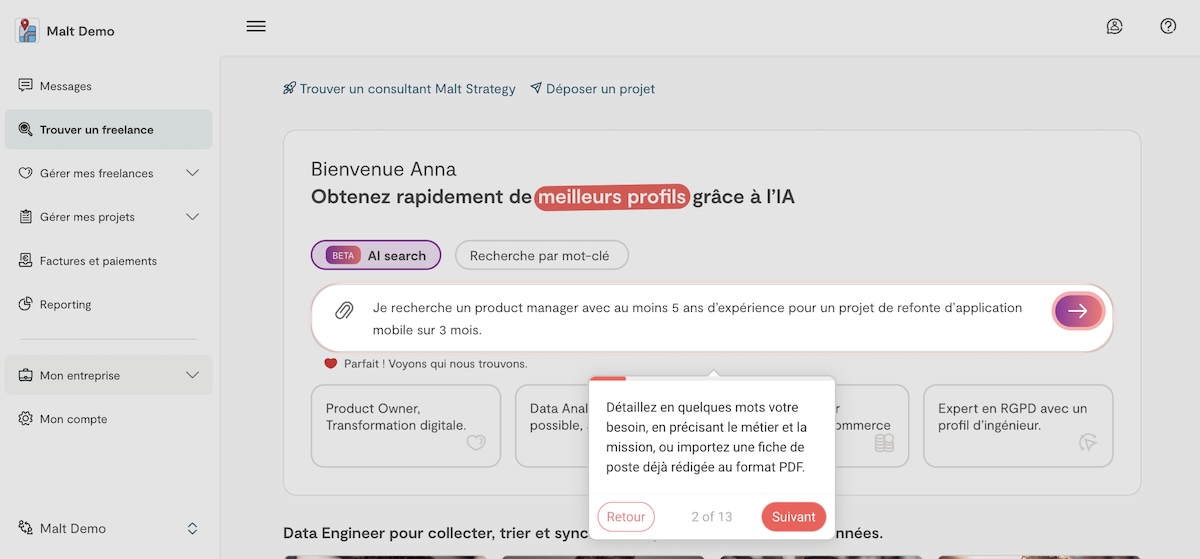

Lors d’un entretien accordé à BDM, Claire Lebarz, CTO chez Malt, a exploré toutes ces questions en s’appuyant sur l’exemple d’AI Search : un assistant personnel de sélection des freelances lancé en 2024 ayant pour objectif de faciliter la mise en relation. Et dont elle a piloté le développement, du prototypage au déploiement.

Pouvez-vous me retracer la genèse du projet AI Search ? À quel besoin répondait la fonctionnalité, à l’origine ?

La question du besoin est sans doute la plus importante. Malt est une plateforme crée il y a 12 ans et dans laquelle le machine learning est utilisé depuis 2019, pour faciliter la mise en relation des clients avec les freelances. Nous avons une communauté de plus de 850 000 freelances, et ce sont les entreprises qui viennent les chercher. Donc, on a besoin de machine learning pour montrer les bons profils, parce qu’on ne peut pas tous les voir. Et, comme dans toutes les entreprises, l’apparition de ChatGPT et des modèles de langage a posé la question de ce qu’on pourrait mieux faire qu’avant. Car l’expérience sur Malt est très riche en texte, rien qu’avec les CV des freelances ou les jobs descriptions côté entreprise.

La genèse d’AI Search, elle est principalement côté client. On avait des entreprises qui venaient chercher des profils, mais ne savaient pas quoi taper. Comment qualifier la personne qu’on recherche ? Est-ce un data architect, un data engineer, un machine learning engineer ? Dans les grands groupes, parfois, les métiers ont des noms en interne qui ne se traduisent pas à l’extérieur. Dans le même temps, une PME qui veut créer une app pour son business ne saura pas précisément nommer le profil qu’elle recherche.

Les modèles de langage sont assez puissants pour traduire un besoin dans un set de compétences. Et c’est ce qu’on a essayé de faire avec AI Search : saisir un prompt ou uploader une job description, et traduire ça en compétences. Avant, on avait déjà une IA qui permettait de traiter des descriptions très longues et remontait des recommandations en asynchrone. Mais les gens oubliaient parfois des paramètres. AI Search a été la première expérience qui mêlait la recherche par filtres classique avec une recherche sémantique sur les compétences. Tout ça en direct.

La fonctionnalité a donc été lancée fin 2024 ?

C’était itératif. Une première version est sortie en mars 2024, sans les résultats live. Elle nous a permis d’avoir rapidement du signal, d’itérer. Une deuxième version est sortie en juillet avec d’autres éléments, une UX différente. Et on a marketé la version définitive en novembre.

Fallait-il, selon vous, attendre pour que les utilisateurs soient acclimatés aux interfaces conversationnelles pour qu’AI Search remplisse ses objectifs ?

C’est une bonne question. En 2024, on n’a pas vu de différence significative. On a observé une forte adoption dès le début, même sans les résultats live. Il y a des early adopters de l’IA, qui utilisent déjà ChatGPT. Ceux qui ne l’ont pas encore testé sont souvent ceux qui n’utilisent pas non plus notre produit pour chercher des freelances. Ils vont plutôt appeler un commercial. Donc nos utilisateurs sont déjà plutôt rompus aux principes de l’IA générative.

L’IA change l’expérience pour les freelances et vos clients, qui sont plus ou moins rompus à l’IA. Comment les avez-vous aidés à s’adapter ? Quelles tactiques avez-vous utilisées ?

C’est tout le challenge de l’UX. L’innovation technologique présente des enjeux de design. Notre but, c’est qu’il n’y ait pas besoin de formation. Pour y parvenir, on s’est appuyé sur les codes du prompt, un concept nouveau depuis ChatGPT. On a gardé une expérience non conversationnelle, avec des paradigmes habituels, tout en laissant le contrôle au client : le niveau d’IA qu’il veut utiliser, ainsi que le degré d’automatisation du process.

On a une adoption très forte. Plus de deux tiers des grands groupes avec lesquels on travaille utilisent la fonctionnalité, y compris dans le public ou le luxe. A priori, elle est facile et intuitive à utiliser.

La limite, c’est qu’on a une bonne performance sur les hard skills, mais sur les soft skills, il y a encore beaucoup de travail. Les freelances ont plutôt l’habitude de valoriser leurs hard skills, leurs expériences concrètes. Les soft skills sont moins documentés. On les récupère via les feedbacks, mais il y a un travail à faire de structuration, de formulation des bonnes questions pour ensuite faciliter la mise en relation.

Vous utilisez à la fois des grands modèles de langage externes et des modèles spécialisés, conçus en interne. Pourquoi ce choix hybride ?

On a utilisé un LLM externe pour prototyper la feature et faire la première mise en production en mars. Cela m’a permis, dès le départ, de faire une démo en quelques heures et de convaincre le leadership.

Ensuite, on a travaillé sur les cas complexes pour que cela marche en production. Un LLM génératif, c’est très bien pour prototyper vite, mais pas forcément pour scaler en production, notamment à cause de l’empreinte carbone. Ce n’est pas adapté à tous les éléments de la feature. Un petit modèle spécialisé non génératif est plus performant.

On a construit nos petits modèles avec des tâches prédictives dédiées, entraînés sur nos data. Dans d’autres domaines, comme l’e-commerce, les gros modèles sont plus puissants. Mais dans le recrutement, il y a tellement d’informations… Les petits modèles dédiés sont souvent meilleurs. Et ils ont une empreinte carbone plus basse, puisqu’on reste sur des niveaux équivalents à ceux de la recherche par mots clés. Et ça, c’était très important pour nous.

Faut-il tout dire à l’utilisateur sur le fonctionnement et les limites de l’IA ? Comment rester transparent sans casser la confiance envers le produit ?

Pour moi, on ne peut pas avoir de confiance sans être transparent. C’est quelque chose qui peut être challengé, c’est certain. Mais c’est comme ça que je vois le développement produit, surtout sur des technologies qui posent beaucoup de questions, comme l’IA. Sur la thématique des biais, c’est très important. Le monde du recrutement est biaisé. De genre, ethniques, d’âge… Sur une marketplace comme Malt, on va les retrouver. C’était déjà une question avant les LLM : quel pattern amplifie-t-on quand on met du machine learning en production ?

Chez Malt, on a des partenariats de recherche. On a eu un financement de la Commission européenne depuis deux ans pour travailler sur ces questions. On a une post-doctorante en interne qui bosse là-dessus. On a des premières mesures sur les biais de genre, pas sur tous. Effectivement, ils existent sur Malt, et certains modèles les amplifient. C’était très important de le mesurer pour pouvoir agir.

Notre point de vue, c’est que l’IA peut permettre de diversifier les profils considérés. Sans l’IA, les clients utilisent souvent des filtres très basiques : les écoles, les entreprises. Cela génère aussi des biais. Une approche par compétences permet aux clients de considérer des profils différents. Mais une fois qu’on a quatre ou cinq personnes à considérer, le choix final doit rester humain.

L’IA aide à élargir le spectre, pas à prendre la décision.

Quelles tactiques avez-vous utilisées pour encourager les utilisateurs à fournir leurs feedbacks pour améliorer AI Search ?

Chez Malt, on a trois populations dont on reçoit des feedbacks :

- Les freelances : il s’agit de notre principale population, qui a fait partie du processus de construction du produit. On a un freelance advisory board qu’on sollicite à intervalles réguliers. On passe une journée complète avec eux chaque année. Ils nous aident à prendre des décisions, à faire des arbitrages, à voir ce qu’on n’aurait pas vu.

- Les clients : on utilise des méthodes classiques de construction de produit comme de l’A/B test, par exemple, pour voir ce qui marche et ce qui ne marche pas. L’avantage, c’est qu’on a des groupes de feedback clients assez représentatifs, avec des grands groupes, des entrepreneurs, et des profils plus ou moins tech.

- Nos recruteurs internes : pour les très grands groupes, parfois, le produit ne suffit pas pour trouver le bon match, et nous avons une équipe dédiée. Ces recruteurs utilisent aussi AI Search. Ils sont une source de feedback précieuse. On leur partage les changements en amont, ça nous permet de tester.

On pourrait faire beaucoup plus, mais on a déjà une bonne base.

Lors de vos benchmarks, quelles erreurs avez-vous vues dans d’autres produits ou fonctionnalités alimentées par l’IA ? Et à l’inverse, quelles bonnes idées vous ont inspiré ?

La première vague de fonctionnalités basées sur IA, en 2023 et 2024, c’était beaucoup de chatbots. Alors que c’est, finalement, l’une des expériences les plus difficiles à réussir.

On positionne l’IA comme un humain, et ça crée des attentes très fortes chez l’utilisateur.

J’ai vu des choses assez cocasses. Je me souviens avoir testé le chatbot de Leroy Merlin. Je n’y connaissais rien au parquet, je demande des infos, il me donne trois types de parquets, c’est super. Je demande les prix, et ils sont complètement déconnants, parfois multipliés par cent. Donc, ce n’est pas facile. Ces produits ont progressivement disparu, car ils n’apportaient pas de valeur.

Mais j’ai vu des exemples intéressants, notamment chez GoJob. Ils ont une fonctionnalité de type agent IA, qui interagit par texto avec les intérimaires. Ce n’est pas vraiment un agent GoJob, c’est l’assistant IA d’une personne derrière, qui est responsable des interactions avec l’IA. J’ai trouvé ça très intéressant : quelle responsabilité humaine met-on derrière ? Quel scenario de fallback (quand le chatbot ne comprend pas la demande, NDLR) prévoit-on ?

Ce qui est sûr, c’est qu’on ne perd rien à expérimenter, et qu’il faut le faire.

Claire Lebarz, CTO chez Malt

Claire Lebarz a rejoint Malt en 2022, en tant que VP Data puis Chief AI Officer. Elle occupe le poste de CTO depuis janvier 2025. Avant cela, elle a notamment travaillé chez Airbnb pendant 6 ans.

La boîte à questions sur l'IA générative

Outils, prompts, usages professionnels, comparatifs... Posez toutes vos questions à Ludovic Salenne, expert IA !

Je pose une question