L’IA ralentit de 19 % les développeurs pour la résolution de problèmes, selon une étude

Les assistants d’IA tendraient à freiner les développeurs plutôt qu’à les aider lorsqu’il s’agit de projets complexes.

Les assistants de programmation alimentés par l’IA accélèrent-ils vraiment le développement logiciel ? C’est la délicate question qu’a voulu trancher Model Evaluation and Threat Research (METR), un institut de recherche à but non lucratif qui a déjà collaboré avec OpenAI ou Anthropic.

Selon METR, l’IA peut allonger le temps nécessaire pour résoudre certains problèmes

Pour y voir plus clair sur ce sujet qui fait débat, METR a recruté 16 développeurs qui contribuent depuis plusieurs années à des projets open source, mais qui avaient une « expérience modérée » avec les outils d’IA. Dans le cadre de l’étude, dont les conclusions ont été publiées le 10 juillet 2025, chacun d’eux a établi une liste de 246 tâches jugées utiles pour leur dépôt, allant de la correction de bugs à l’ajout de fonctionnalités, « des tâches qui font normalement partie de leur travail habituel », précise METR.

Ces tâches, pouvant être réalisées en deux heures, ont ensuite été réparties aléatoirement : certaines devaient être effectuées avec l’aide d’un assistant alimenté par l’IA, d’autres sans. Lorsqu’ils avaient recours à l’intelligence artificielle, les développeurs utilisaient Cursor Pro, un outil propulsé par Claude 3.5 Sonnet ou Claude 3.7 Sonnet, soit « les modèles les plus avancés disponibles au moment de l’étude », détaille l’institut de recherche.

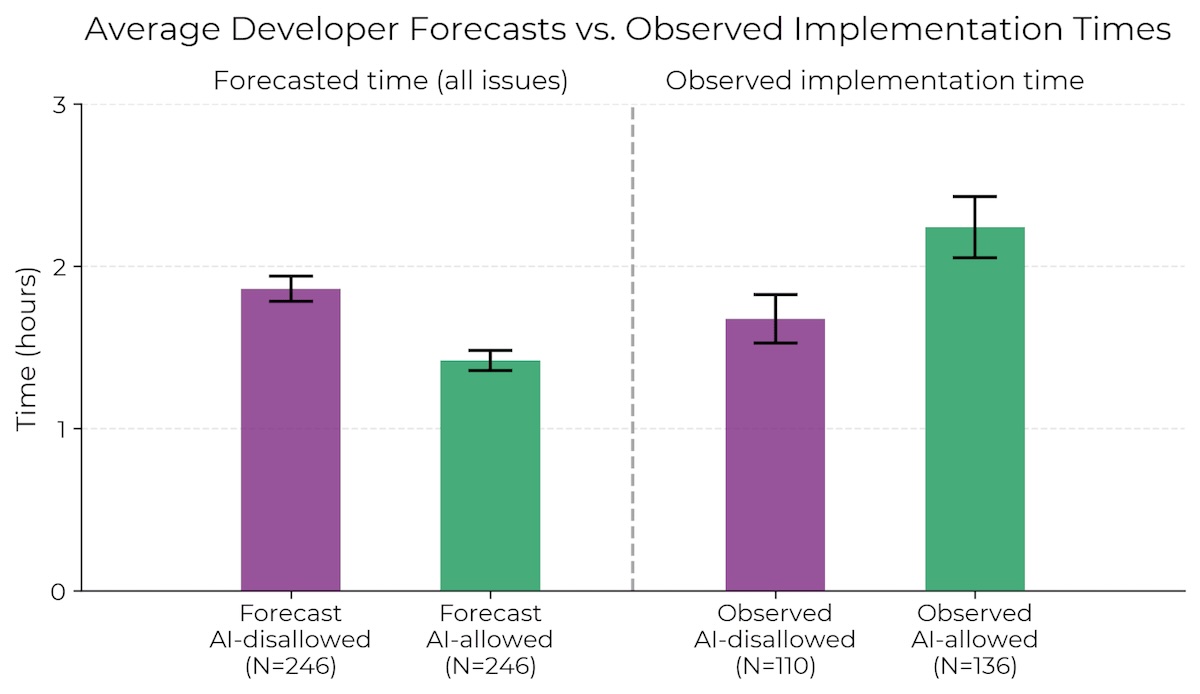

Et surprise : l’étude conclut à un « écart entre perception et réalité ». Lorsque les développeurs ont été autorisés à recourir à des outils dopés à l’IA, ils ont mis 19 % de temps en plus pour résoudre les problèmes, s’étonnent les chercheurs. Ils s’attendaient pourtant à ce que « l’IA les accélère de 24 % et, même après avoir vécu le ralentissement, ils continuaient à croire que l’IA les avait accélérés de 20 % », note METR.

Pourquoi l’IA a-t-elle freiné les développeurs ?

Pour expliquer l’écart entre les attentes des développeurs et les résultats observés, METR a identifié plusieurs facteurs explicatifs :

- Des attentes excessives : les développeurs pensaient que l’IA allait considérablement accélérer le temps d’implémentation.

- Une forte expertise : les participants connaissaient si bien leur projet que l’IA avait peu de valeur à leur apporter. « Les développeurs ralentissent davantage sur les problèmes qu’ils ne connaissent pas », précise METR.

- Un déficit de contexte : l’IA peinait à appréhender l’environnement dans lequel elle opérait.

- Une fiabilité insuffisante : seuls 44 % des suggestions générées par l’IA ont été approuvées par les développeurs. Les participants ont passé beaucoup de temps à corriger ou réviser le code qui avait été généré.

- Des environnements complexes : sur des dépôts qui ont en moyenne une dizaine d’années, avec plus d’un million de lignes de code, les limites de l’IA sont vite apparues.

Il peut exister un effet d’apprentissage pour les outils IA comme Cursor qui ne se manifeste qu’après plusieurs centaines d’heures d’usage. Nos participants n’en sont pas là, tempère néanmoins METR.