IA : les meilleurs modèles pour le code et le développement web en février 2026

Anthropic, OpenAI et Google dominent toujours la WebDev Arena en février 2026, mais les acteurs chinois confirment leur montée en puissance.

La course à l’intelligence artificielle ne se joue pas uniquement sur le terrain du grand public. Dans l’univers du développement web et logiciel, les modèles spécialisés dans le code font l’objet d’une concurrence tout aussi intense. Si les poids lourds du secteur continuent d’innover à un rythme soutenu, certains acteurs plus discrets parviennent également à se distinguer. Alors, quels modèles dominent réellement les tâches de programmation en ce mois de janvier 2026 ? Éléments de réponse avec le classement de la WebDev Arena.

Anthropic conserve la tête du classement

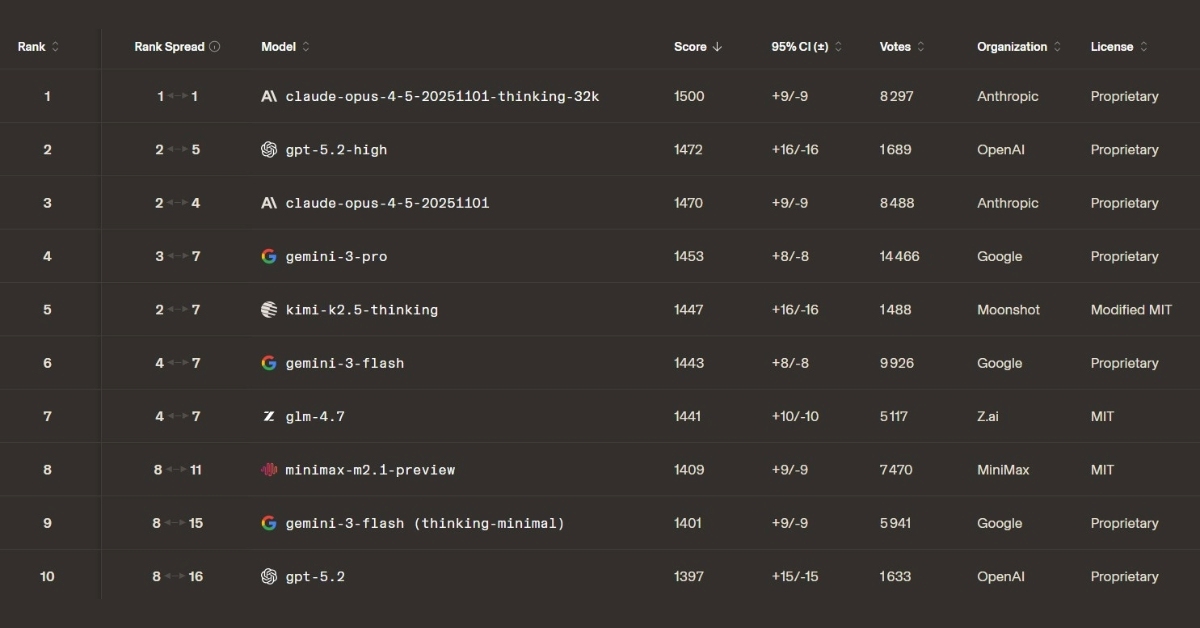

Claude est souvent considéré comme l’IA la plus aboutie pour le développement web. Le classement de février 2026 valide cette réputation : Claude Opus 4.5 Thinking conserve solidement la première place de la WebDev Arena, avec une avance nette sur ses concurrents. Sa version standard confirme également sa constance en se maintenant sur le podium.

OpenAI reste au contact grâce à GPT-5.2 High, déjà deuxième le mois précédent. Le modèle confirme les progrès apportés par cette déclinaison orientée performances. Google, leader des classements généraux, se trouve ici assez nettement distancé : son modèle le plus performant, Gemini-3-Pro, doit se contenter de la quatrième place.

Le reste du classement met en lumière plusieurs acteurs chinois. MiniMax, déjà présent en janvier, reste solidement ancré à la 8e place, tandis que les modèles Z.ai (lié à l’université Tsinghua) et Kimi (développé par Moonshot AI) font leur entrée dans le top 10.

Les 10 modèles d’IA les plus performants pour le code et le développement web en février 2026 :

- Claude Opus 4.5 Thinking : 1500 (score Elo)

- GPT-5.2 High : 1472

- Claude Opus 4.5 : 1470

- Gemini 3 Pro : 1453

- Kimi-k2.5 Thinking : 1447

- Gemini 3 Flash : 1443

- GLM-4.7 (Z.ai) : 1441

- Minimax-m2.1-preview : 1409

- Gemini 3 Flash (thinking-minimal) : 1401

- GPT-5.2 : 1397

Découvrir le classement complet

Les critères de classement de la WebDev Arena

La WebDev Arena mesure les performances des modèles d’IA à partir de comparaisons en conditions anonymes. Deux systèmes sont soumis à une consigne identique et génèrent chacun une réponse, que les internautes évaluent ensuite sans savoir quel modèle en est l’auteur. Leur choix permet d’identifier la proposition la plus pertinente. Les résultats alimentent un classement fondé sur un score Elo, utilisé notamment dans les classements d’échecs : une victoire face à un modèle bien classé rapporte davantage de points, tandis qu’un revers contre un concurrent moins bien placé entraîne une pénalité plus importante. Le classement évolue en continu au rythme des votes.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis