Classement : les 10 modèles d’IA les plus performants en août 2024

Jusqu’ici légèrement en retrait par rapport aux modèles d’OpenAI, Gemini s’impose désormais comme un concurrent sérieux, selon la Chatbot Arena.

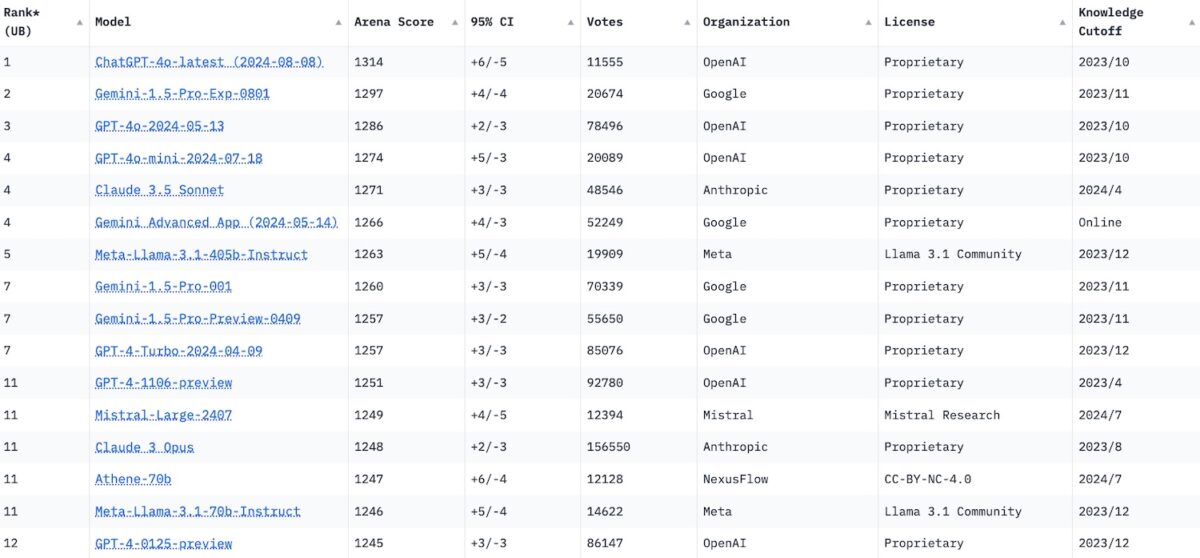

En matière de performance, les modèles de langage d’OpenAI sont désormais concurrencés par ceux développés par Google pour son agent conversationnel Gemini. C’est du moins ce que révèle la récente mise à jour de la Chatbot Arena, un classement conçu par des chercheurs et des étudiants de la prestigieuse Université de Berkeley, aux États-Unis, avec le soutien d’HuggingFace.

Mis à jour en temps réel et attribuant un score de performance à chaque modèle d’IA, la Chatbot Arena vise à hiérarchiser objectivement les IA génératrices de texte en s’appuyant sur les contributions des utilisateurs. Ces derniers sont invités à évaluer, sur la base d’une même requête, les réponses fournies par deux modèles d’IA dont l’identité leur est cachée.

Les 10 modèles de langage les plus performants en août 2024

En juillet 2024, la société créatrice de ChatGPT, bien aidée par le déploiement de GPT-4o mini, s’emparait de cinq des dix premières positions de ce classement. Elle reléguait au passage la plupart de ses concurrents hors du top 10, à l’exception d’Anthropic et de Google. La firme de Mountain View, jusqu’ici en léger retrait, a répliqué ce mois-ci en lançant Gemini 1.5 Flash : un modèle censé être plus efficace dans ses réponses et qui a été intégré à la version gratuite de son chatbot éponyme.

Grâce à sa technologie dernier cri, Google s’invite donc sur le podium de la Chatbot Arena, tout en occupant parallèlement plusieurs places d’honneur (6e, 8e et 9e). OpenAI conserve toutefois une belle avance, plaçant deux itérations sur le podium et quatre dans le top 10. Dans le reste du classement, Meta se hisse en septième position avec Meta Llama 3.1, tandis qu’Anthropic perd deux positions avec Claude 3.5 Sonnet, son modèle le plus avancé.

- ChatGPT 4o Latest : 1314 (score Elo)

- Gemini 1.5 Pro 0801 : 1297

- GPT-4o 0513 : 1286

- GPT-4o mini 0718 : 1274

- Claude 3.5 Sonnet : 1271

- Gemini Advanced : 1266

- Meta Llama 3.1 : 1263

- Gemini 1.5 Pro : 1260

- Gemini 1.5 Pro Preview : 1257

- GPT-4 Turbo 0409 : 1257

Les critères de classement de la Chatbot Arena

Conçue par la Large Model Systems Organization (LMSYS) qui regroupe des étudiants et des chercheurs américains, la Chatbot Arena utilise le système Elo pour hiérarchiser les modèles génératifs. Mais de quoi s’agit-il, au juste ? Ce système d’évaluation, utilisé dans plusieurs disciplines compétitives comme l’esport ou les échecs, a l’avantage d’être parfaitement adapté au principe de duel sur lequel repose la Chatbot Arena, ainsi que « de prédire l’issue du [prochain] match », selon LMSYS.

Un score Elo peut être assimilé à une cote provisoire, qui évolue en fonction des performances. Si, lors d’un duel, un modèle génératif ayant un score élevé, comme Gemini 1.5 Pro ce mois-ci, subit une défaite contre un adversaire plus faible, comme Claude 3.5 Sonnet, il perdra des points. À l’inverse, il en engrangera s’il gagne contre un modèle supposément plus fort.

Le système Elo est aussi utilisé par Artificial Analysis, l’organisme qui propose un classement semblable pour les IA génératrices d’images, comme Midjourney ou DALL-E.