Modération allégée, haine décuplée : Meta face à une explosion des contenus nocifs

Une enquête révèle une forte hausse des contenus haineux sur Facebook, Instagram et Threads, depuis l’allègement des politiques de modération chez Meta.

En janvier 2025, Meta a annoncé un tournant majeur dans sa politique de modération des contenus, en supprimant notamment la vérification des faits par des tiers aux États-Unis et en allégeant considérablement sa politique mondiale contre les discours haineux. Ces changements, qualifiés par certains de « virage MAGA », en référence aux soutiens du président américain Donald Trump, ont soulevé des inquiétudes quant à la sécurité des utilisateurs et utilisatrices, en particulier les personnes issues de groupes historiquement marginalisés.

En l’absence de données transparentes fournies par Meta, les organisations GLAAD, UltraViolet et All Out ont mené une vaste enquête pour évaluer l’impact concret de ces décisions sur les utilisateurs et utilisatrices. L’étude repose sur les réponses de plus de 7 000 personnes issues de 86 pays, ciblant en particulier les utilisateurs appartenant à ce que Meta qualifie de « groupes protégés » (caractéristiques comme le genre, l’orientation sexuelle, la religion, etc.).

Les résultats du rapport, dénommé Make Meta Safe, sont sans appel : les contenus nocifs sont en hausse, la liberté d’expression est en recul et le sentiment de sécurité s’effondre sur Facebook, Instagram et Threads.

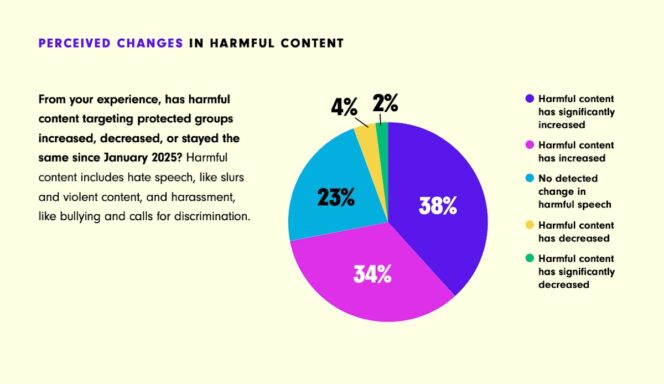

Une hausse massive des contenus nocifs perçue par les utilisateurs

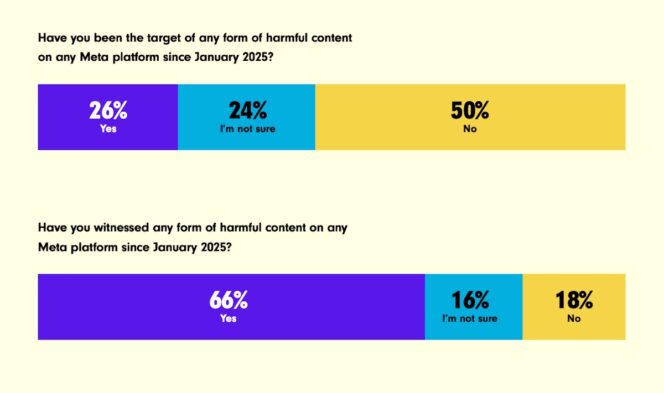

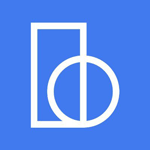

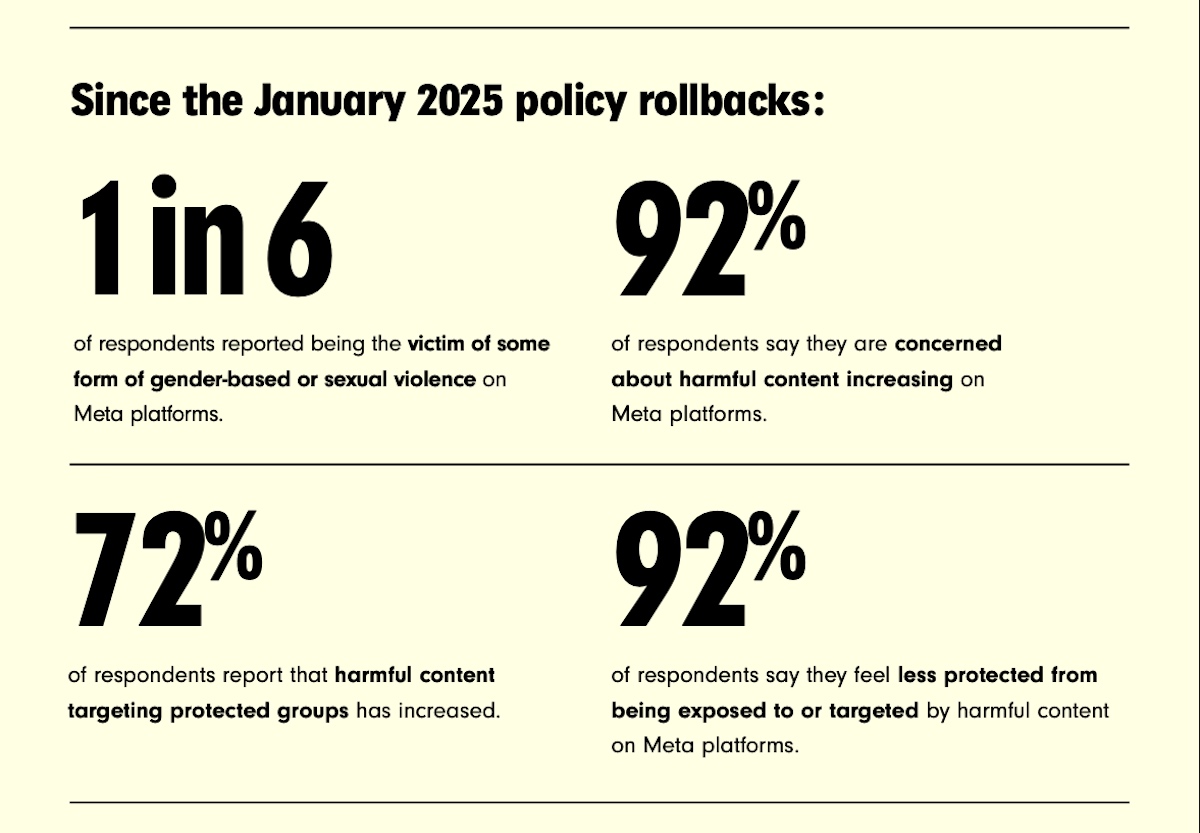

Depuis le début de l’année 2025, les plateformes de Meta sont devenues, selon leurs propres usagers, nettement plus hostiles. C’est le principal constat de l’étude (voir image de une) : deux tiers des répondants (66 %) affirment avoir été exposés à du contenu nocif sur Facebook, Instagram ou Threads depuis les modifications de politique annoncées par Meta en janvier. Pire encore, plus d’une personne sur quatre déclare avoir été directement visée par ce type de contenu, tandis que 72 % estiment que les publications ciblant les « groupes protégés » ont augmenté.

Ces « contenus nocifs » sont ici définis en accord avec les propres standards de Meta : propos ou images visant une personne sur la base d’un critère comme le sexe, la religion, l’origine ethnique, l’orientation sexuelle ou le handicap. Or, la suppression de la vérification par des tiers aux États-Unis, combinée à l’assouplissement global des règles autour des discours de haine, semble avoir ouvert la voie à un flot incontrôlé de publications violentes ou déshumanisantes.

En parallèle, les signalements effectués par les utilisateurs et utilisatrices ne semblent plus suivis d’effet. De nombreux témoignages rapportent que les contenus clairement haineux ou menaçants sont jugés conformes par Meta. Plusieurs répondants expliquent avoir vu leurs alertes rejetées « en moins d’une minute », même lorsqu’il s’agissait d’incitations explicites à la violence ou d’attaques ciblées. Une perte de confiance s’installe, alimentée par le contraste entre la politique officielle de la plateforme et la réalité du terrain.

Nous appelons Meta à analyser formellement les évolutions des contenus nocifs engendrées par ses changements de politique, et à rétablir d’urgence les protections ainsi qu’une modération étendue des contenus pour les utilisateurs, lit-on dans le rapport.

Des groupes marginalisés massivement ciblés

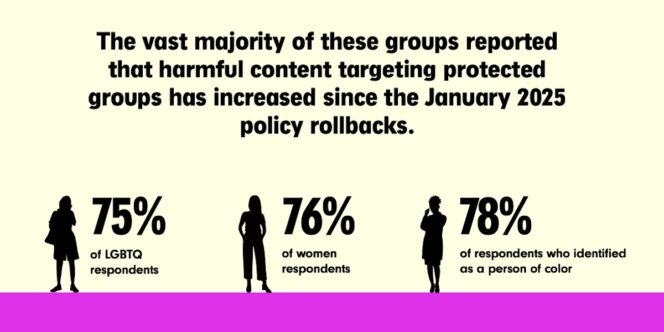

Les effets de la dérégulation chez Meta ne sont pas ressentis de manière uniforme. L’enquête révèle un impact disproportionné sur les personnes appartenant à des groupes historiquement marginalisés, ceux-là mêmes que Meta identifie comme « groupes protégés » dans ses standards communautaires. Parmi les répondants LGBTQ+, 75 % déclarent avoir été personnellement ciblés par du contenu nocif depuis janvier 2025. Ce chiffre grimpe à 76 % chez les femmes et à 78 % chez les personnes s’identifiant comme racisées.

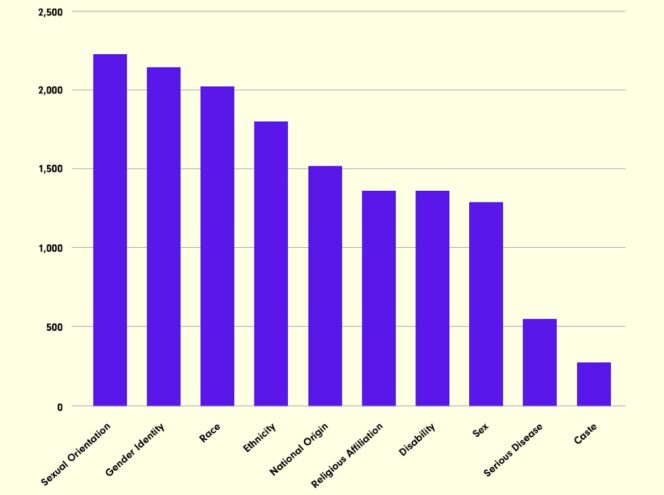

Les formes de contenu signalées sont multiples : insultes, stéréotypes racistes ou sexistes, appels à la haine, mèmes déshumanisants ou encore justifications de violences physiques. L’étude rapporte également une recrudescence de contenus appelant explicitement à la discrimination et à l’exclusion de certaines populations, voire à des violences à leur encontre. Les propos collectés dans l’étude illustrent la brutalité de certaines attaques. Dans plusieurs cas, les messages ont été signalés… sans être supprimés.

Ces éléments montrent une normalisation inquiétante de discours auparavant modérés, voire bannis. L’étude note par ailleurs que les attaques les plus fréquentes concernent l’orientation sexuelle, l’identité de genre et l’origine ethnique ou nationale. Ce sont là les quatre caractéristiques les plus ciblées d’après les réponses au sondage.

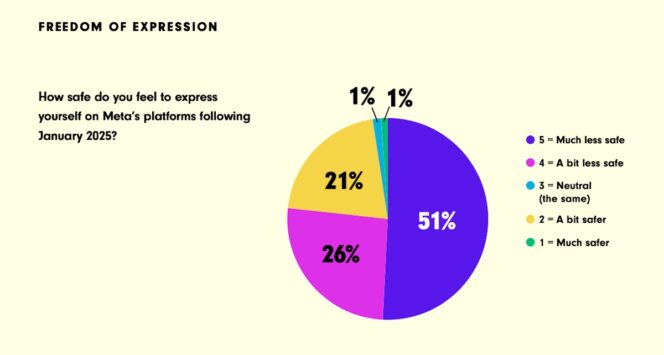

Un climat numérique plus hostile, entre autocensure et sentiment d’insécurité

Au-delà de la multiplication des attaques, l’étude met en lumière une conséquence plus insidieuse : les utilisateurs et utilisatrices, en particulier issus de « groupes protégés », se sentent de moins en moins libres de s’exprimer sur les plateformes de Meta. Depuis les changements de politique, 77 % des répondants disent se sentir moins en sécurité lorsqu’ils s’expriment et 92 % se sentent moins protégés d’une exposition aux contenus nocifs.

Ce climat de méfiance touche tout particulièrement les femmes, les personnes LGBTQ+ et les personnes racisées. Parmi les répondants LGBTQ+, 81 % affirment se sentir moins libres de s’exprimer, un chiffre qui atteint 77 % chez les personnes racisées et 83 % chez les femmes. Ces données révèlent une autocensure généralisée, motivée par la peur de représailles, de harcèlement ou d’attaques personnelles.

Les témoignages recueillis illustrent ce recul de la liberté d’expression : menaces pour avoir exprimé une opinion politique, publications bloquées ou mises sous surveillance pour des contenus pro-féministes ou pro-LGBTQ+, sentiment d’être ciblé pour de simples commentaires. Certains répondants affirment même éviter désormais certains sujets ou hashtags, de peur d’être repérés et attaqués. L’effet combiné d’une modération affaiblie et d’une tolérance accrue pour les discours haineux génère un environnement numérique perçu comme plus dangereux, moins encadré et fondamentalement inégal selon les profils.

Des violences sexistes et sexuelles numériques largement tolérées

L’une des conclusions les plus alarmantes de l’étude concerne l’augmentation des violences sexistes et sexuelles en ligne. Depuis les modifications de politique annoncées par Meta, 23 % des usagers rapportent avoir été victimes de violences de genre ou sexuelles sur les plateformes du groupe. Ce chiffre grimpe à 27 % chez les personnes LGBTQ+ et 35 % chez les personnes racisées, confirmant une exposition disproportionnée des groupes marginalisés.

Parmi les formes les plus fréquemment citées, on trouve le harcèlement, la traque numérique, la diffusion non consentie de contenus intimes, la sextorsion, le revenge porn ou encore les deepfakes à caractère sexuel. Les récits recueillis donnent à nouveau un aperçu glaçant de la réalité vécue.

L’étude rappelle que ces violences en ligne ont des conséquences bien réelles, d’autant plus graves qu’elles touchent des publics déjà exposés à des violences dans la sphère physique. Dans certains pays, notamment en Amérique latine, des répondants signalent un effet d’escalade entre haine numérique et agressions dans la vie réelle. Le cas de Sara Millerey González, femme trans assassinée en Colombie après avoir été ciblée en ligne, est cité comme symbole de cette porosité entre violence virtuelle et violence concrète.