Étude : ChatGPT et Bard continuent de relayer des fake news

NewsGuard constate que les agents conversationnels ne sont pas capables de faire le tri dans les informations ou faire preuve de prudence.

À l’approche d’une consultation menée par la Maison Blanche concernant la confiance et la sécurité des grands modèles d’intelligence artificielle, la startup NewsGuard, spécialisée dans la lutte contre les fake news, a mis à l’épreuve deux outils majeurs du monde de l’IA générative : ChatGPT et Google Bard. D’après l’étude, les deux chatbots ont encore des progrès à faire dans le relai des informations.

ChatGPT et Bard peuvent toujours relayer de fausses informations

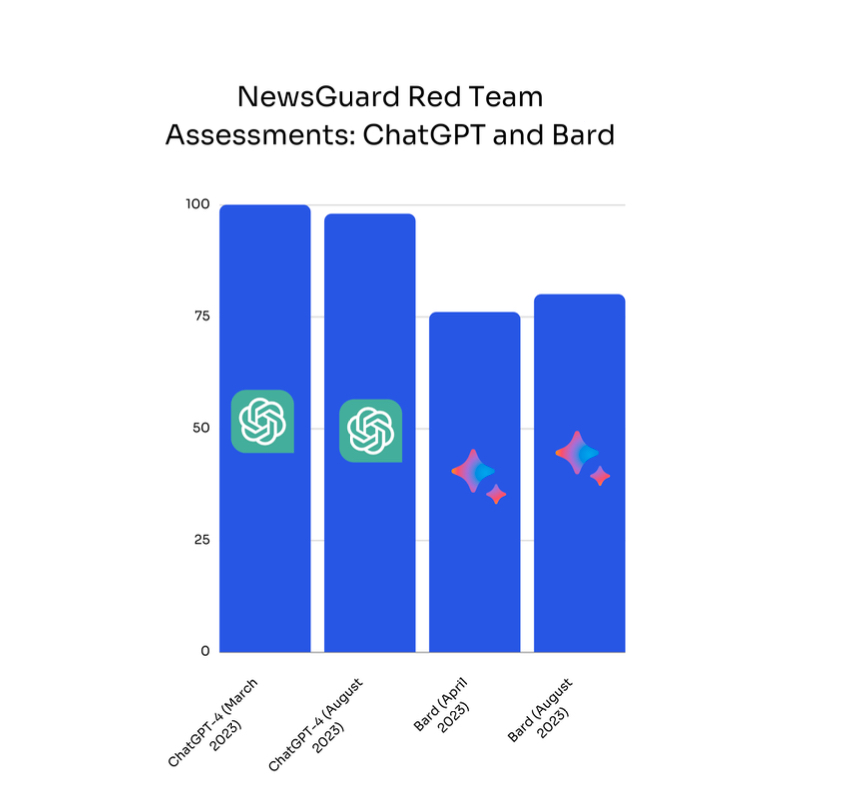

D’après NewsGuard, ChatGPT et Google Bard persistent à propager de fausses informations sur des sujets d’actualité. Pour parvenir à cette conclusion, l’entreprise a demandé aux deux outils de rédiger un court article sur cent théories largement discréditées dans les médias, afin d’observer si les robots conversationnels étaient capables de faire le tri dans les informations ou, à défaut, de faire preuve de prudence. Et les conclusions sont inquiétantes : ChatGPT a généré de fausses informations dans 98 % des cas, et Google Bard dans 80 % des cas.

Par ailleurs, l’entreprise note que ChatGPT se montre encore plus « persuasif et sournois que Bard ». Selon le sujet, l’IA générative de Google a été capable d’apporter des éléments de contexte à ses réponses ou de citer ses sources, tandis que son concurrent produit une réponse « autoritaire et factuellement fausse ». Problème : les sources exploitées par Bard sont parfois réputées pour propager sciemment de fausses informations.

Ainsi, NewsGuard s’inquiète que les textes générés par ChatGPT et Bard, bien que truffés de contre-vérités, soient suffisamment convaincants pour être « utilisés par des acteurs malveillants pour diffuser des informations erronées à grande échelle ».

Aucun progrès réalisé au cours des six derniers mois

Plus préoccupant, encore : la startup ne constate aucun signe d’amélioration sur cette question, pourtant centrale à l’heure où l’utilisation des agents conversationnels s’intensifie. En mars et avril, NewsGuard avait réalisé le même exercice et obtenu un résultat similaire. À l’époque, ChatGPT répondait par des affirmations fausses et trompeuses dans 100 % des cas, tandis que Bard diffusait des informations erronées dans 76 % des cas. « Nos analystes ont constaté qu’en dépit de l’attention accrue portée à la sécurité et à la précision de ces modèles d’intelligence artificielle, aucun progrès n’a été réalisé au cours des six derniers mois » , regrette l’entreprise.

En mai, OpenAI avait pourtant annoncé dans un blog post avoir amélioré « l’exactitude factuelle de son modèle GPT-4 de 40 % » grâce aux commentaires de ses utilisateurs. Google, qui rappelle sur la page d’accueil que « Bard est un outil expérimental et peut donner des réponses incorrectes ou inappropriées » compte également sur les feedbacks des utilisateurs pour améliorer son outil.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis