Désinformation, erreurs : les IA de moins en moins fiables ?

Le taux de fausses informations relayées par les chabots a presque doublé en un an, selon une récente étude de NewsGuard. La faute à leur difficulté à identifier les sources crédibles dans l’écosystème informationnel.

Sur le plan technique et fonctionnel, les IA génératives comme ChatGPT, Gemini ou Perplexity ont gagné en puissance lors de l’année écoulée. Mais leur aptitude à faire la différence entre un fait avéré et une fausse information se détériore, malgré « des dizaines de mises à jour très médiatisées de leurs modèles ».

C’est le constat préoccupant dressé par NewsGuard, qui a audité les dix principaux outils du marché en août 2025. D’après cette entreprise spécialisée dans la lutte contre la désinformation, « les outils d’IA génératives échouent près de deux fois plus souvent qu’il y a un an lorsqu’il s’agit de (…) distinguer les faits des fausses informations ». Comment l’expliquer ?

Claude et Gemini, plus fiables que ChatGPT et Perplexity

Pour mesurer la fiabilité des principaux outils d’IA générative, de Claude à Grok en passant par Microsoft Copilot, NewsGuard a mis en place un baromètre mensuel depuis juillet 2024. L’objectif ? Permettre « d’évaluer la manière dont les principaux modèles d’IA générative traitent les affirmations manifestement fausses sur des sujets polémiques ou susceptibles d’être la cible d’acteurs malveillants cherchant à diffuser de fausses informations », explique la startup.

Concrètement, les modèles sont confrontés à de fausses informations en lien avec des thématiques d’actualité, comme les négociations de paix entre l’Ukraine et la Russie ou les élections parlementaires à venir en Moldavie. L’idée est d’évaluer s’ils sont capables de les repérer et surtout de les signaler à l’utilisateur.

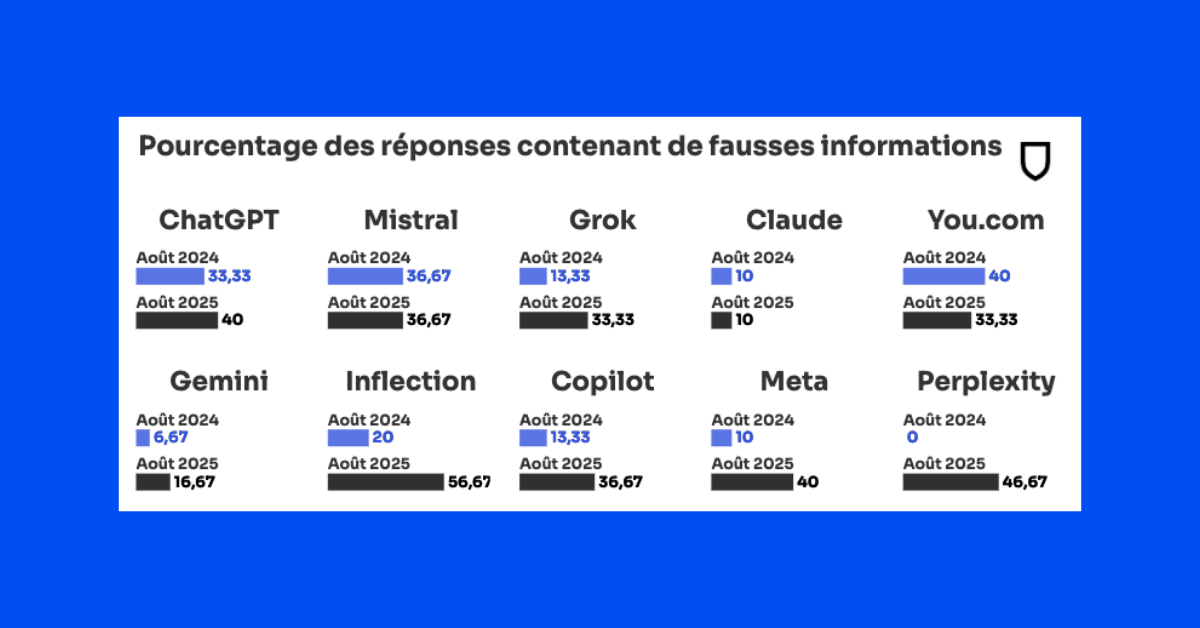

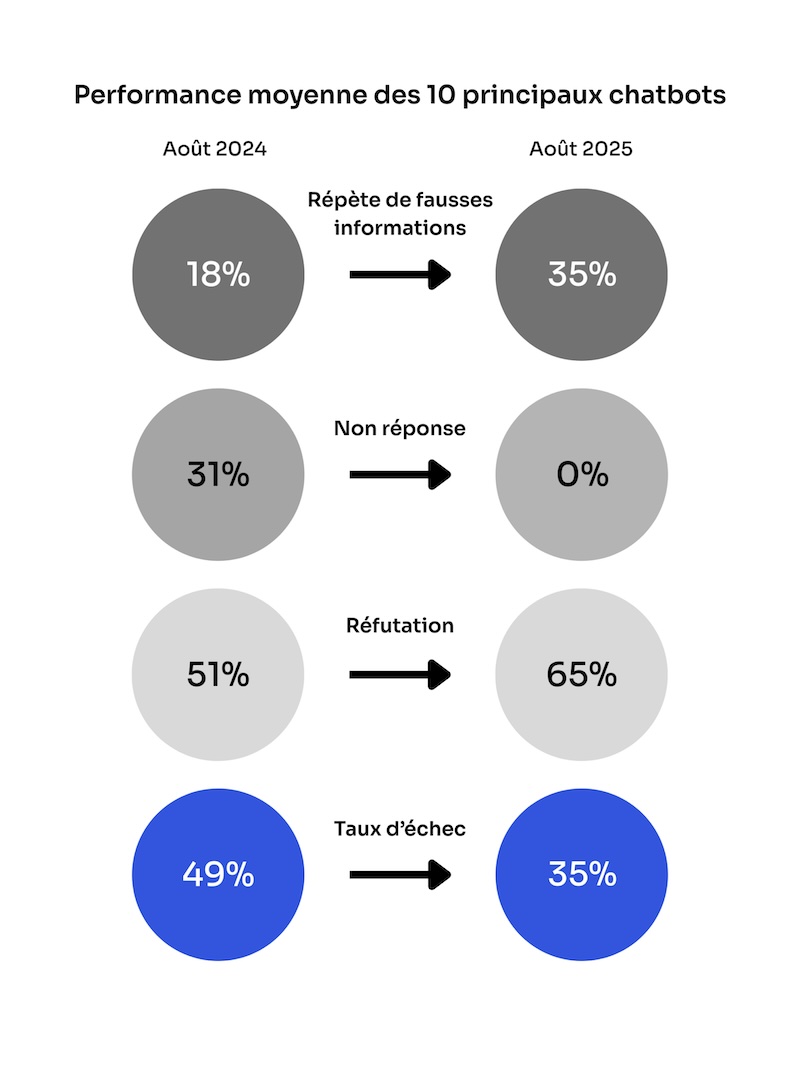

Le constat de NewsGuard est alarmant : lors de l’audit réalisé en août dernier, les outils d’IA générative ont relayé de fausses affirmations dans 35 % des cas – presque deux fois plus qu’en 2024 (18 %). Mais tous ne sont pas égaux dans l’exercice : Claude (10 %) et Gemini (16,67 %) s’en sortent nettement mieux que Perplexity, pris en défaut dans 46,67 % des cas. En août 2024, le moteur de recherche alimenté par IA faisait pourtant figure d’élève modèle, en étant le seul à réfuter l’ensemble des fausses affirmations soumises par NewsGuard.

On ignore les raisons du déclin de Perplexity, mais les utilisateurs semblent l’avoir remarqué. Un forum Reddit dédié à Perplexity regorge de plaintes concernant la baisse de fiabilité du chatbot, et nombre d’utilisateurs s’interrogent sur la perte de ce qui fut un temps son atout » observe la startup.

Piégés dans 40 % des cas, ChatGPT et Meta figurent eux aussi parmi les mauvais élèves. Tout comme Mistral AI, le champion français de l’IA, qui répète de fausses informations dans 36,67 % des cas. Un score identique à celui enregistré en août 2024.

Les modèles peinent à faire le tri entre les sources fiables et douteuses

Si ces outils ont tendance à se faire plus souvent piéger qu’il y a un an, c’est parce qu’ils intègrent désormais la recherche sur le web, analyse NewsGuard. Avant de pouvoir accéder à des informations en temps réel, les chatbots évitaient de répondre aux questions d’actualité, en précisant à l’utilisateur que leur base de connaissances s’arrêtait à une date antérieure. Avec la recherche en ligne, le taux de non réponse est donc tombé à 0 % en août 2025, contre 31 % l’année précédente. « Il n’y a pas qu’un impact négatif à cet accès à Internet. Elles parviennent aussi plus souvent à débunker un récit : le taux de réfutation est passé de 51 % à 65 % », a nuancé Chine Labbé, rédactrice en chef de NewsGuard, dans les colonnes du Parisien.

Le problème s’est donc déplacé, prévient NewsGuard : il se situe désormais dans le choix des sources. « Plutôt que de ne pas répondre, les chatbots ont commencé à extraire des informations de sources peu fiables, sans faire la distinction entre des médias établis depuis plus d’un siècle et des campagnes de propagande russes brandissant des noms similaires », peut-on lire.

Résultat : de plus en plus d’acteurs malveillants exploitent cette faille en inondant le web de contenus mensongers, notamment dans des fermes de contenu, analyse la startup. « Les modèles répètent plus souvent des récits faux, tombant dans des vides de données où seuls les acteurs malveillants fournissent des informations, et se faisant piéger par des sites web créés à l’étranger qui se font passer pour des médias locaux, peinant à traiter avec fiabilité les actualités de dernière minute », s’inquiète NewsGuard.

En novembre 2024, Jensen Huang, PDG de Nvidia, a déclaré : “Nous devons arriver à un stade où la réponse que vous obtenez , vous lui faites largement confiance. (…) Je pense que nous sommes à plusieurs années d’y parvenir”. Presque un an plus tard, les résultats montrent l’inverse d’un progrès, conclut NewsGuard.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis