Comment empêcher Claude de s’entraîner sur vos données

À partir du 28 septembre 2025, Anthropic exploitera les conversations des utilisateurs avec Claude pour entraîner ses modèles d’IA. Mais il est possible de facilement s’y opposer.

Anthropic a annoncé, dans un communiqué publié ce jeudi 28 août 2025, que ses modèles d’IA s’entraîneront bientôt sur les données des utilisateurs de Claude, en particulier leurs conversations et leurs « sessions de codage », à moins qu’ils ne choisissent de s’y opposer.

La mise à jour concerne les utilisateurs gratuits ainsi qu’une partie des abonnés payants

Cette mise à jour des conditions d’utilisation et de la politique de confidentialité concerne les utilisateurs gratuits, ainsi que les abonnés aux formules Pro et Max. « Elles ne s’appliquent pas aux services relevant de nos conditions commerciales, y compris Claude for Work, Claude Gov, Claude for Education ou l’utilisation de l’API, notamment via des tiers comme Amazon Bedrock et Google Cloud Vertex AI », explique le communiqué.

Toutefois, seules les nouvelles conversations et sessions de codage avec Claude seront exploitées à des fins d’entraînement, précise Anthropic. Un choix justifié par la volonté d’améliorer son produit, tout en renforçant ses « dispositifs de protection contre les usages malveillants ». En outre, l’entreprise a allongé la durée de conservation des chats à cinq ans, contre 30 jours auparavant. « Si vous choisissez de ne pas fournir vos données à des fins d’entraînement, la durée de conservation restera fixée à 30 jours », complète Anthropic.

Comment s’opposer à l’exploitation de vos conversations avec Claude ?

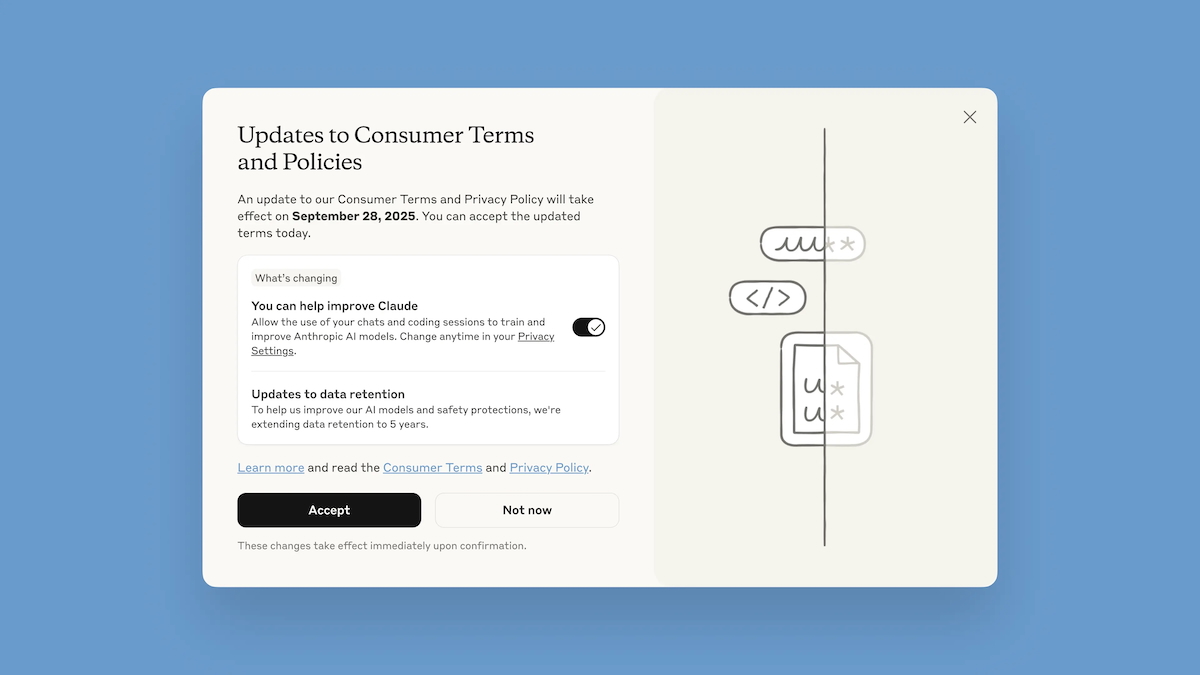

Les utilisateurs de Claude ont jusqu’au 28 septembre 2025 pour consentir à l’exploitation de leurs données. Depuis ce jeudi, Anthropic a mis en place une fenêtre pop-up (voir image de une) qui s’affiche lors de la reconnexion et permet de « prendre connaissance de ces mises à jour » ainsi que gérer ses paramètres. Pour empêcher Anthropic d’exploiter vos données, il suffit de décocher l’option You can help improve Claude.

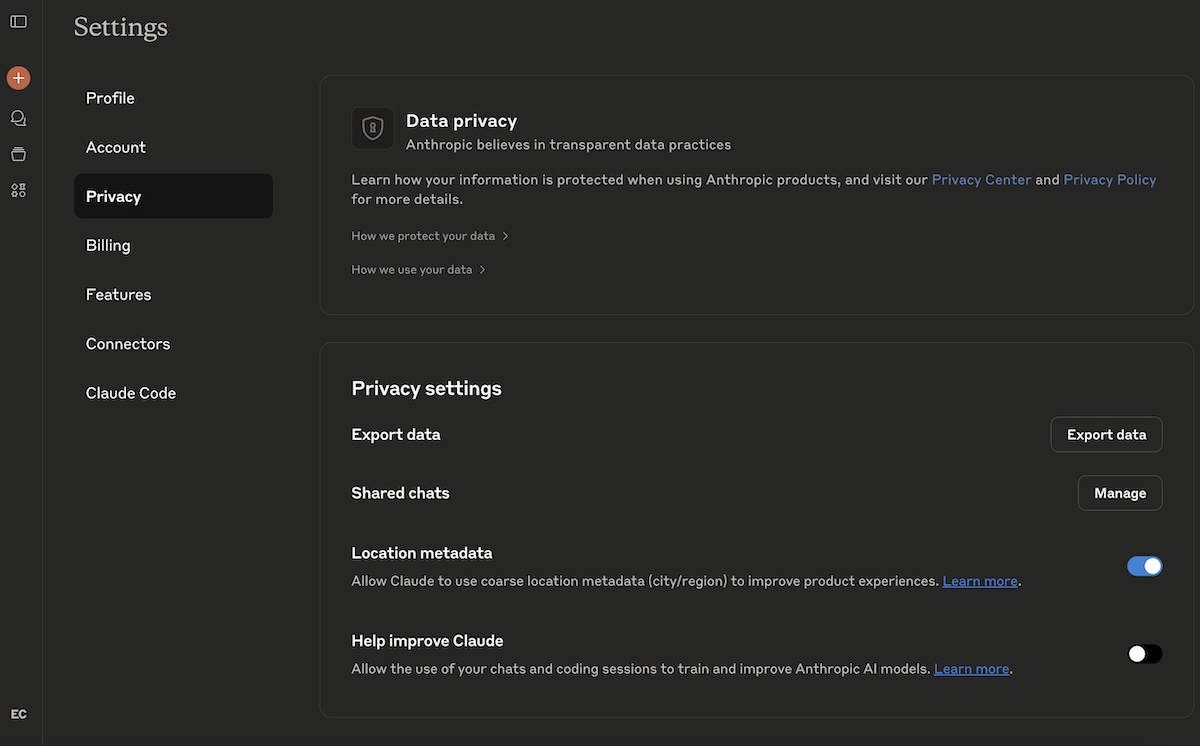

Elle peut également être désactivée via les paramètres, en suivant ces étapes :

- Cliquez sur votre nom de profil,

- Sélectionnez Privacy,

- Décochez l’option Help Improve Claude.

Quant aux nouveaux inscrits, ils devront décider, lors de la création de leur compte, s’ils autorisent ou non l’utilisation de leurs données à des fins d’entraînement. Ce choix n’est pas définitif, et pourra être modifié à tout moment en suivant la procédure décrite ci-dessus.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis