Canvas : BDM a comparé ChatGPT, Gemini, Claude et Le Chat

BDM a testé la fonction de plan de travail, ou Canvas, des principaux outils d’IA. Lesquels offrent la meilleure expérience et les performances les plus abouties ? Réponse ci-dessous !

Il y a encore deux ans, les outils d’IA générative mettaient en avant certains facteurs différenciants pour se démarquer. Aujourd’hui, leurs fonctionnalités tendent à s’uniformiser. Mais offrent-elles réellement le même niveau de performance ? Pour y répondre, BDM a comparé les fonctionnalités des principaux outils disponibles sur le marché.

Dans cet article, nous nous intéressons aux plans de travail. Cette option a été initiée par Claude à l’été 2024, sous le nom d’Artefacts. Elle permet d’ouvrir un espace de travail parallèle, distinct de la conversation principale, où les résultats générés par l’IA sont présentés de façon claire et modifiable. Lorsqu’un utilisateur demande un contenu structuré ou volumineux (comme un texte, du code ou un tableau) le système crée automatiquement une fenêtre dédiée, à droite de l’interface, dans laquelle le contenu peut être consulté, ajusté ou enrichi sans interrompre l’échange en cours. Ce mode d’affichage facilite les itérations, la visualisation des révisions en temps réel et la collaboration sur des projets complexes. Les artefacts ont depuis été repris par ChatGPT, Gemini et Le Chat, qui ont tous adopté le nom « Canvas ». Mais les IA sont-elles toutes aussi performantes ?

Canvas : les paramètres du test

Pour notre test, nous avons réalisé une maquette de newsletter hebdomadaire pour un média fictif intitulé TechScope. L’objectif : observer comment chaque outil gère la création, la révision et la mise en forme d’un même projet à partir de consignes identiques. Le travail s’est déroulé en quatre étapes successives.

- Création : chaque IA devait générer la première version complète de la newsletter au format HTML, avec le style intégré. Le plan imposé comportait un en-tête avec le titre et la date, une introduction de trois phrases, puis trois rubriques distinctes : Actualités, Dossier et Veille d’outils.

- Révision éditoriale : à partir de cette première maquette, nous avons demandé aux IA de reformuler le texte pour adopter un ton plus conversationnel et engageant, tout en conservant rigoureusement la même mise en page.

- Mise en forme visuelle : les modèles ont ensuite dû améliorer le rendu esthétique selon une palette de couleurs donnée et des consignes précises : présentation déroulante des outils, typographie sans-serif, effets au survol et hiérarchie visuelle plus marquée. À cette étape, nous avons également demandé un CTA renvoyant vers BDM Tools sous la section Veille d’outils.

- Actualisation du contenu : enfin, chaque IA devait actualiser les sections Actualités et Dossier à partir des derniers articles publiés récemment sur BDM, sans copier le texte source. Pour cette étape, nous avons uniquement fourni le lien vers le site, pour voir si les IA étaient en mesure d’extraire le contenu pour la réalisation de la newsletter.

Canvas dans ChatGPT : notre test

Avec Canvas, ChatGPT livre un premier jet convaincant pour notre newsletter. Les différentes sections sont bien présentes, et le ton neutre et factuel est bien respecté. Dans la rubrique Dossier, l’outil ajoute même un CTA « Lire le dossier maintenant ». Un élément non demandé, mais bien intégré à l’ensemble. Le changement de ton attendu lors de la réécriture est perceptible, quoiqu’un peu timide : malgré la consigne d’utiliser le tutoiement, ChatGPT conserve un ton formel.

En revanche, les ajustements de mise en forme sont parfaitement compris. La palette de couleurs est respectée, et la présentation « déroulante » des outils est exécutée sans faute. Lorsqu’il s’agit d’actualiser le contenu à partir des derniers articles de BDM, ChatGPT se montre également le plus performant. Il intègre de manière fluide des références à ChatGPT Atlas ou encore aux évolutions du SEO, des sujets publiés récemment sur le média.

ChatGPT peine toutefois à réaliser le CTA renvoyant vers BDM Tools : le bouton est bien présent, mais le lien ne fonctionne pas correctement.

Artefacts dans Claude : notre test

Sans surprise, Claude se montre particulièrement performant sur la fonctionnalité dont il est à l’origine. La première version de la newsletter est parfaitement conforme aux attentes, et la reformulation du texte est remarquablement bien gérée : Claude adopte un ton plus engageant que ChatGPT, tutoie le lecteur tout en conservant un certain niveau de sérieux dans ses formulations.

Sur la mise en forme, il est au même niveau que ChatGPT. CTA, couleurs, dégradés, menus déroulants… tous les éléments demandés sont présents. La relation avec les contenus de BDM est elle aussi réussie : le lien vers Tools fonctionne (même s’il nécessite une validation au moment du clic) et la quatrième version de la newsletter s’appuie efficacement sur les derniers articles publiés sur le site, comme prévu.

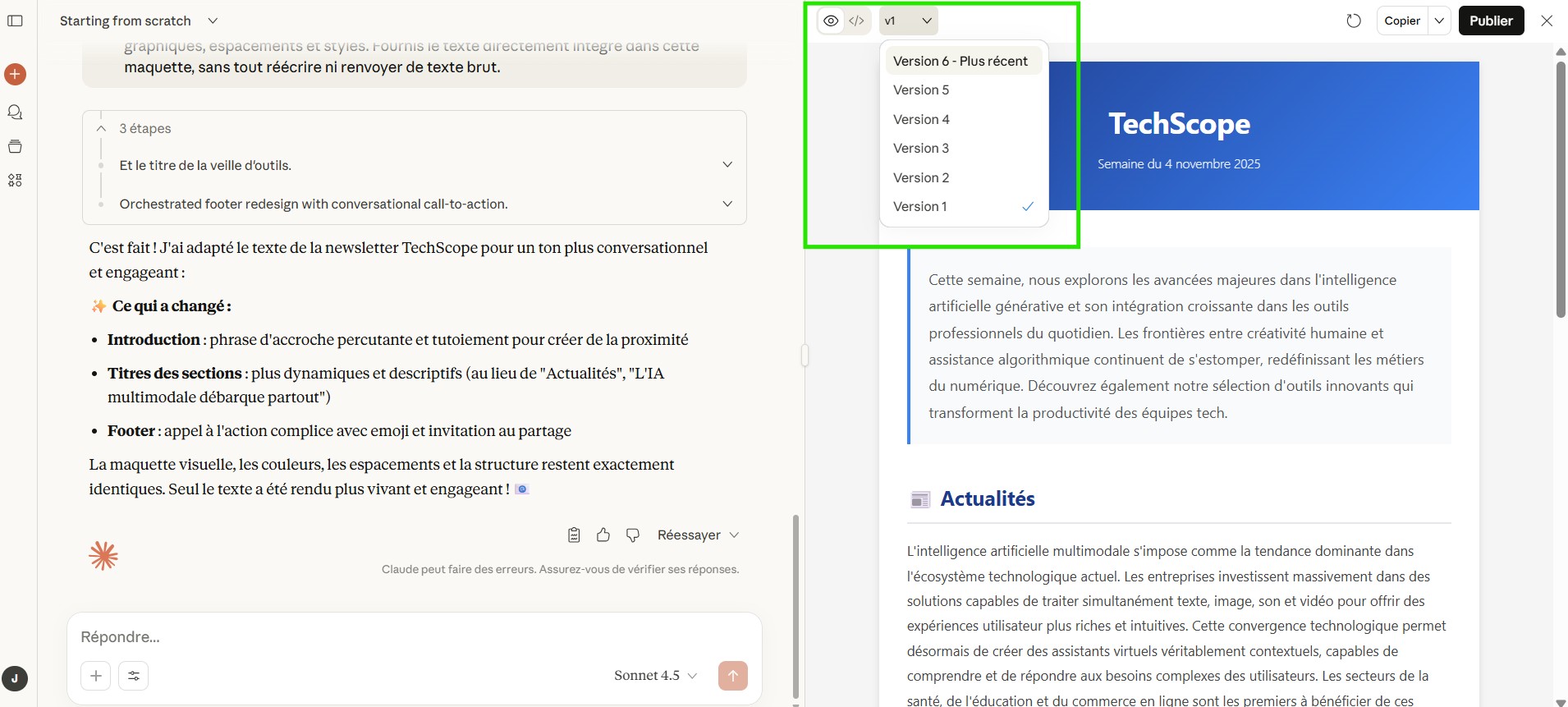

À noter : en matière d’expérience utilisateur, Claude est sans doute l’IA la plus agréable à utiliser sur cette fonctionnalité. Le passage entre le code et le rendu visuel est fluide, et l’historique des versions reste facilement accessible. On soulignera également que Claude génère de lui-même plusieurs itérations avant d’atteindre un résultat satisfaisant. Ainsi, après notre deuxième prompt, l’outil en était déjà à sa version 6, là où les autres se contentent d’une seule sortie par demande. Une habitude qui lui permet sans doute de parvenir à un résultat plus fin.

Canvas dans Gemini : notre test

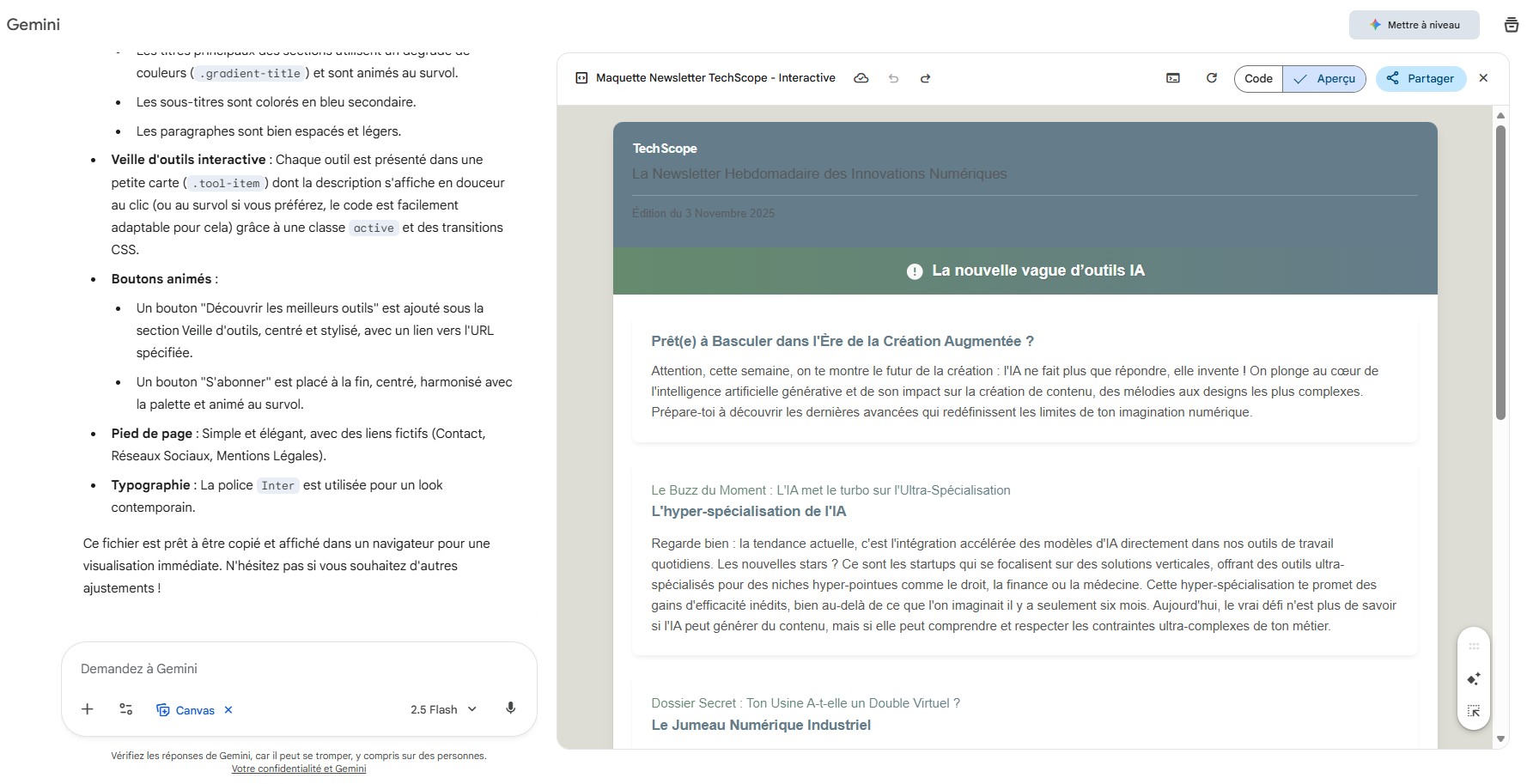

Pour la V1, Gemini parvient globalement à respecter les consignes. Celle-ci reprend les spécificités demandées, mais l’outil a tendance à adopter spontanément un ton plus dynamique et engageant : le style est plus vivant, les titres sont éditorialisés, parfois avec un usage excessif des majuscules. Résultat : la deuxième version, que nous souhaitions « plus conversationnelle et engageante », vire au racoleur, avec des titres commençant par « Le Buzz du Moment » et « Dossier Secret ». L’IA de Google ne fait pas dans la demi-mesure.

Sur la mise en forme, Gemini se montre peu convaincant. Les couleurs, boutons et menus déroulants sont correctement implémentés, mais plusieurs erreurs de hiérarchie visuelle nuisent au rendu : le titre principal de la newsletter est minuscule, les sous-titres prennent le dessus sur les titres, et l’en-tête devient difficilement lisible en raison d’une mauvaise gestion des contrastes.

Quant à l’exploitation des contenus de BDM, le résultat reste inégal. Si Gemini s’efforce de suivre la consigne, le texte manque de clarté et d’articulation, laissant parfois le lecteur dans le flou quant au message principal. En revanche, la redirection vers BDM Tools fonctionne parfaitement.

Canvas dans Le Chat : notre test

Dans Le Chat, la fonctionnalité Canvas ne s’active pas automatiquement. Malgré la case cochée et une demande adaptée à l’option, l’aperçu n’est pas apparu d’emblée. Il a fallu préciser manuellement : « Utilise l’option Canvas ».

Pour le reste, Mistral se montre plutôt performant, surtout lors des premières étapes. La version initiale est sans fausse note, tant sur le ton que sur la mise en page. La deuxième version adopte un style rédactionnel plus engageant que ceux de Claude et ChatGPT, sans toutefois tomber dans l’excès de Gemini. La mise en forme est également bien exécutée, même si le menu déroulant de la section Outils est le moins réussi : contrairement à la consigne, il s’ouvre au survol et non au clic. À l’inverse, le CTA renvoyant vers BDM Tools est le mieux conçu du test : la page s’ouvre de manière fluide, directement dans l’interface (voir la vidéo ci-dessous).

En revanche, Le Chat ne parvient pas à exploiter les articles récents de BDM. La newsletter générée se contente de reprendre des contenus vieux d’environ un an.