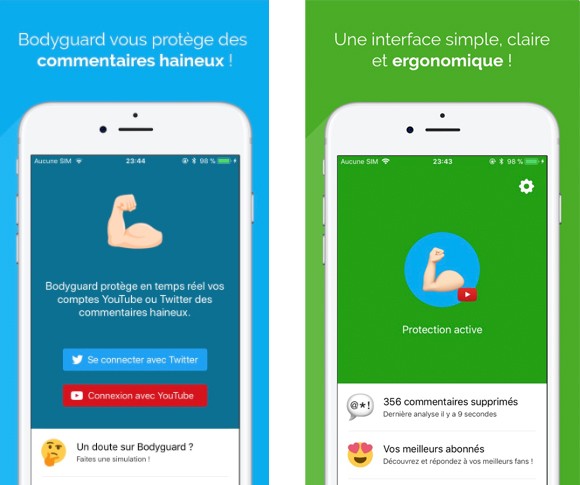

Bodyguard : une application française qui protège des commentaires haineux sur YouTube et Twitter

Présentation de Bodyguard.ai, une solution de lutte contre la haine en ligne.

Depuis la parution de cet article en 2018, l’entreprise Bodyguard.ai, à l’initiative de cette application mobile a beaucoup évolué.

Initialement prévu pour aider les utilisateurs des réseau sociaux, l’outil propose maintenant plusieurs solutions à destination des entreprises, notamment de la modération en temps réel. Il est aujourd’hui possible de protéger ses clients, ses utilisateurs ou followers des contenus toxiques et de mieux engager sa communauté en ligne, grâce à sa technologie d’intelligence artificielle contextuelle et autonome.

En savoir plus sur la solution

Créée par un jeune développeur français de 22 ans, Bodyguard protège ses utilisateurs des commentaires haineux sur YouTube et Twitter. L’application fait de plus en plus parler d’elle et semble avoir trouvé son public, notamment chez les YouTubers qui sont désormais plus d’un millier à l’utiliser au quotidien. Avec 97% d’utilisateurs satisfaits et plus de 17 000 commentaires bloqués, Bodyguard semble être un rempart efficace contre la haine sur internet. Pour en savoir plus sur le service et son fonctionnement, nous avons posé quelques questions à son créateur : Charles Cohen.

Comment a émergé l’idée de créer cette application ?

Je suis né avec la génération YouTube, un site que je fréquente depuis mes 10 ans (âge auquel j’ai commencé le développement). YouTube est un site où le cyber-harcèlement est présent depuis ses débuts et fait de plus en plus de ravages (fermeture de chaîne, etc…). Un jour je suis tombé sur un article qui parlait du suicide d’une jeune fille suite à un cyber-harcèlement très agressif, j’ai fait quelques recherches pour finalement me rendre compte qu’il y avait beaucoup de cas similaires. Ensuite, j’ai commencé à chercher les solutions qui étaient présentes pour lutter efficacement contre ce problème : aucunes. J’ai toujours voulu développer une startup basée sur cette technologie, c’était le moment idéal d’autant plus qu’elle répondait à un vrai besoin. J’ai alors pris le pari et le risque de me lancer dans le développement d’une IA (sans aucune notion d’IA), qui je savais devait avoir un taux d’erreur/faux positif très très faible au risque de perdre immédiatement mes utilisateurs, le bouche à oreille, et de catégoriser Bodyguard comme « censeur ».

Depuis combien de temps travaillez-vous sur ce projet ?

Cela va maintenant faire 1 an que je travaille sur le projet, et l’application a été lancée il y a 6 mois. J’ai fait face à un énorme problème au début : je n’avais aucune data et aucune donnée pour pouvoir apprendre à Bodyguard à détecter les commentaires haineux. J’ai dû faire un travail d’étiquetage pendant les 3 premiers mois : indiquer à Bodyguard manuellement ce qui était haineux, et ce qui n’était pas haineux, en me basant sur des « clashs » Twitter. Le travail d’étiquetage et l’apprentissage humain continue encore à ce jour, mais je dispose maintenant d’une base de données de 500 000 commentaires classifiés.

Techniquement, comment fonctionne-t-elle ?

Bodyguard est gérée par une intelligence artificielle : elle reproduit une action qui nécessite normalement un cerveau humain (cf : la modération.). Nous analysons le contexte de la phrase et nous nous adaptons à l’utilisateur que nous protégeons. Pour résumer rapidement :

Dans un premier temps nous recherchons dans la phrase une suite de mots haineux, ou une insulte (parmi une combinaison de plusieurs dizaines de millions de mots), peu importe l’orthographe, les emojis, le langage SMS, le langage LEET, peu importe si l’utilisateur essaie de censurer l’insulte, ou de contourner Bodyguard.

Dans un second temps nous allons analyser le contexte, à savoir ce qu’il y a avant et après ces mots, et en fonction de ça nous prenons une première décision : haineux ou pas haineux.

Exemple :

- n’écoute pas connards qui disent que t’es une pute -> détecté comme non haineux par Bodyguard.

- t’es une p uuuuuuuuuuuuu t e -> haineux.

- j’suis grave un connard parfois -> non haineux.

- t’es vraiment une groooooossssssssseeeeeeeeeeeeeeeeee ****** -> haineux.

- t mère c tlmnt 1 p*te -> haineux.

Ce sont des exemples basiques, mais la technologie fonctionne bien entendu avec tout type de violences : menaces, harcèlement sexuel, moral, troll, moqueries, haine, homophobie, insultes, racisme…

Exemple :

- T’es moche -> moquerie -> haineux.

- Ne fais pas attention à ceux qui disent que t’es moche -> non haineux.

- T vidéo c dla merde, non je rigole -> non haineux.

- T’es pas belle -> haineux.

- T’es belle -> non haineux.

- N’ecoute pas ceux qui disent que t’es belle -> moquerie -> haineux.

- T’es vraiment magnifique, non je rigole. -> moquerie -> haineux.

- Tu meriterai qu’on te viole. -> harcèlement sexuel -> haineux.

- Ta mère mérite des claques -> menace -> haineux.

- Ta un gros 👃 -> moquerie

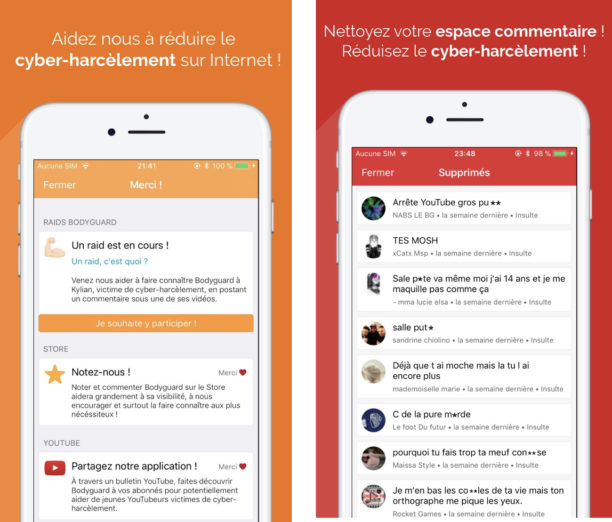

Dans un troisième temps, nous nous adaptons au profil de l’utilisateur : si l’utilisateur est homosexuel nous serons intransigeants avec l’homophobie, si l’utilisateur est un homme qui se maquille nous allons être bien plus sévères avec certaines remarques, si l’utilisateur a une différence physique (obésité, handicap), nous serons intransigeants sur les moqueries, etc… Nous nous adaptons également à l’âge : si l’utilisateur est très jeune, nous allons le protéger bien plus efficacement, et pour finir nous détectons les raids. Lors d’un raid de commentaires haineux, Bodyguard sera encore une fois bien plus sévère avec la modération pour protéger nos utilisateurs intégralement. Cette troisième étape nous permet pour certains utilisateurs par exemple, d’accepter l’humour :

Exemple :

- Mdr t’es un enculé 😂 -> non haineux selon l’utilisateur.

- Montre nous tes fesses 😂 -> supprimé si l’utilisateur est une fille, conservé si l’utilisateur est un homme majeur.

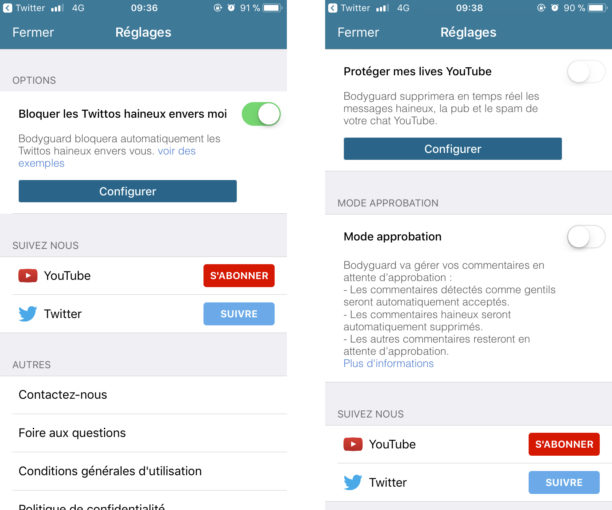

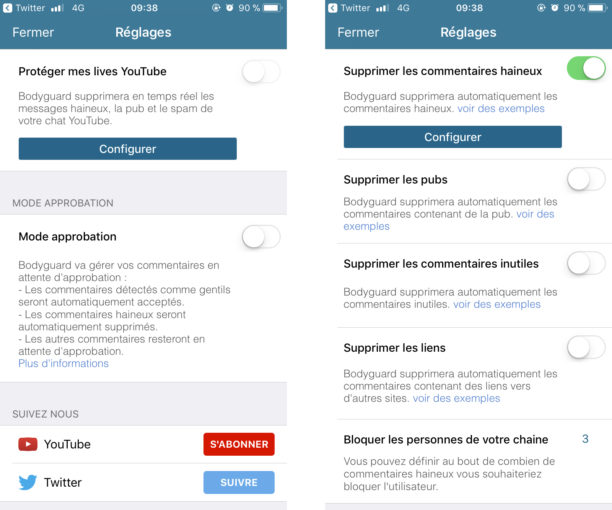

Bodyguard protège également contre les remarques envers vos proches, et toutes ces étapes sont réalisées en 5 millisecondes en moyenne. Ce qui nous permet de protéger également le Chat des lives YouTube avec la même technologie. L’utilisateur a bien entendu la possibilité de restaurer un commentaire (ou débloquer un Twittos) qui a été supprimé. Mais généralement, si Bodyguard a fait une erreur nous le restaurons nous même, puis nous apprenons à l’IA à ne plus faire cette erreur. Ainsi, l’utilisateur n’a rien à faire : on s’occupe de tout !

Forcément, il arrive également que Bodyguard passe au travers de certains commentaires, ce n’est pas un problème car nous disposons également d’outils nous permettant de vérifier manuellement certains commentaires « à risques » que nous supprimons manuellement si ils s’avèrent être haineux. Nous apprenons encore une fois à Bodyguard à détecter ce genre de commentaires afin de ne pas les laisser passer. C’est grâce à ces dispositifs que nous pouvons certifier à nos utilisateurs que nous les protégeons des commentaires haineux à 100%.

Pourquoi pensez-vous pouvoir faire mieux que les plateformes elles-mêmes et leur système de modération ?

Tout d’abord il n’y a aucune plateforme qui propose un système de modération intelligent en Français. YouTube, Instagram et Twitch ont lancé un service similaire en Anglais (depuis 1 an), toujours en Beta, donc avant de le voir arriver en Français il peut se passer des années. La seule chose que propose YouTube actuellement c’est de placer des mots clés dans une « blacklist », et dès qu’un commentaire contient un de ces mots, il est placé en attente de vérification. Malheureusement c’est une solution très binaire qui peut faire office de censure dans certains cas.

Exemple :

- Si l’utilisateur a classé le mot « gay », « je suis gay et j’assume totalement » sera placé en attente de vérification. Ce système est facilement contournable car « t’es vraiment gaaaaay » lui, ne sera pas placé en vérification.

De plus, ce système est très limité, car il faudrait rentrer chaque combinaison et certains commentaires haineux le sont sans même contenir le moindre mot injurieux (Exemple : « tu fais vraiment trop ta belle, redescend sur terre »). Ainsi, sans vouloir me jeter des fleurs, je peux certainement affirmer faire mieux que les plateformes actuelles car elles ne proposent pas de protection en français. Je peux d’ailleurs le voir dans mes statistiques, je supprime de plus en plus de commentaires au jour le jour, avec déjà plus de 17 000 commentaires supprimés pour « seulement » 900 YouTubeurs (dont certains à forte notoriété).

Pour l’instant l’application est entièrement gratuite, avez-vous prévu des plans payants pour la suite ?

Je pense laisser l’application entièrement gratuite pour la protection des utilisateurs. Je n’ai pas encore vraiment réfléchi à cette question car je me concentre sur le développement et l’accompagnement de l’IA de Bodyguard. Mais pourquoi pas mettre en place un système de licence afin de proposer la technologie à certaines entreprises.

Est-ce que l’on pourra bientôt l’utiliser pour se protéger sur les autres réseaux comme Facebook, Snapchat ou Instagram ?

Snapchat ne propose malheureusement pas d’API (hors marketing) pour que je puisse protéger ses utilisateurs, c’est vraiment dommage car il y a également beaucoup de cyber-harcèlement sur cette plateforme. La technologie devrait arriver sur Facebook et Instagram lors des prochains mois !

Pensez-vous développer le service à l’international avec le support de nouvelles langues ?

J’ai pour projet de créer une entreprise autour de Bodyguard dans les prochains mois, en m’associant avec les bonnes personnes pour espérer lever des fonds. J’ai pour objectif de traduire Bodyguard en plusieurs langues (d’abord l’anglais), pour devenir un acteur majeur contre le cyber-harcèlement en proposant enfin une solution concrète.

Pour finir, je tiens simplement à rajouter que je supprime uniquement les commentaires qui sont pénalement répréhensibles. Je ne touche pas à la liberté d’expression et je pense même l’aider, car beaucoup de personnes ont peur de se lancer sur ces plateformes par peur d’être moqueés et/ou insultées. Pour résumer, j’offre un modérateur gratuit à n’importe qui, géré à 95% par une IA et qui fonctionne 24h/7j !

Vous êtes tenté(e) par Bodyguard, téléchargez l’application sur Google Play ou l’App Store ! A noter que vous pouvez tester la technologie, et même analyser une chaîne YouTube ou un compte Twitter ici. Les plus sceptiques peuvent également avoir accès à une démonstration, le tout via le site internet.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis