Analyse d’image : BDM a comparé ChatGPT, Gemini, Claude, Perplexity, Copilot, DeepSeek et Le Chat

BDM a testé la fonction d’analyse d’image des principaux outils d’IA. Quels sont ceux qui montrent les meilleures performances ? Tour d’horizon !

Il y a encore deux ans, les outils d’IA générative mettaient en avant certains facteurs différenciants pour se démarquer. Aujourd’hui, leurs fonctionnalités tendent à s’uniformiser. Mais offrent-elles réellement le même niveau de performance ? Pour y répondre, BDM a comparé les fonctionnalités des principaux outils disponibles sur le marché.

L’analyse d’image fut l’une des premières capacités multimodales intégrées aux IA généralistes grand public, comme ChatGPT, Gemini et consorts. Elle permet d’uploader une image, un visuel ou une photo, et de demander au modèle une description précise, analyse approfondie, un conseil pratique…

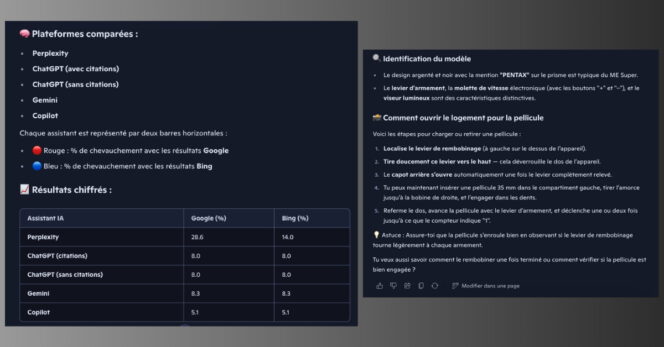

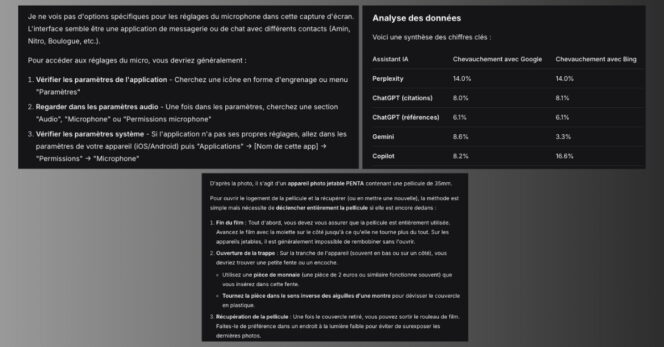

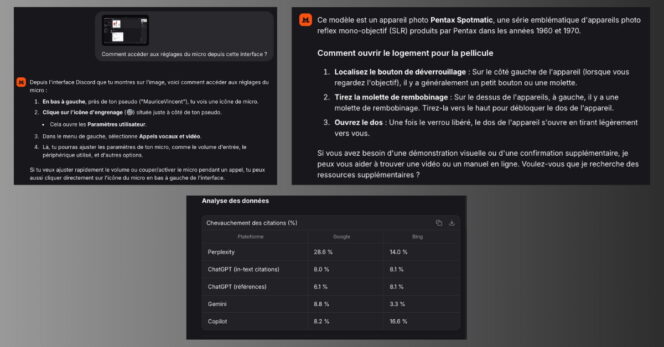

Pour ce test, BDM a proposé trois images, chacune accompagnée d’un prompt, aux différents modèles d’IA comparés :

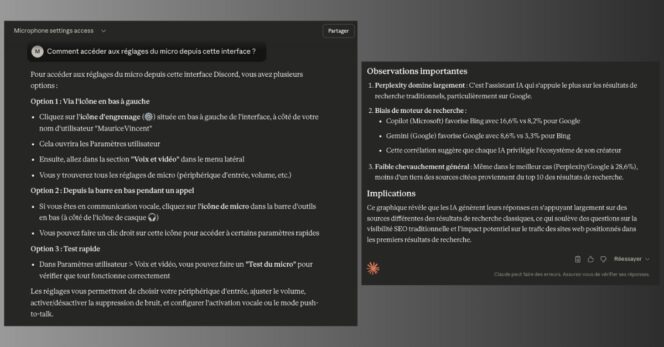

- Une capture d’écran de l’interface de Discord avec le prompt suivant : « Comment accéder aux réglages du micro depuis cette interface ? »

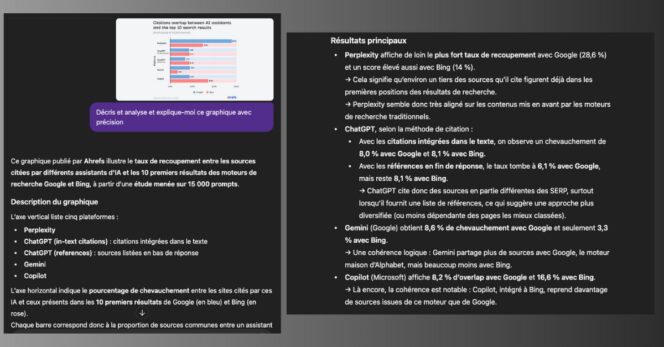

- Un graphique issu d’une étude de Ahrefs avec le prompt suivant : « Décris, analyse et explique-moi ce graphique avec précision. »

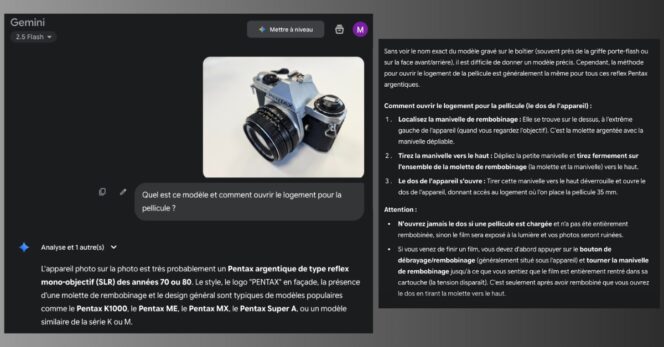

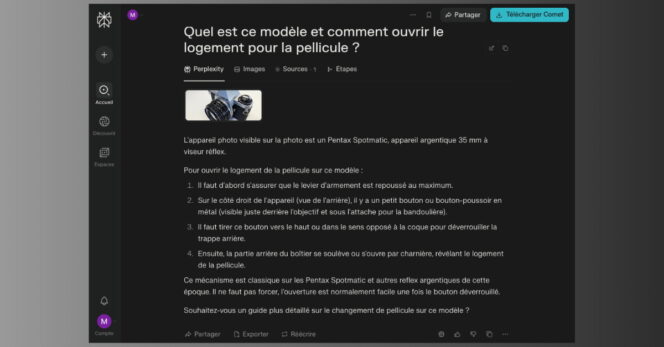

- Une photo d’un Pentax ME Super avec le prompt suivant : « Quel est ce modèle et comment ouvrir le logement de la pellicule ? »

Seront jugées : la précision de l’analyse de l’image, à travers la justesse et la profondeur de la description ou de l’interprétation produite ; la pertinence de la réponse, au regard de la capacité de l’IA à répondre à une consigne spécifique ; la clarté ou la richesse de la réponse formulée par rapport à l’image et la requête données.

L’analyse d’image dans ChatGPT : notre test

Quelle que ce soit la demande effectuée (aide sur l’interface, analyse de graphique ou conseil sur l’appareil photo), ChatGPT (ici GPT-5) a généré sa réponse très rapidement. L’outil d’OpenAI attache également un soin particulier à répondre au prompt : il décrit efficacement le graphique, donne un accès aux paramètres micro sur l’interface Discord, renseigne sur le modèle de l’appareil photo et explique comme ouvrir le boîtier pellicule.

Côté interprétation, peu d’erreurs sont à remarquer. ChatGPT comprend très bien qu’il s’agit de l’interface de l’application Mac de Discord et donne le bon accès aux réglages micro, avec les bons noms de menus et sous-menus. Il ne se trompe pas sur les chiffres du graphique d’Ahrefs et en fait une analyse pertinente. Le chatbot explique également parfaitement comment ouvrir le logement pellicule, même s’il se trompe de modèle d’appareil.

Enfin, du point de vue de la formulation de la réponse, ChatGPT va à l’essentiel. Il privilégie les listes à puces et une structure en sous-titres, est concis sans rester en surface, le tout accompagné de propos et conseils clairs.

L’analyse d’image dans Gemini : notre test

Gemini, ici dans sa version 2.5 Flash, opère un petit temps de réflexion avant de générer ses réponses, mais celui-ci n’excède pas quelques secondes. Le modèle de Google comprend bien le contexte qui lui est présenté, qu’il s’agisse de l’interface Discord, du graphique ou de la photo du Pentax. Il répond sans détour aux requêtes associées, mais ne le fait pas de la même façon à chaque fois.

Par exemple, pour Discord, il est un peu moins précis que ChatGPT dans la marche à suivre, mais suffisamment pour comprendre et réussir la manœuvre. Même chose pour le mode d’emploi de l’appareil photo. Et s’il ne remarque pas, ou du moins ne précise pas, qu’il s’agit de l’interface de Discord macOS, il est moins catégorique sur le modèle de l’appareil photo que ChatGPT par exemple, et cite le bon modèle parmi une liste d’hypothèses.

La véritable différence se fait sur l’analyse du graphique, particulièrement claire et approfondie, sans aller au-delà de la requête, avec une structuration de la réponse pertinente et efficace. En outre, Gemini place, à bon escient, quelques conseils de précaution à la fin de sa réponse sur l’appareil photo, l’enrichissant intelligemment.

L’analyse d’image dans Claude : notre test

Quand il analyse des images, Claude, avec son modèle Sonnet 4.5, ne fait pas de fioritures et va droit au but. Peut-être un peu trop. En effet, la précision de son analyse reste de qualité, malgré quelques erreurs ou imprécisions, mais l’outil d’Anthropic a tendance à rester un peu en surface. Sur l’interface Discord, aucun problème d’analyse n’est véritablement à déclarer. Pour l’appareil photo, Claude se trompe de modèle et, plus embêtant, le fait avec une confiance inébranlable, même si l’erreur est minime.

Il comprend aussi bien le graphique d’Ahrefs, est capable de le décrire de façon claire et structurée, mais fait état d’un flagrant manque d’analyse. On regrettera notamment un manque de contextualisation et d’explication, se limitant au constat. En revanche, il donne le bon chemin sur Discord, et propose même une autre solution intéressante, tout comme il explique assez bien comment ouvrir le boîtier pellicule de l’appareil photo. Un peu trop concis, Claude mériterait d’enrichir un peu ses réponses et d’être moins sûr de lui.

L’analyse d’image dans Perplexity : notre test

Ce n’est pas vers Perplexity qu’on se tournerait naturellement pour analyser une image. Conçu comme un moteur de recherche par IA, l’outil peut néanmoins réaliser les mêmes tâches que ces concurrents. Aussi bien ? Cela dépend des cas. Lors de nos tests, Perplexity a montré ses capacités à bien suivre nos consignes, en répondant à nos demandes spécifiques. Il n’a aucun problème à détecter l’interface Discord et donner le bon chemin. Il comprend et décrit avec les bonnes données le graphique d’Ahrefs, avec une structure qui répond parfaitement au prompt : description, analyse, explication.

Les réponses sont concises mais assez précises. On peut cependant regretter que l’analyse du graphique soit un peu orientée, avec une certaine mise en avant de… Perplexity. Enfin, du côté de l’analyse et du conseil pour l’appareil photo, l’outil a tout faux : il se trompe de modèle mais également dans son mode d’emploi pour ouvrir le compartiment pellicule.

L’analyse d’image dans Copilot : notre test

Les outils d’IA proposés par Microsoft sont souvent critiqués, pourtant, cette expérience d’analyse d’images a réellement été une relativement bonne surprise. Copilot a parfaitement détecté l’interface Discord, compris le graphique d’Ahrefs et est le seul modèle testé à donner la bonne référence de l’appareil photo. Côté pertinence des réponses, pas grand-chose à signaler pour l’aspect procédure/mode d’emploi. On trouvera sans problème les réglages micro sur Discord ou la manipulation pour ouvrir le boîtier pellicule.

Mais, il y a un mais. Un gros mais. Dans son analyse du graphique d’Ahrefs, bien qu’il propose une mise en forme et structuration de sa réponse extrêmement claires, Copilot fait une erreur fatale : il se trompe dans le relevé des données chiffrées. Sa réponse en devient alors totalement faussée et la confiance de l’utilisateur se fissure. Dommage, car Copilot avait été très bon sur les deux autres tests, mais cette erreur est sans doute l’une des pires possibles… L’analyse de graphiques ou tableaux de données semble donc à éviter.

L’analyse d’image dans DeepSeek : notre test

DeepSeek ne sait pas analyser une image. Dans sa formule grand public de base, l’IA chinoise prévient l’utilisateur lors de l’upload d’un fichier : « Extract only text from images and files » (Extraire seulement le texte des images et fichiers). Dès lors, compliqué d’analyser une interface ou une photo. DeepSeek ne reconnaît par exemple pas Discord, et est même incapable de le déterminer malgré certains modules propres à l’application (Nitro, etc.). Mais sait-il seulement lire ? A priori, non. L’appareil photo dont le nom apparaît en énorme sur la photo est un « PENTA » selon DeepSeek, qui se trompe également dans les chiffres de l’étude Ahrefs.

Ses conseils s’en retrouvent forcément mauvais. Il se contente de vagues propositions pour accéder aux paramètres de Discord qu’il ne reconnaît pas, fait une mauvaise analyse du graphique à cause de données erronées, et donne de très mauvaises indications pour l’ouverture du logement pellicule de ce qu’il présente comme « un appareil photo jetable »… À oublier.

L’analyse d’image dans Le Chat : notre test

Le Chat, du leader français Mistral, fait la plupart du temps dans la concision. Il n’a aucun problème à comprendre la requête de l’utilisateur ou à repérer de quel genre de visuel il s’agit. Ainsi, il a repéré l’interface Discord, compris le graphique d’Ahrefs et saisi que nous parlions d’un appareil photo argentique Pentax. Cependant, quand on se penche un peu plus sur ses réponses, on note quelques erreurs ou imprécisions.

Par exemple, il ne mentionne pas le bon nom des sous-menus des paramètres de Discord. Si son explication permet de s’en sortir assez facilement, elle manque cependant de précision. Même chose au sujet de l’appareil photo : Le Chat affirme sans détour qu’il s’agit là d’un Pentax Spotmatic, alors qu’il s’agit du modèle ME Super. Pire encore, il fait une erreur de lecture sur un des chiffres présents dans le graphique de Ahrefs.

Ainsi, si de prime abord, Le Chat semble faire le boulot, en répondant certes succinctement mais relativement correctement aux demandes, ces petites erreurs et son manque d’analyse poussée rendent la fonctionnalité assez peu compétitive par rapport aux poids lourds du marché.

Pour Gemini vous utilisez Flash qui est la version « mini » de Google. L’équivalent à GPT5 aurait été d’utiliser « Gemini-pro » (le modèle équivalent). Idem pour Perplexity, dont la version « pro » est bien meilleure.

Il faut comparer ce qui est comparable….

Le test serait utile si tu avais testé :

– haiku vs flash vs gpt4o mini

– opus4.1 vs gpt5 vs gemini 2.5pro

– sonnet vs gpt4

La c’est comme comparer une clio et une Ferrari…