A2UI : Google permet aux agents IA de composer des interfaces utilisateur

Avec A2UI, Google propose un protocole open source pour que les agents IA créent des interfaces utilisateur dynamiques et sécurisées, adaptées au contexte.

Google vient d’annoncer le lancement public d’A2UI (Agent to UI), un projet open source conçu pour permettre aux agents d’intelligence artificielle de générer des interfaces utilisateur riches et interactives. Publié le 15 décembre 2025 en version 0.8, ce protocole vise à standardiser la façon dont les agents communiquent avec les applications pour créer des interfaces graphiques adaptées au contexte conversationnel.

Le problème : les limites des interfaces textuelles

Jusqu’à présent, les interactions avec les agents IA reposaient principalement sur des échanges textuels. Google illustre cette limite avec un exemple concret : la réservation d’une table au restaurant via un chatbot nécessite plusieurs allers-retours fastidieux (date, heure, nombre de personnes, disponibilités…).

Avec A2UI, l’agent doit pouvoir générer directement un formulaire graphique comportant un sélecteur de date, une liste déroulante pour l’heure et un bouton de validation. L’utilisateur ou l’utilisatrice remplit le formulaire au lieu de taper des messages, rendant l’expérience plus fluide et intuitive.

Comment fonctionne A2UI

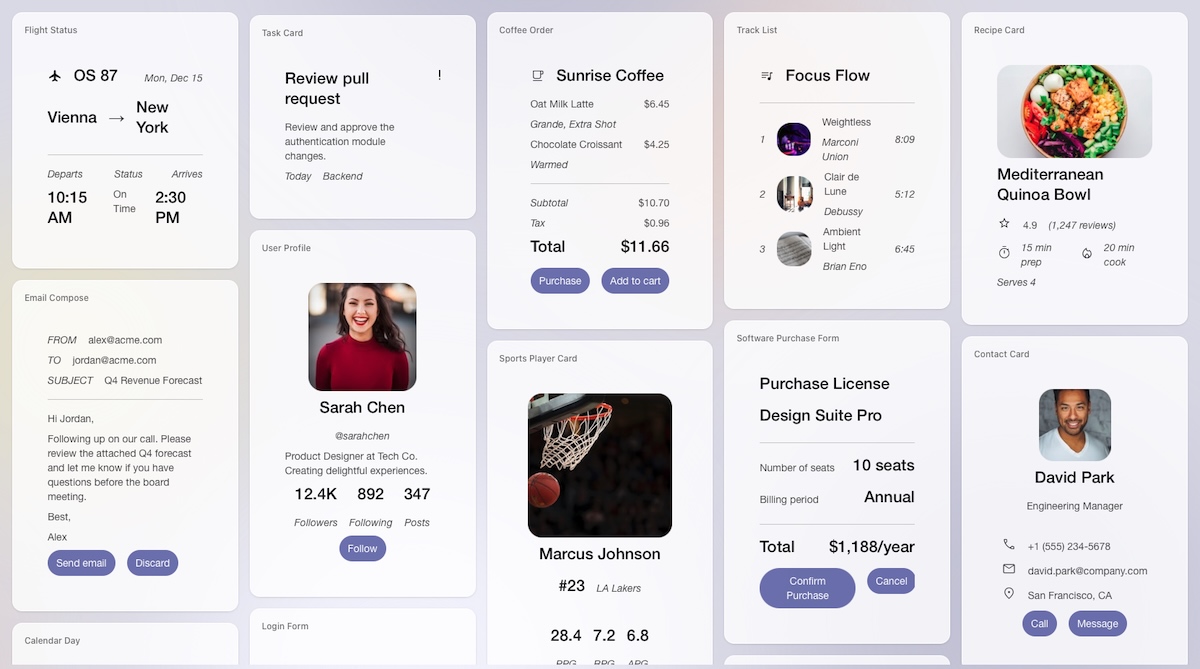

A2UI repose sur un format JSON déclaratif que les agents envoient aux applications clientes. Contrairement aux approches traditionnelles qui transmettaient du HTML ou du JavaScript via des iframes, A2UI ne transmet pas de code exécutable, mais une description structurée de l’interface.

L’application cliente maintient un « catalogue » de composants UI pré-approuvés (boutons, champs de texte, cartes, graphiques…). Lorsqu’un agent génère une réponse avec A2UI, il ne peut demander que le rendu de composants issus de ce catalogue de confiance. Le client conserve ainsi le contrôle total sur le style, la sécurité et l’accessibilité.

Le format a été conçu pour être facilement générable par les modèles de langage. Au lieu de devoir créer l’interface complète d’un seul coup, l’agent peut la construire progressivement, composant par composant, et la modifier au fur et à mesure que la conversation avance avec l’utilisateur ou l’utilisatrice.

Un format universel qui s’adapte à toutes les plateformes

A2UI a été conçu pour fonctionner partout. Concrètement, un agent peut générer une seule fois la description d’une interface et celle-ci s’affichera correctement sur n’importe quelle plateforme (site web, application mobile iOS ou Android, logiciel desktop).

Cette universalité répond à un enjeu majeur. Dans les systèmes multi-agents, les agents ne sont pas toujours hébergés au même endroit. Un agent peut tourner sur un serveur distant, appartenir à une autre organisation ou collaborer avec d’autres agents pour accomplir une tâche complexe.

Le problème est que ces agents distants ne peuvent pas modifier directement l’interface de votre application. Ils doivent envoyer des instructions. A2UI leur fournit un langage commun pour décrire l’interface souhaitée, que l’application cliente se charge ensuite d’afficher avec ses propres composants graphiques. Ainsi, l’interface générée par l’agent ressemble naturellement à votre application, sans rupture visuelle.

Un outil complémentaire aux solutions existantes

Google ne présente pas A2UI comme un remplaçant des outils actuels, mais comme une brique supplémentaire dans l’écosystème des agents IA. Le protocole se concentre sur un problème précis : permettre à différents agents de générer des interfaces qui fonctionnent sur toutes les plateformes.

Concrètement, A2UI peut servir à créer des formulaires de réservation adaptés au contexte, générer des tableaux de bord personnalisés en fonction des données demandées ou composer des interfaces d’approbation de workflows en entreprise. L’agent adapte l’interface en temps réel selon les besoins de l’utilisateur ou de l’utilisatrice, sans qu’un développeur ait besoin de coder chaque variation possible.

« Dans cet exemple, l’utilisateur télécharge une photo, et un agent distant utilise Gemini pour l’analyser et créer un formulaire sur mesure adapté aux besoins spécifiques du client en aménagement paysager », explique Google :

A2UI se distingue également du Model Context Protocol (MCP), qui affiche les interfaces dans des fenêtres isolées (iframes). Avec A2UI, l’interface s’intègre directement dans l’application, conservant son apparence et ses fonctionnalités d’accessibilité natives. L’utilisateur ou l’utilisatrice ne voit, logiquement, aucune différence entre les éléments générés par l’agent et ceux de l’application elle-même.

Comment tester A2UI

Le projet est disponible sur GitHub sous licence Apache 2.0. Les développeurs et développeuses peuvent consulter la documentation sur a2ui.org et tester les exemples fournis, notamment l’agent de recherche de restaurants. Des bibliothèques clientes sont déjà disponibles pour Flutter, Web Components et Angular, avec d’autres frameworks prévus via les contributions de la communauté.

Google invite les développeurs et développeuses à participer à l’évolution du protocole et à partager leurs retours sur cette version 0.8 encore en développement actif.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis