Les 10 modèles d’IA les plus performants en décembre 2024

Google semble désormais concurrencer OpenAI, en plaçant deux de ses modèles sur le podium de la Chatbot Arena.

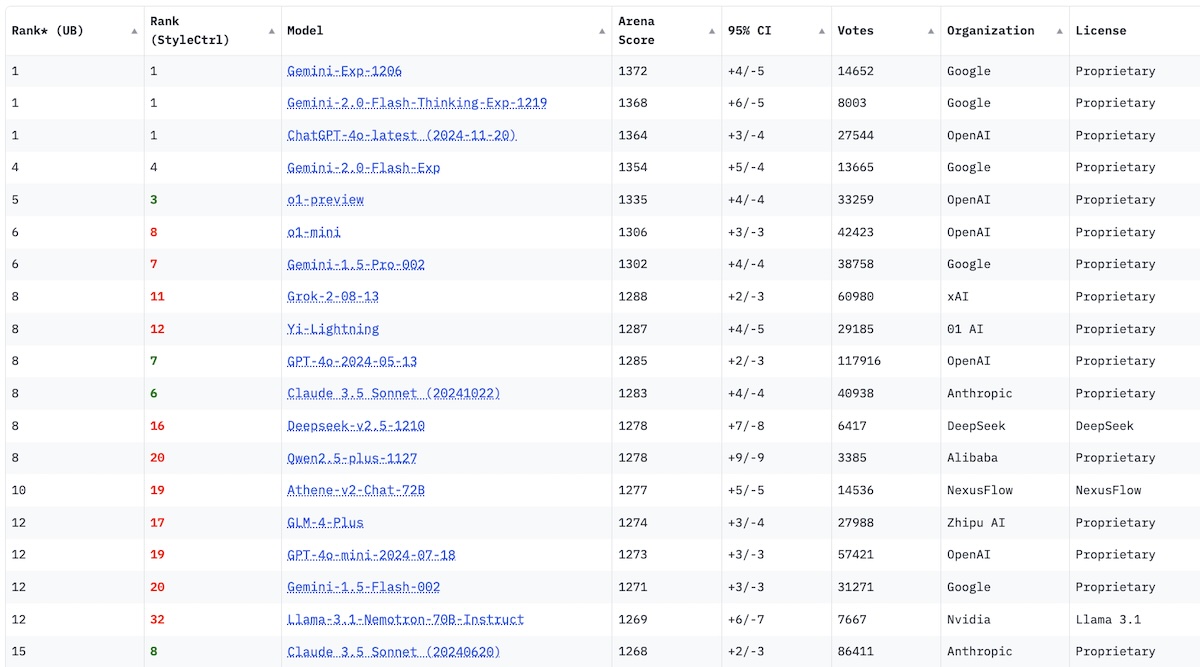

Dans la dernière mise à jour de la Chatbot Arena, un classement évaluant objectivement les modèles de langage disponibles sur le marché, Google se distingue enfin. En décembre 2024, la firme de Mountain View place deux de ses modèles sur le podium, et relègue OpenAI en troisième position.

Les 10 modèles de langage les plus performants en décembre 2024

Google et OpenAI se disputent âprement les premières positions de la Chatbot Arena. Ce mois-ci, huit des dix modèles les plus performants ont été conçus par l’une de ces deux entreprises. Google prend néanmoins un léger ascendant, en s’adjugeant les deux premières positions du classement grâce à la sortie de Gemini 2.0 Flash.

Claude, habitué à jouer les trouble-fêtes, glisse hors de la première partie de tableau, ce mois-ci, et se retrouve à la 11e place. De son côté, Yi Lightning, le modèle d’origine chinoise développé par 01.ai, se maintient dans le top 10 pour le 3e mois consécutif en s’adjugeant la 9e place, tandis que Grok, l’IA conçue par xAI, l’entreprise d’Elon Musk, recule d’une place par rapport au mois de novembre et se classe 8e.

Enfin, l’entreprise française Mistral, qui avait quitté le top 20 le mois dernier, n’est pas parvenue à remonter au classement et occupe la 25e place avec son modèle Mistral Large-24-11.

Voici le classement des modèles génératifs les plus performants en décembre 2024 :

- Gemini-Exp-1206 : 1372 (score Elo)

- Gemini 2.0 : 1368

- ChatGPT 4o Latest : 1364

- Gemini 2.0 Flash : 1354

- o1-preview : 1335

- o1-mini : 1306

- Gemini 1.5 Pro : 1302

- Grok-2-08-13 : 1288

- Yi-Lightning : 1287

- GPT 4o : 1285

Découvrir le classement complet

Les critères de classement de la Chatbot Arena

La Chatbot Arena est un classement conçu par la Large Model Systems Organization (LMSYS). Elle évalue de manière objective – et en temps réel – les performances des modèles d’intelligence artificielle en s’appuyant sur les retours des utilisateurs. Afin de classer les modèles de la manière la plus neutre possible, elle propose des duels entre deux modèles anonymisés, arbitrés par des humains. Les participants doivent choisir, selon eux, l’IA ayant le mieux répondu à la requête initiale. Ce processus permet de classer les différents modèles grâce à un score Elo.

Le système Elo, utilisé dans des domaines comme les échecs ou l’esport, fonctionne comme une côte évolutive : lorsqu’un modèle gagne contre un adversaire avec un score Elo plus élevé, il accumule des points, tandis qu’il en perd lorsqu’il subit une défaite contre un adversaire supposément plus faible.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis