Vidéo par IA : avec Gen-4, Runway permet de créer des courts-métrages convaincants

Le nouveau modèle de Runway met l’accent sur sa capacité à représenter fidèlement des personnages, lieux et objets sous plusieurs angles.

La création visuelle générée par IA semble en passe de franchir une nouvelle étape. Depuis quelques semaines, de nombreux acteurs de l’écosystème IA mettent les bouchées doubles sur ce plan. À commencer par ChatGPT, jusqu’ici en retard sur la génération d’images, qui a frappé un grand coup avec la sortie de 4o Image Generation, directement intégré à ChatGPT. Dans le même temps, les concurrents se bousculent, à l’instar de Reve, qui a lancé Image 1.0 (déjà numéro 1 de la Text-to-Image Arena), ou de Midjourney, dont la sortie de la V7 est imminente.

Si les générateurs d’images offrent des résultats de plus en plus bluffants, avec une meilleure compréhension des requêtes et une capacité améliorée de retranscription du texte, les outils de génération de vidéo, comme Sora, disposent encore d’une marge de progression. Ce lundi 31 mars 2025, Runway, l’un des acteurs majeurs de la vidéo par IA, a dévoilé son nouveau modèle intitulé Gen-4, dont les exemples se révèlent très prometteurs.

Runway publie Gen-4, un nouveau modèle de génération de vidéo

Dans le communiqué publié sur son site, Runway affirme que Gen-4 peut « générer avec précision des personnages, des lieux et des objets cohérents d’une scène à l’autre« . Le modèle est ainsi conçu pour pouvoir recréer une même scène sous différents angles, tout en respectant l’univers défini par l’utilisateur. Pour illustrer ces avancées, Runway publie plusieurs exemples montrant une continuité visuelle d’un plan à l’autre.

Runway Gen-4 vous permet de générer des personnages cohérents dans une infinité de conditions d’éclairage, de lieux et de traitements. Le tout avec une seule image de référence de vos personnages […] Placez n’importe quel objet ou sujet à n’importe quel endroit ou dans n’importe quelle condition, est-il indiqué dans le blog post.

Dans l’exemple présenté ci-dessous, le personnage est représenté fidèlement sous plusieurs angles, au sein d’un seul et même décor.

Le modèle semble toutefois encore perfectible. Il présente parfois un léger effet de grésillement, et les plans dévoilés restent relativement courts, ce qui suggère qu’il pourrait avoir des difficultés à maintenir la cohérence sur la durée. En revanche, les exemples proposés par Runway montrent des améliorations par rapport à ceux d’OpenAI avec Sora : le sentiment de flottement est moins marqué, et les incohérences se font plus rares.

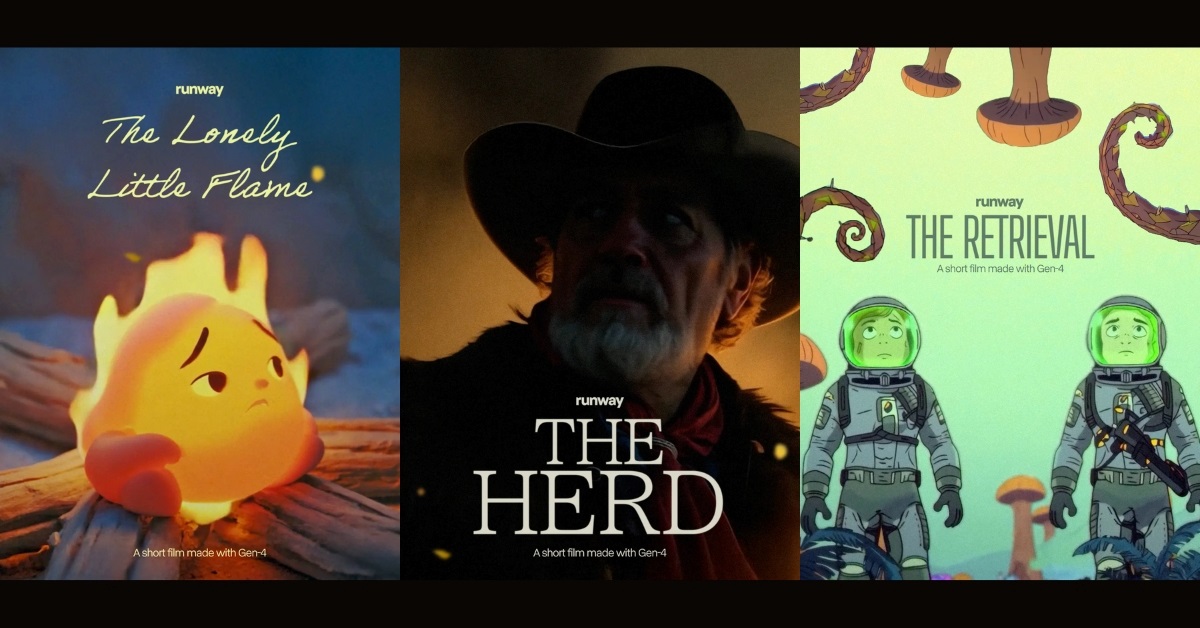

Des courts métrages réalisés grâce à Gen-4

Les nouvelles capacités du modèle s’adressent directement aux professionnels de la création vidéo. La possibilité de générer des lieux, des personnages et des objets cohérents sous plusieurs angles ouvre en effet la voie à la réalisation de courts métrages entièrement produits par IA. Une orientation assumée par Runway, qui a publié une série de films courts convaincants, conçus intégralement avec Gen-4.

Ci-dessous, un court-métrage animé.

Ci-dessous, un court métrage réaliste. On constate que la voix — vraisemblablement ajoutée en post-production — est synchronisée avec le mouvement des lèvres du personnage.

Runway : comment accéder à Gen-4

Un plan payant est nécessaire pour utiliser le modèle Gen-4. Pour un usage individuel, Runway propose trois formules :

- À 15 $ : jusqu’à 5 utilisateurs par espace de travail, 625 crédits par mois.

- À 35 $ : jusqu’à 10 utilisateurs, 2 250 crédits par mois.

- À 95 $ : nombre d’utilisateurs et de crédits illimités.

Le plan gratuit ne donne accès, pour le moment, qu’à Gen-3 Alpha Turbo.

La boîte à questions sur l'IA générative

Outils, prompts, usages professionnels, comparatifs... Posez toutes vos questions à Ludovic Salenne, expert IA !

Je pose une question