Meta dévoile LLaMA 3.2 : un modèle de langage multimodal qui enrichit Meta AI

Lors du Meta Connect, l’entreprise californienne a présenté LLaMA 3.2, un modèle de langage multimodal qui décuple les capacités de Meta AI. Mais ces innovations ne seront, pour l’instant, pas déployées sur le territoire européen.

Ce mercredi 25 septembre 2024, lors du Meta Connect, sa conférence annuelle, Meta a présenté ses nouveaux produits, comme le Meta Quest 3S ou les lunettes Meta Orion, ainsi que ses dernières avancées dans le domaine de l’intelligence artificielle. L’entreprise californienne a notamment dévoilé LLaMA 3.2, la dernière itération de son grand modèle de langage (LLM), désormais multimodal, ainsi que plusieurs nouvelles fonctionnalités pour son agent conversationnel Meta AI, qui reste à ce jour indisponible en Europe. On vous résume les annonces.

Meta dévoile LLaMA 3.2, son modèle de langage multimodal

Le groupe dirigé par Mark Zuckerberg comble, en partie, son retard sur Google et OpenAI, ses principaux concurrents dans le domaine de l’intelligence artificielle. Lors du Meta Connect, la firme a dévoilé LLaMA 3.2 : son premier modèle de langage multimodal, capable de traiter et d’interpréter une variété d’informations, comme des images, du texte ou du contenu audio et vidéo. LLaMA 3.2, qui alimente Meta AI (voir plus bas) se décline en deux moutures : l’une entraînée sur 90 millions de paramètres et l’autre, plus compacte, entraînée sur 11 millions de paramètres.

Nous continuons à améliorer l’intelligence, en particulier le raisonnement, ce qui fait de ces modèles les plus avancés que nous ayons publiés à ce jour, a rappelé Meta.

Selon l’entreprise, qui a longuement présenté les facultés de ses modèles dans un article de blog, et réalisé son propre benchmark, ses modèles seraient en mesure de rivaliser avec Claude 3 Haiku ou GPT-4o mini en matière de « reconnaissance d’images » et de « reconnaissance visuelle ».

En parallèle, Meta a également conçu « de très petits modèles » axés sur le texte, entraînés sur 1 et 3 millions de paramètres, qui sont « optimisés pour fonctionner sur des appareils tels qu’un smartphone ou, à terme, une paire de lunettes ».

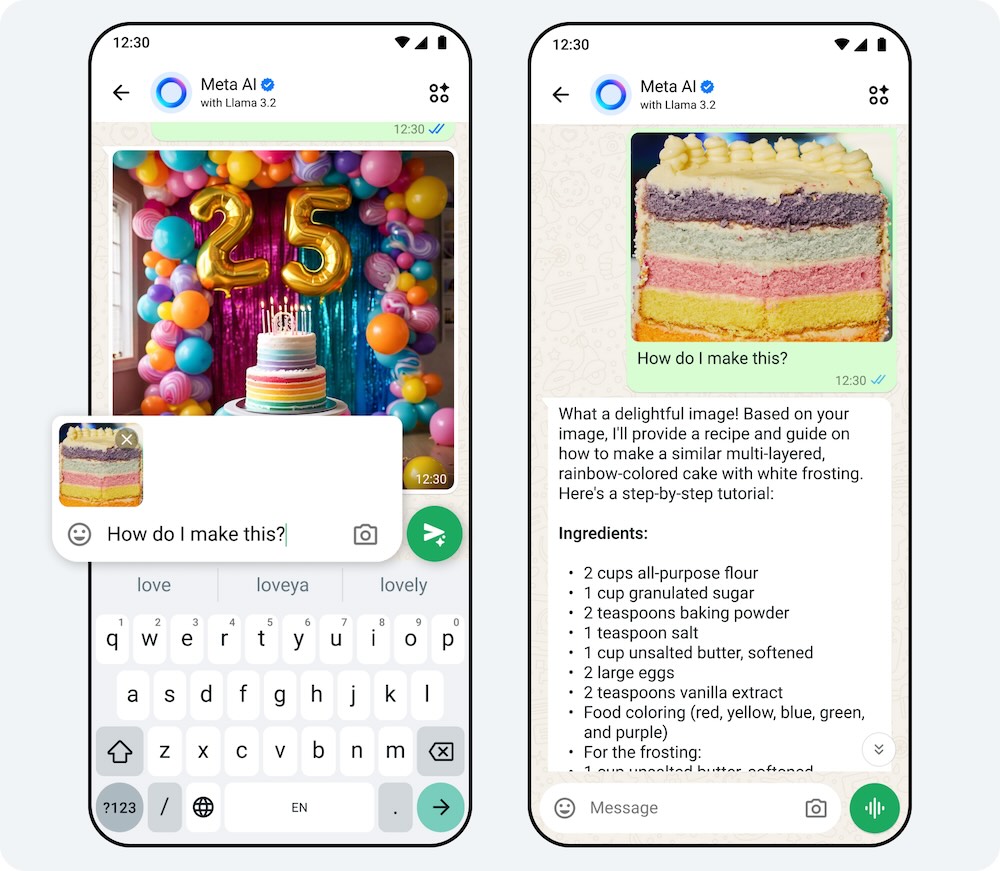

Comme ChatGPT, Meta AI se dote d’une fonction vocale et peut analyser des images

Avec le déploiement de LLaMA 3.2, « les produits IA de Meta deviennent plus utiles et intelligents », annonce la firme dans un blog post. Utilisé mensuellement par « près de 500 millions d’utilisateurs à travers le monde » alors qu’il « n’a pas été déployé dans certains grands pays », s’est félicité Mark Zuckerberg lors de sa prise de parole, Meta AI, l’agent conversationnel intégré à WhatsApp, Facebook, Messenger ou Instagram, se dote de nouvelles facultés :

- Fonction vocale : les utilisateurs peuvent désormais formuler une requête à l’oral, et Meta AI sera en mesure de leur répondre. L’agent conversationnel pourra utiliser la voix de plusieurs célébrités, comme Judi Dench, Kristen Bell ou John Cena.

- Doublage vidéo : Meta AI proposera bientôt outil de traduction automatique, capable de traduire l’audio des Reels sur Facebook et Instagram en anglais et en espagnol. « Grâce au doublage automatique et à la synchronisation labiale, Meta AI simulera la voix de l’interlocuteur dans une autre langue et synchronisera ses lèvres », a précisé l’entreprise. La fonctionnalité est actuellement testée par un groupe de créateurs sur Instagram.

- Analyse d’images : à l’instar de ChatGPT, doté de cette capacité depuis près d’un an, Meta AI est dorénavant capable de comprendre et d’analyser des images soumises par l’utilisateur. L’agent conversationnel peut, par exemple, identifier une fleur à partir d’une photo ou expliquer comment préparer un plat à partir d’une image.

- Édition d’images : le robot conversationnel peut apporter une modification à une image uploadée par l’utilisateur. Il est notamment capable de remplacer l’arrière-plan ou modifier et supprimer des éléments indésirables.

Concernant le déploiement, la situation semble bloquée. Meta AI, tout comme LLaMA 3.2 resteront indisponibles dans les pays de l’Union européenne jusqu’à nouvel ordre, en raison de divergences profondes avec les régulateurs en matière de collecte des données. Dans une lettre ouverte, une cinquantaine de personnalités de la tech, dont Mark Zuckerberg et Daniel Ek, PDG de Spotify, ont appelé les régulateurs européens à prendre des « décisions harmonisées, cohérentes, rapides et claires dans le cadre des règlements de l’UE sur les données, qui permettent d’utiliser les données européennes dans la formation à l’IA au profit des Européens », afin que « l’Europe ne manque pas l’ère de l’IA ».

Pour afficher ce contenu issu des réseaux sociaux, vous devez accepter les cookies et traceurs publicitaires.

Ces cookies et traceurs permettent à nos partenaires de vous proposer des publicités et des contenus personnalisés en fonction de votre navigation, de votre profil et de vos centres d’intérêt.Plus d’infos.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis