Interview : comment fonctionne l’équipe Datalabs d’Arkéa

Zoom sur le service en charge de la Data chez Arkéa, avec cette interview de David Courté, data engineer.

Depuis 2010, le big data s’inscrit comme un pilier de la transformation des entreprises . Cette tendance résulte, entre autres, de l’essor du cloud computing et des technologies qui rendent l’accès au traitement des données plus accessible en vendant de la puissance de calcul aux entreprises. La maturité des acteurs du numérique n’est pas la même à ce sujet : quand certains n’en sont qu’aux balbutiements de leur utilisation de la Data, d’autres ont déjà constitué des stratégies à long terme en structurant des équipes dédiées. C’est le cas d’Arkéa, qui a monté une équipe Datalabs composée d’une vingtaine d’experts.

Nous avons rencontré David Courté, data engineer, qui nous explique le fonctionnement du Datalabs et la manière dont il travaille avec les autres services au sein d’Arkéa.

Dans quelle équipe travaillez-vous à Arkéa ?

Je travaille à la Direction des Études (DE) – au sein du Pôle Innovation & Opérations – qui a pour mission de piloter et de suivre le schéma directeur informatique. Elle met en oeuvre de nombreux projets et assure la maintenance corrective et évolutive des différentes applications du groupe Arkéa .

On retrouve au sein de la Direction des Études plusieurs départements qui sont liés à des

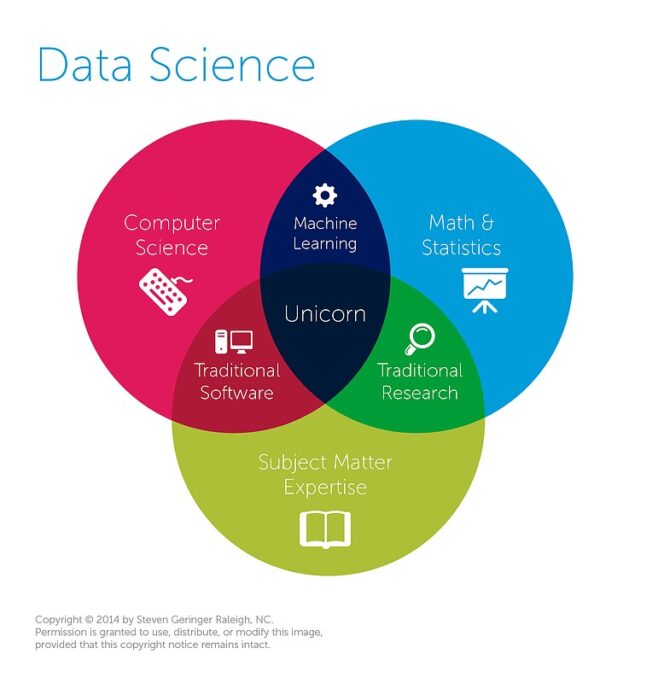

domaines fonctionnels. Je travaille au sein du département Données et Supports, qui a en charge la mise en place d’entrepôts de données décisionnelles, l’exploitation des solutions de reporting et de datavisualisation, la gestion des référentiels … Au Datalabs, nous travaillons principalement sur l’exploitation des technologies du Big Data et des algorithmes d’Intelligence Artificielle. Deux types de profils collaborent. Certains, comme moi, viennent du monde de l’informatique : développeurs, chefs de projet, architectes… D’autres sont experts des mathématiques appliquées, de la recherche, des statistiques et du machine learning* (*ensemble d’algorithmes auto-apprenants, sous jacents à l’Intelligence Artificielle) : data scientists, statisticiens…

Comment faites-vous cohabiter ces deux types de profils, orientés développement et mathématiques, au sein de l’équipe ? Quelle en est la plus-value ?

Avant toute chose, il est important de rappeler que le succès d’un projet Data repose sur un triptyque de compétences en informatique, statistique et business. Nous avons pris le parti de ne pas cloisonner data engineers et data scientists qui travaillent tout au long des projets en étroite collaboration avec les experts métier (Risques, Marketing, Finance…).

Lors de l’étude, le Data Scientist va analyser la problématique à résoudre et réfléchir aux

données dont il a besoin pour faire son étude. En général, cela commence par la production de statistiques descriptives permettant d’avoir une vision globale et précise du sujet et de s’imprégner de la problématique métier. Sur cette base, le data engineer va récupérer les données nécessaires et effectuer les transformations pour que le data scientist puisse démarrer sa modélisation.

Sur le sujet de Data Science, les volumétries engagées sont souvent très importantes c’est pourquoi à ce stade il s’agit en général de données échantillonnées. Cette partie de

récupération et de transformation des données s’appelle le “feature engineering” et représente une partie non négligeable du temps consacré à un projet de Data Science. C’est également à ce stade que nous nous rapprochons, avec le métier porteur du projet, du DPO (Data Protection Officer) pour traiter des problématiques CNIL et RGDP.

Il est indispensable que le Data Engineer étudie l’industrialisation du code dès le démarrage du projet. En effet, les contraintes en termes de performances, de volumétrie, de suivi et de stabilité en production sont plus complexes qu’en phase d’étude. Une étroite collaboration entre le métier, le Data Scientist et le Data Engineer est indispensable pour mener à bien un projet de Data Science.

Le fait de proposer un point d’entrée unique sur les problématiques de data rend les choses plus faciles en interne. Si demain une filiale a des besoins spécifiques, elle sait qu’en nous contactant, elle aura à la fois des compétences pour extraire la donnée et la transformer, mais aussi des personnes qui vont pouvoir la modéliser. Nous proposons de plus des collaborations à la carte, quand les autres filiales ont déjà un data scientist ou un data engineer. Si cela n’entre pas dans notre périmètre de compétences, nous pouvons orienter les demandes vers d’autres services du Département.

Avec quels autres services êtes-vous amené à travailler en interne ? Sur quels sujets ?

Notre service a un positionnement très transverse, et nous pouvons ainsi travailler avec toutes les directions et filiales du groupe. Nous proposons un accompagnement autour de deux grands types de projets, à savoir l’exploitation des technologies du Big Data et la Data Science, et ce aussi bien pour du conseil, de l’idéation, des POC, de la conception et du développement. Depuis la création du service, sur la partie Data Engineering, nous avons pu accompagner des filiales comme Max dans la mise en place de sa plateforme Data ou Suravenir pour l’optimisation des calculs actuariels. En ce qui concerne l’IA et la Data science nous avons travaillé sur la problématique de la prévention du surendettement, sur l’accidentologie informatique ou sur l’octroi de crédits.

A quels défis liés à la data est confrontée une entreprise d’envergure du domaine bancaire comme Arkéa ?

Nous avons des problématiques particulières car nous avons accès à un volume de données très conséquent. Cela peut donner de nouvelles perspectives à des problématiques gérées jusque là de manière classique. Nous avons par exemple travaillé sur la problématique de la prévention du surendettement. Elle était faite jusque-là avec des règles assez empiriques, sur la base de cas très concrets. Nous avons pris le problème à l’envers, en partant de dépôts de dossier de surendettement à la Banque de France. Nous avons analysé les données à notre disposition pour détecter de manière automatique les comportements à risque plus de six mois avant le dépôt de ces dossiers. Nous avons également un rôle à jouer dans l’acculturation et la transformation du groupe sur ces sujet, notamment via le lancement d’un “Programme Data” permettant de présenter aux collaborateurs du groupe les métiers et projets autour de la Data. Dans ce contexte et en complément de ces actions, nous allons recruter de manière croissante au cours des 3 prochaines années des experts de la DATA.

Data Analyst - Lutte Contre la Fraude Externe H/F

pour Crédit Mutuel ARKEA - Le Relecq-Kerhuon - 29

Chef de Produit Crédit - Marché des Particuliers H/F

pour Crédit Mutuel ARKEA - Le Relecq-Kerhuon - 29

-

pour Crédit Mutuel ARKEA - Brest - 29

Lead Développeur - Authentification H/F

pour Crédit Mutuel ARKEA - Brest - 29

CDD Analyste Risque de Contreparties de Marché H/F

pour Crédit Mutuel ARKEA - Finistère - 29

Quelles sont les spécificités de votre travail au quotidien ?

L’une de nos spécificités est de travailler directement avec les métiers, comme les équipes opérationnelles qui gèrent le surendettement ou la conformité si l’on reprend l’exemple cité plus haut . Cela nous permet d’avoir une vision assez complète des métiers du groupe, en n’étant pas accroché uniquement au rôle de développeur ou de chef de projet. Cette vision nous permet d’avoir un regard intéressant et différent sur ce qui est fait et donc de mener nos projets plus efficacement.

Avec quels outils et quel environnement technologique travaillez-vous ?

Le Data engineer chez Arkéa travaille presque essentiellement autour de l’écosystème

Hadoop. Il s’agit d’un environnement Big Data dans lequel sont déversées les données

provenant du SI. La phase d’exploration et d’extraction des données est réalisée

principalement en utilisant le langage PIG. Ce dernier est un langage de haut niveau

permettant d’interagir avec Hadoop avec une syntaxe assez proche du SQL. Les

fonctionnalités de ce dernier étant assez réduites, le langage Java, couramment utilisé dans les applications web du groupe, est utilisé afin de développer des fonctions plus complexes, comme le lancement de modèles de Machine Learning ou des calculs statistiques. Nous pouvons également être amené à travailler avec d’autres langages comme Python ou Javascript, notamment dans les phases de POC où de pré-étude.

Quels avantages principaux trouvez-vous dans votre travail chez Arkéa ?

Historiquement, Arkéa faisait partie des pionniers du Big Data en France en mettant en place un cluster Hadoop en 2009. Cette plateforme permet de stocker des données provenant de sources hétérogènes dans le SI, aussi bien des bases Open que des données Mainframe. Cela nous permet d’avoir des développeurs et architectes expérimentés, et un regard beaucoup plus expert et critique sur les technologies qui rendent le Big Data plus accessible, comme les solutions Cloud. Nous utilisons actuellement un cluster interne avec 200 machines, qui nous offre des garanties en termes de sécurité notamment. Nous sommes donc à la pointe sur nos sujets, ce qui permet un vrai accomplissement professionnel. De manière plus générale, nous avons une vraie liberté technique pour mener à bien nos projets comme nous le souhaitons.

Retrouvez toutes les offres d’emploi d’Arkéa.

Cet article a été réalisé en partenariat avec Arkéa

La boîte à questions sur l'IA générative

Outils, prompts, usages professionnels, comparatifs... Posez toutes vos questions à Ludovic Salenne, expert IA !

Je pose une question