L’histoire de Dust, pépite française de l’IA, racontée par son fondateur

Stanislas Polu retrace le parcours de Dust, la startup qu’il a cofondée et qui s’est imposée comme l’une des pépites françaises de l’IA, grâce à ses assistants intelligents conçus pour les entreprises.

Permettre aux collaborateurs de créer des assistants intelligents, connectés aux infrastructures de l’entreprise, pour « accélérer leur travail » : voici, en substance, l’objectif que s’est fixé Dust. Fondée en février 2023 par Stanislas Polu et Gabriel Hubert, deux alumni de Stanford s’étant déjà associés au début des années 2010, cette startup s’est rapidement imposée comme l’une des pépites françaises de l’intelligence artificielle. En décembre 2024, elle atteint le cap des 2 millions d’euros de revenus récurrents annuels (ARR).

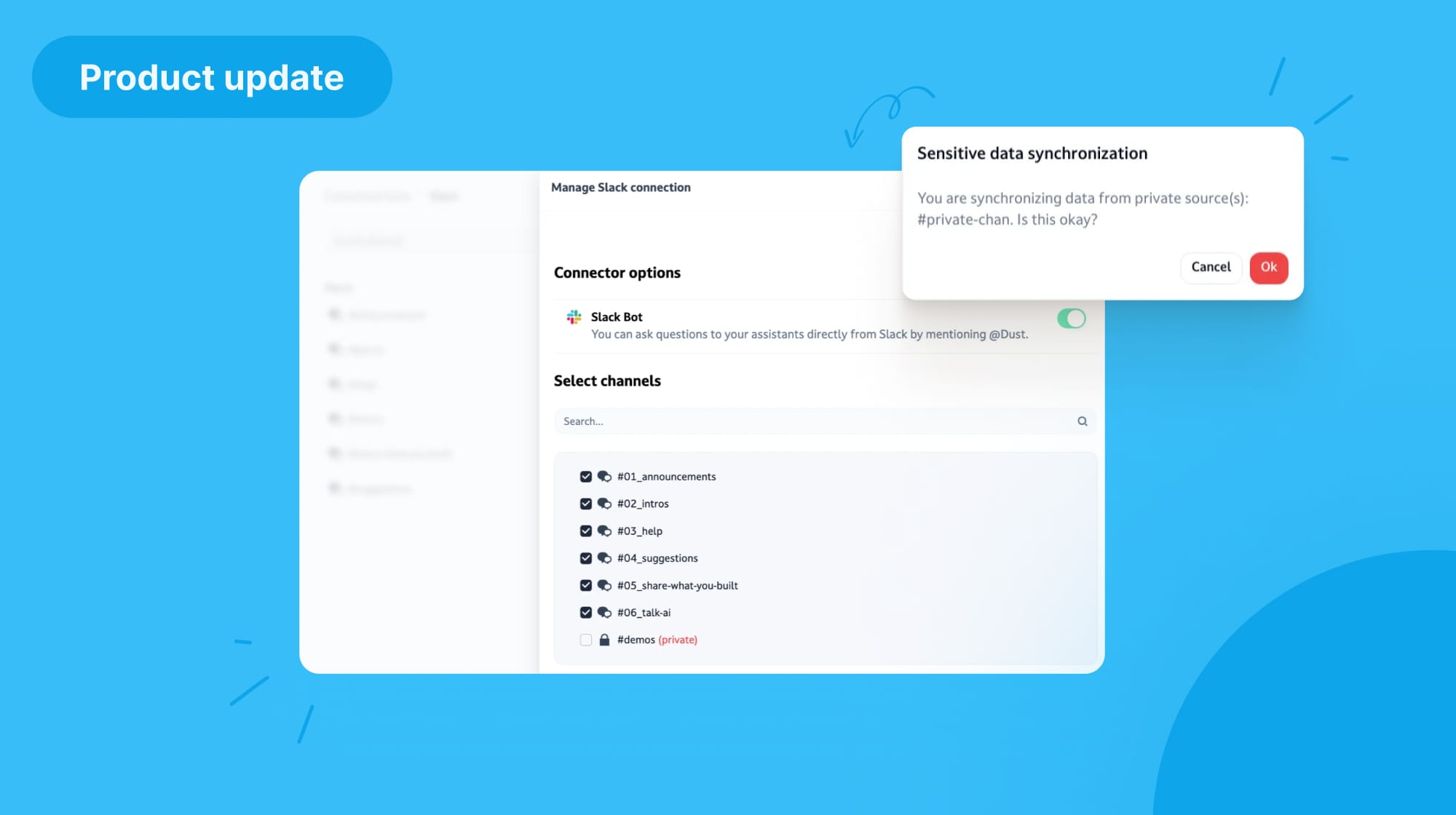

Un succès qui repose sur une conviction, mûrie au fil des expériences de ses deux fondateurs : pour tirer parti « des capacités impressionnantes » de l’IA, il faut exploiter les données internes des entreprises, en créant des passerelles entre les outils utilisés quotidiennement, de Slack à Notion en passant par GitHub. Le tout, en offrant un accès privilégié aux modèles les plus performants, qu’ils soient développés par OpenAI, Mistral ou Google. Un positionnement qui a permis à Dust de lever des fonds et de séduire des clients prestigieux comme Qonto, Paylib ou Malt. Mais également d’aspirer à doubler ses effectifs, dans un futur proche.

En amont de l’événement zero to one, dédié aux startups et qui se tiendra à Nantes du 29 au 30 janvier 2024, BDM a rencontré Stanislas Polu. L’entrepreneur, passé par Stripe ou l’équipe de recherche d’OpenAI – où il a définitivement réalisé le potentiel de l’IA générative « en voyant GPT-2 écrire un paragraphe cohérent » – revient sur la genèse, le positionnement et la vision de Dust.

Stanislas Polu, cofondateur de Dust

Diplômé de Polytechnique et de Stanford, Stanislas a débuté sa carrière chez Oracle, avant de lancer la startup TOTEMS. En 2015, il cède l’entreprise à Stripe, qu’il rejoint en tant que software engineer, avant d’intégrer l’équipe de recherche d’OpenAI. Après avoir passé trois années à étudier le raisonnement mathématique des modèles de langage, il cofonde Dust en 2023.

Pouvez-vous me retracer votre parcours et la genèse de Dust ?

J’ai étudié à Polytechnique, puis à Stanford. J’ai ensuite travaillé chez Oracle pendant une année. Puis je suis retourné en France pour cofonder une entreprise avec mon associé actuel, Gabriel Hubert. On a pivoté plusieurs fois, fait beaucoup d’erreurs – comme souvent en sortie d’école – puis nous avons fini par identifier une niche intéressante : les analytics sur Instagram, alors que la plateforme n’avait pas encore pleinement émergé. À l’époque, notre revenu annuel récurrent (ARR) oscillait entre 1 et 2 millions d’euros. C’était excitant, mais la croissance était assez plate.

Après cinq ans sur ce projet, nous avons trouvé une belle opportunité de sortie en cédant l’entreprise à Stripe, qui est basée à San Francisco. J’y suis resté pendant 5 ans, en tant qu’ingénieur, et j’ai vu l’entreprise passer de 180 à 3 ou 4 000 personnes, c’était intéressant d’assister à un scale aussi rapide. C’est là-bas que j’ai rencontré Greg Brockman, qui était le CTO de Stripe et qui a cofondé OpenAI. C’est à travers lui que j’ai rencontré Ilya Sutskever, puis trouvé mon chemin chez OpenAI, où j’ai passé trois années à travailler sur les capacités de raisonnement mathématique des modèles de langage, quand OpenAI était encore principalement un laboratoire de recherche, avant ChatGPT.

Après ces trois années, j’avais envie de revenir vers l’expérience produit, et c’est comme ça que j’ai relancé un projet avec Gabriel, mon ancien associé, en janvier 2023, avec l’objectif de s’attaquer à la productivité en entreprise. C’est ainsi qu’est né Dust, qui a levé des fonds auprès, notamment, de Sequoia Capital. On est passé de zéro revenu annuel récurrent, en septembre 2023, à 1 million en juin 2024 et 2 millions en décembre 2024. C’est une croissance réjouissante, mais ce n’est que le début.

Au sein de Dust, vous mettez l’IA au service du produit, pour résoudre des problématiques spécifiques. Pourquoi avoir fait ce choix ?

La réponse est assez simple : lorsque j’ai quitté OpenAI, où j’avais pu expérimenter GPT-4, il était clair pour moi que les modèles avaient atteint des capacités impressionnantes, mais qu’ils étaient encore sous-déployés. À partir de ce constat-là, on a voulu se focaliser sur le produit. Pour que ces modèles soient réellement utiles, ils ont besoin d’avoir accès à l’infrastructure de l’entreprise – pour obtenir des données, du contexte – et de disposer d’une interface intuitive pour les utilisateurs. Ces deux dimensions relèvent entièrement du produit.

La technologie qui alimente ces modèles est versatile et s’adapte à une multitude de situations. En réalité, il n’est pas nécessaire de mener des recherches supplémentaires pour la déployer au sein des entreprises : on peut exploiter simplement les modèles tels qu’ils sont servis par les laboratoires ou des entreprises comme Google. Notre travail consiste en une exploration du produit : ce que signifie concrètement l’utilisation de cette technologie dans le domaine du travail. L’interface conversationnelle, c’est la base, mais on peut imaginer des milliards d’autres manières d’interagir avec ces modèles.

Vous avez choisi d’exploiter les principaux modèles disponibles sur le marché plutôt que d’en fournir un seul. Pourquoi ?

La vérité, c’est que bien que ces modèles aient des particularités, ils sont assez interchangeables, d’une certaine manière. Il n’est pas nécessaire de les adapter, puisqu’ils sont performants dans la plupart des tâches. La meilleure façon de les ajuster, c’est de leur fournir des instructions spécifiques, puisqu’ils sont entraînés pour suivre ces instructions.

Ce qui est intéressant, c’est la course constante à l’amélioration des capacités de ces modèles entre les différents fournisseurs, depuis deux ans. Dans un monde où les modèles changent aussi rapidement, pouvoir accéder aux dernières itérations a énormément de valeur. En faisant ce choix, on libère aussi les entreprises d’une dépendance à un fournisseur.

La concurrence entre les fournisseurs pousse l’innovation. Lorsqu’OpenAI lance un modèle comme o1, c’est génial de pouvoir annoncer : « o1 est disponible dans Dust et vous pouvez l’utiliser quelques heures ou quelques jours après sa sortie ». Il en va de même quand Anthropic déploie Sonnet 3.5. Parce que certains utilisateurs suivent ces évolutions et veulent tester les capacités des modèles.

Vous offrez à l’utilisateur la possibilité de concevoir son propre agent, plutôt que de proposer une solution prête à l’emploi. Qu’est-ce qui a motivé ce choix ?

C’est une bénédiction et une malédiction à la fois. Le fait de permettre aux utilisateurs de créer des agents pour s’équiper, c’est le moteur de notre pénétration au sein des entreprises. Dans la plupart des boîtes où nous entrons, on observe un phénomène viral : les utilisateurs testent la technologie, créent un agent efficace, et celui-ci se dissémine au sein de l’équipe puis entre les équipes. C’est cette capacité à modeler le software selon ses besoins qui favorise l’adoption de Dust. Et c’est génial, parce qu’on constate que les utilisateurs créent des agents adaptés à leurs cas d’usage. La malédiction, c’est qu’on est une plateforme assez horizontale. C’est plus difficile à vendre qu’un produit identifiable et verticalisé.

Notre solution est facile à prendre en main. Définir un agent revient essentiellement à lui donner des outils et des instructions. Ça ne nécessite pas de compétences techniques, et ça favorise l’expérimentation. Si l’agent ne fonctionne pas, ce n’est pas grave, s’il fonctionne, tant mieux. Certes, au sein d’une population d’utilisateurs, seulement une partie se consacre à créer, pendant que l’autre partie consomme. Mais parmi les créateurs, cette capacité d’expérimenter librement leur permet de se former, et de développer leur intuition sur le fonctionnement et les possibilités de cette technologie.

Lorsqu’on est un acteur comme Dust, qui propose une solution spécialisée, est-ce que l’on s’inquiète du développement d’offres des grands acteurs à destination des entreprises ?

Nous sommes aussi très généralistes. Mais une entreprise comme Dust bénéficie de l’avantage classique d’une startup : une rapidité d’itération et une capacité d’exploration par rapport à des acteurs tels que Microsoft ou Google. Notamment des niches prometteuses, qui sont amenées à grossir. Ces acteurs, lorsqu’ils déploient un produit, s’adressent à des centaines de millions d’utilisateurs, ce qui impose des contraintes assez fortes sur le produit. Et nous sommes dans un marché qui, de toute manière, bouge très vite. Ça peut faire peur, au départ, mais il faut l’accepter.

Lors d’une conférence au Tech Rocks Summit, une developer advocate chez OpenAI mentionnait que de nombreuses startups commettent l’erreur de créer des solutions temporaires pour combler les lacunes techniques des outils d’IA existants. Partagez-vous cette analyse ?

Sur un marché comme celui de l’IA, où tout évolue très vite, il ne s’agit pas de créer un monticule qui va se faire immerger à la prochaine vague. Il faut concevoir un produit qui s’apparente plutôt à une planche, capable de surfer sur les évolutions des modèles. Quand un nouveau modèle est déployé, c’est un tailwind pour Dust : ça améliore le produit. Ce qui est certain, c’est qu’il ne faut pas trop se focaliser sur une situation donnée, car le paysage évolue constamment. Notre enjeu principal est, surtout, que nos outils soient utiles à l’entreprise. Qu’ils aient une connexion profonde avec l’infrastructure. Un agent efficace, qui accélère les processus pour un développeur, par exemple, a besoin d’accéder à Notion, à Zendesk ou à Salesforce pour non seulement comprendre le design doc, les choix d’infrastructures, mais aussi les feedbacks des équipes support ou commerciales.

Votre expérience chez OpenAI vous a permis de comprendre en profondeur le fonctionnement de ces modèles, leurs points forts et leurs limites. Est-il nécessaire d’avoir ce type d’expérience pour développer une solution ciblée et capable de résoudre les limites des modèles existants ?

Je ne pense pas que ce soit indispensable, parce qu’il est très difficile d’anticiper les futures possibilités des modèles, encore aujourd’hui. D’une certaine manière, c’est rassurant d’avoir cette expérience, parce que ça confère un bagage qui aide à lire entre les lignes, à prendre des raccourcis en se fiant à des convictions qui se sont construites sur plusieurs années. En réalité, ce qui compte, c’est d’expérimenter et d’avancer. Aujourd’hui, la technologie est assez simple à appréhender. D’après moi, toute personne motivée peut s’attaquer à un produit ou à un marché sans nécessairement disposer de ce background. Sauf si elle aspire à créer ou à finetuner un modèle, évidemment.

L’intégration de l’IA dans le monde professionnel divise : les optimistes y voient une émergence de solutions prometteuses, tandis que d’autres y perçoivent un risque. Comment convaincre les sceptiques de rejoindre le camp des optimistes ?

L’adoption de l’IA sera portée par l’usage. Les personnes qui réussiront à exploiter efficacement l’IA seront non seulement plus productives, mais elles auront aussi un impact plus important dans l’entreprise, et trouveront davantage d’intérêt dans leur travail. Je pense que l’IA va plutôt attirer que repousser. On peut comparer cette évolution à l’arrivée des ordinateurs, il y a quelques décennies : certaines personnes étaient réticentes, mais personne ne reviendrait en arrière aujourd’hui. Selon moi, il faut être curieux, et s’approprier la technologie là où elle peut être utile.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis