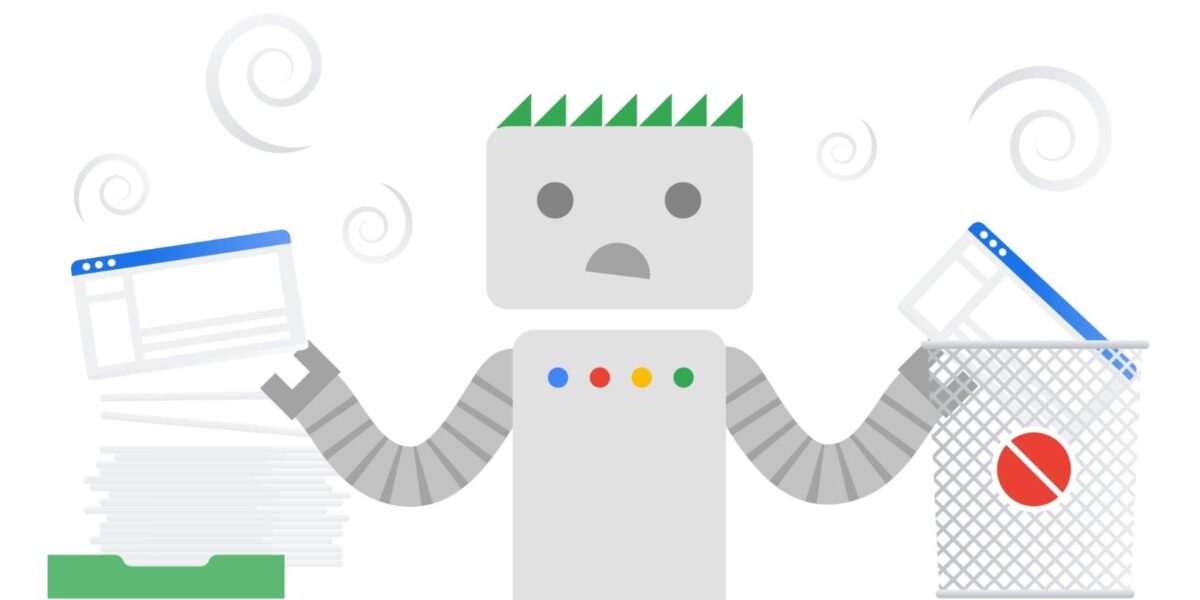

Google va ignorer le noindex dans le robots.txt à partir du 1er septembre 2019

Google va arrêter de prendre en compte le noindex, le nofollow et le crawl-delay dans les fichiers robots.txt.

Le contexte : la standardisation du protocole d’interprétation du robots.txt

Google veut un standard officiel pour le protocole d’interprétation du fichier robots.txt, utilisé par les webmasters pour fixer les règles d’exploration suivies par les crawlers (REP, Robots Exclusion Protocol). Google a également décidé de rendre open source la librairie C++ utilisée pour analyser les fichiers robots.txt.

Google va arrêter d’interpréter certaines déclarations dans le robots.txt

En parallèle, Google annonce la fin de l’interprétation, par ses bots, de plusieurs déclarations utilisées par certains webmasters – notamment crawl-delay, noindex et nofollow. Google précise qu’il a analysé les robots.txt proposés par les sites, et remarque que certaines déclarations ne correspondent pas au standard imaginé par Martijn Koster en 1994. Les règles de crawl-delay, nofollow et noindex n’ont pas non plus été documentées par Google. Peu de webmasters les utilisent donc, mais il y en a – et ils devront changer leurs pratiques d’ici la fin du mois d’août 2019.

Today we're saying goodbye to undocumented and unsupported rules in robots.txt 👋

If you were relying on these rules, learn about your options in our blog post.https://t.co/Go39kmFPLT

— Google Webmasters (@googlewmc) 2 juillet 2019

Pour afficher ce contenu issu des réseaux sociaux, vous devez accepter les cookies et traceurs publicitaires.

Ces cookies et traceurs permettent à nos partenaires de vous proposer des publicités et des contenus personnalisés en fonction de votre navigation, de votre profil et de vos centres d’intérêt.Plus d’infos.

Comment éviter l’indexation de pages web sur Google

En effet, Google n’interprétera plus les règles non-définies dans le Robots Exclusion Protocol à partir du 1er septembre. Cela concerne notamment crawl-delay, nofollow et noindex. Google rappelle que d’autres moyens permettent aux webmasters de déclarer une page ou un répertoire en noindex, pour refuser l’indexation :

- Ajouter le noindex dans les meta tags de la page (meilleure solution)

- Les codes HTTP 404 et 410 signifient que la page n’existe pas, les crawlers de Google le comprennent et suppriment ces pages de son index.

- Les pages placées derrière un paywall – et celles qui nécessitent un mot de passe – sont « en général » supprimées dans l’index de Google.

- Google n’indexe que les pages qu’il connaît, mettre une page ou un répertoire en disallow via le robots.txt reste donc une possibilité. Google pourra toujours indexer une page s’il repère un lien vers cette page, mais précise que ces pages en disallow via le robots.txt seront moins visibles sur Google à l’avenir.

- Vous pouvez également utiliser la Search Console pour supprimer une URL qui n’a rien à faire sur Google.

Évaluez BDM

Simple ou compliqué, ennuyeux ou captivant... nous avons besoin de vous pour améliorer notre site. Quelques minutes suffisent !

Je donne mon avis