Facebook publie les chiffres de sa modération de contenu au premier trimestre 2019

Toujours dans sa dynamique de transparence à l’égard de sa modération de contenu, Facebook dévoile son troisième rapport concernant l’application de ses règles d’utilisation et de Standards de la communauté.

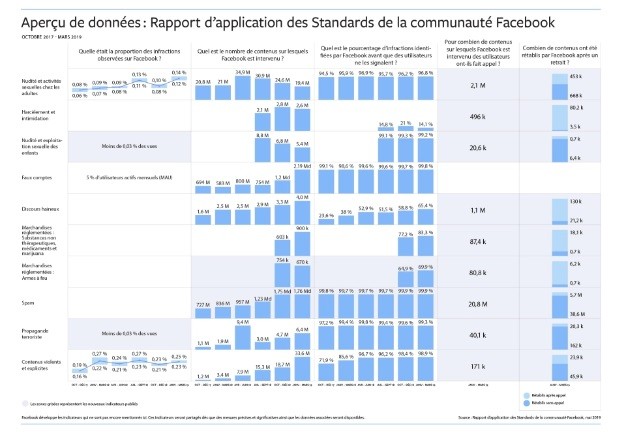

La volonté de Facebook est de mettre en avant l’évolution de ses applications destinées à réglementer les contenus abusifs. Dans cette troisième édition de son rapport, Facebook distingue 9 catégories de règles concernant la modération de son contenu :

- nudité et activité sexuelle des adultes

- intimidation et harcèlement

- nudité et exploitation sexuelle d’enfants

- faux comptes

- discours haineux

- marchandises réglementées (armes à feu, substances illicites)

- spams, propagande terroriste

- contenus violents et explicites

Les contenus problématiques repérés

Parmi ces catégories, le réseau social dévoile plusieurs indicateurs permettant le suivi de l’évolution de l’application de ses standards de la communauté. On retrouve notamment la prévalence, fréquence à laquelle un contenu abusif a pu être vu par un utilisateur. En effet, bien que la plupart des contenus enfreignant les règles sont automatiquement ou très rapidement supprimés sur Facebook sans qu’aucun utilisateur puisse le voir, il existe encore quelques contenus qui puissent être vus.

Facebook a ainsi déterminé que sur 10 000 contenus vus sur la plateforme :

- 11 à 14 vues concernaient un contenu allant à l’encontre des règles de nudité et d’activité sexuelle des adultes

- 25 vues étaient des contenus jugés violents ou explicites

- Moins de 3 concernaient des contenus jugés comme de la propagande terroriste ou de la nudité et l’exploitation sexuelle d’enfants

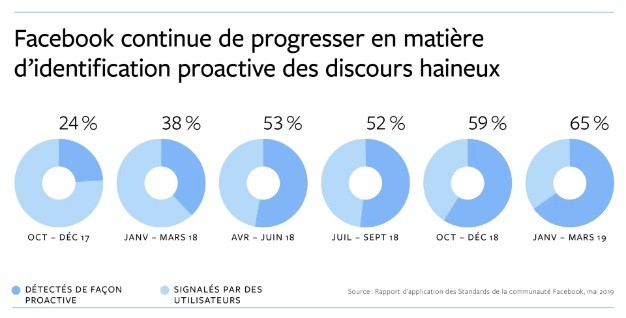

D’autre part, la plateforme estime que 95% des contenus pour lesquels elle a pris des mesures ont été détectés grâce à sa proactivité, c’est-à-dire sa capacité à repérer des contenus problématiques avant même que ceux-ci soient signalés par les utilisateurs. Facebook déclare avoir identifié 65% des discours haineux avec cette technologie.

2,19 milliards de faux comptes supprimés pour le T1 2019

Facebook revient également sur ses actions concernant ces contenus abusifs. « Nos actions comprennent la suppression du contenu, l’ajout d’un filtre d’avertissement ou encore la désactivation des comptes, » détaille le rapport.

Sur la question des comptes, Facebook estime que 5% des comptes actifs sont des faux. La plateforme a ainsi supprimé plus de 1,2 milliard de comptes au T4 2018 et 2,19 milliards au T1 2019.

Facebook explique ces chiffres titanesques : « le nombre de comptes pour lesquels nous avons pris des mesures a augmenté en raison d’attaques automatisées d’acteurs malveillants qui tentent de créer un grand nombre de comptes en même temps« . La plateforme précise en outre que la plupart de ces comptes ont été supprimés très rapidement, parfois quelques minutes après leur création.

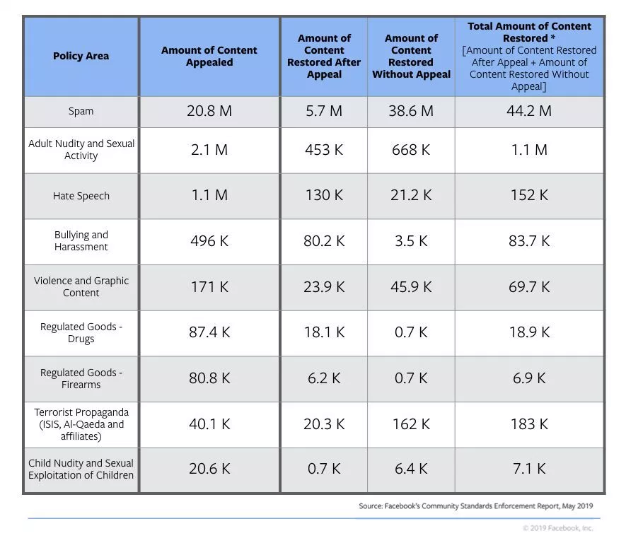

Faux positifs et correction d’erreurs

Facebook indique également dans son rapport la quantité de contenus ayant été rétablis après avoir fait l’objet d’un recours « et la quantité de contenus que nous avons rétablis par nous-mêmes, même si le contenu n’a pas directement fait l’objet d’un recours. »

« La quantité de contenus ayant fait l’objet d’un recours au cours d’un trimestre ne peut pas être directement comparé à la quantité de contenus rétablis au cours de ce trimestre, indique Facebook, dans la mesure où les contenus rétablis au cours du premier trimestre 2019 peuvent avoir fait l’objet d’un recours au quatrième trimestre 2018. De la même manière, la quantité de contenus ayant fait l’objet d’un recours au premier trimestre 2019 pourrait avoir fait l’objet de mesures au quatrième trimestre 2018. »

La boîte à questions sur l'IA générative

Outils, prompts, usages professionnels, comparatifs... Posez toutes vos questions à Ludovic Salenne, expert IA !

Je pose une question