Facebook défend sa politique de modération, face aux accusations du New York Times

Quand on attaque Facebook, Facebook contre-attaque. Le réseau social répond aux accusations du New York Times, qui critique le processus de modération des contenus.

Une modération désorganisée, complexe et imparfaite

Le journal a publié un article d’investigation documenté qui détaille l’organisation de la modération chez Facebook. Le New York Times décrit un mécanisme désorganisé, inefficace et déséquilibré. Les journalistes se basent sur 1400 pages de documents internes, fournis par un salarié craignant que le pouvoir de Facebook soit trop fort – et les erreurs trop nombreuses.

La modération, c’est compliqué : le réseau social doit mettre en place un système capable de repérer les contenus répréhensibles, tout en garantissant la liberté d’expression. Dans les faits, il semblerait que certains contenus légitimes soient censurés et que d’autres, bien plus extrémistes, passent à travers les mailles du filet dans certains pays. Le New York Times cite plusieurs exemples : une collecte de fonds pour les victimes d’une éruption volcanique censurée en Indonésie, et bien évidemment l’inaction du réseau social vis-à-vis du génocide en Birmanie (Myanmar).

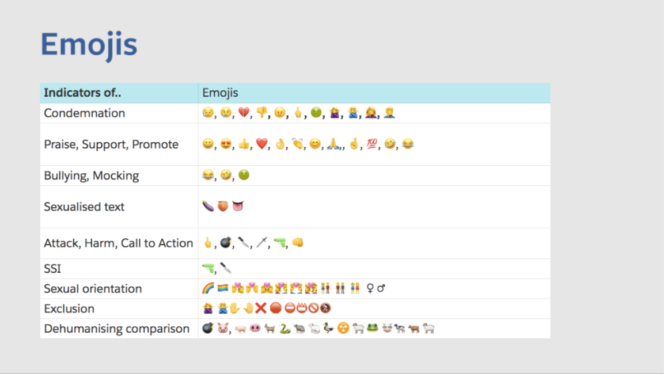

Ces erreurs viendraient du processus de modération. Facebook cherche à donner des réponses binaires (contenu légitime ou pas) à des questions complexes. Les règles seraient dictées par « de jeunes ingénieurs et avocats » et transmises à des sous-traitants « qui recrutent de nombreux modérateurs non-qualifiés, souvent débauchés dans les centres d’appels ». Ils utiliseraient fréquemment les traductions approximatives de Google Translate pour comprendre les contenus et choisir s’ils ont, ou non, leur place sur la plateforme. Ils ne se baseraient pas sur une classification claire des choix à effectuer en fonction de la nature des contenus, mais sur « des douzaines de présentations PowerPoint et tableurs Excel ». On apprend même aux modérateurs à interpréter les emojis, comme le montre ce document obtenu par le New York Times.

L’ingérence russe dans les élections américaines fait partie des scandales Facebook de l’année 2018. Le New York Times consacre une longue partie de son papier à l’impact politique du réseau social dans le monde entier. Aux États-Unis évidemment, mais aussi au Pakistan, en Inde, en Birmanie… Les groupes politiques qui n’ont pas le droit de siéger sur Facebook – principalement des groupes extrémistes louant l’usage de la violence ou du terrorisme – sont consignés dans un tableau Excel, ainsi que les éléments qui permettent de les repérer (symboles, slogans, drapeaux…). Mais il n’est pas toujours simple, pour un modérateur, de comprendre si une publication doit être supprimée ou non : le simple fait de mentionner un groupe terroriste, par exemple, ne devrait pas être censuré. Le sens du message est parfois compliqué à comprendre. Pour les modérateurs, il peut être tentant d’avoir la censure facile : « vous avez l’impression d’avoir tué quelqu’un quand vous n’agissez pas » avoue un modérateur, sous couvert d’anonymat. L’impact psychologique sur les modérateurs pose évidemment question.

Facebook défend sa politique « publique » de modération

Face aux accusations du New York Times, le réseau social a – une fois de plus – été très réactif. Facebook s’est fendu d’un communiqué pour soutenir sa politique de modération.

Facebook explique notamment que ses principes, permettant de juger la légitimité d’un contenu, sont publics. Ils ne sont pas secrets : le réseau social propose effectivement un site dédié aux standards de la communauté. Ces directives ont été rendues publiques en avril dernier. Les modérateurs utilisent sans doute d’autres documents, plus complets, en interne – un peu comme les quality raters de Google, qui jugent de la pertinence des résultats de recherche.

Sur la rédaction des règles, le réseau social se défend de laisser la responsabilité des choix à « quelques jeunes ingénieurs et avocats ». Facebook décrit une réunion bimensuelle durant laquelle de nombreux experts, aux spécialités variées, interviennent. Le réseau social publie régulièrement les compte-rendus de ces échanges et communiquera davantage à ce propos en 2019. Objectif : permettre à tous de suivre les modifications des standards de la communauté.

Enfin, Facebook rappelle que son équipe dédiée à la modération est constituée de 30 000 personnes – dont 15 000 modérateurs opérationnels. Le réseau social indique qu’ils sont répartis à travers le monde, pas uniquement au Maroc ou aux Philippines. Ils ne sont pas payés en fonction du nombre de contenus modérés et aucun quota n’est appliqué. Facebook précise aussi que l’usage de Google Translate ne semble pas nécessaire car les modérateurs sont suffisamment formés et soutenus.

Malgré l’ampleur des actions menées par Facebook, celles-ci ne semblent pas toujours suffisantes. Il suffit de regarder le nombre de sujets sur lesquels les choix effectués par Facebook et ses modérateurs posent question. Mais comme le rappelle Monika Bickert, en charge de la modération chez Facebook : « des milliards de publications sont effectuées chaque jour [sur Facebook] » ; avec un tel volume de données, « même avec une modération presque parfaite, les erreurs restent très nombreuses » – et bien souvent problématiques.